Un Sistema Operativo (SO) es el software fundamental que permite que el hardware de tu dispositivo, ya sea un ordenador, tableta o teléfono móvil, funcione y sea utilizable. El Sistema Operativo actúa como intermediario entre el hardware y el software, gestionando los recursos y permitiendo que las aplicaciones y los usuarios interactúen con el sistema de manera eficiente. Puedes compararlo con la mecánica de un coche: no necesitas saber todos los detalles para conducir, pero entender algunos conceptos básicos te será útil en caso de problemas.

Contenidos del tutorial

En este tutorial, cubriremos una amplia variedad de temas clave relacionados con los sistemas operativos. Exploraremos en profundidad los algoritmos de planificación, la creación y control de procesos, los hilos, la memoria virtual, el reemplazo de páginas y la segmentación. También abordaremos conceptos avanzados como la sincronización de procesos, el manejo de interrupciones, la gestión de discos, los sistemas de archivos, los deadlocks, los semáforos, la comunicación entre procesos (IPC), y mucho más. Además, profundizaremos en temas específicos como el uso de sockets en Linux, la gestión de la CPU en sistemas multiprocesador, los problemas de sincronización clásicos como el problema del productor-consumidor y el de los filósofos comensales, así como la gestión de recursos y memoria en sistemas modernos como Linux. Este tutorial está diseñado para ofrecer una comprensión completa y detallada del funcionamiento interno de los sistemas operativos, tanto desde el punto de vista teórico como práctico.

¿Qué es un Sistema Operativo?

Un Sistema Operativo (SO) es un programa que, tras encender el dispositivo, coordina las actividades del hardware y ejecuta otras aplicaciones. El SO permite que múltiples programas se ejecuten simultáneamente de manera eficiente, asegurando que el CPU, la memoria y otros recursos se gestionen adecuadamente.

Funciones clave del Sistema Operativo:

- Gestión de procesos: Coordina la creación, planificación y terminación de procesos.

- Gestión de memoria: Asigna memoria a procesos y libera memoria cuando ya no es necesaria.

- Gestión de almacenamiento: Controla el acceso a discos duros, unidades SSD y otros dispositivos de almacenamiento.

- Gestión de dispositivos de entrada/salida (E/S): Permite la comunicación entre el hardware (impresoras, discos, etc.) y las aplicaciones.

- Gestión de seguridad: Protege los datos y controla el acceso a los recursos del sistema.

Ejemplos de sistemas operativos populares son Windows, Linux, macOS, iOS y Android.

Tipos de Sistemas Operativos

Existen varios tipos de sistemas operativos, cada uno diseñado para cumplir con necesidades específicas:

- Sistemas Operativos de Tiempo Compartido:

- Permiten que múltiples usuarios utilicen el sistema al mismo tiempo. Ejemplo: UNIX.

- Sistemas Operativos en Tiempo Real:

- Ejecutan tareas críticas que deben completarse dentro de plazos específicos. Se utilizan en sistemas embebidos y de control industrial. Ejemplo: VxWorks.

- Sistemas Operativos Distribuidos:

- En estos sistemas, el procesamiento se distribuye entre múltiples máquinas conectadas a través de una red. Los recursos parecen ser un solo sistema unificado para el usuario. Ejemplo: OS de clústeres.

- Sistemas Operativos de Multiprocesamiento:

- Soportan el uso de múltiples procesadores para aumentar el rendimiento. Ejemplo: Linux en sistemas multiprocesador.

- Sistemas Operativos de Monotarea vs Multitarea:

- Monotarea: Solo se ejecuta un programa a la vez (poco común hoy en día).

- Multitarea: Permiten que múltiples aplicaciones se ejecuten simultáneamente. Ejemplo: Windows.

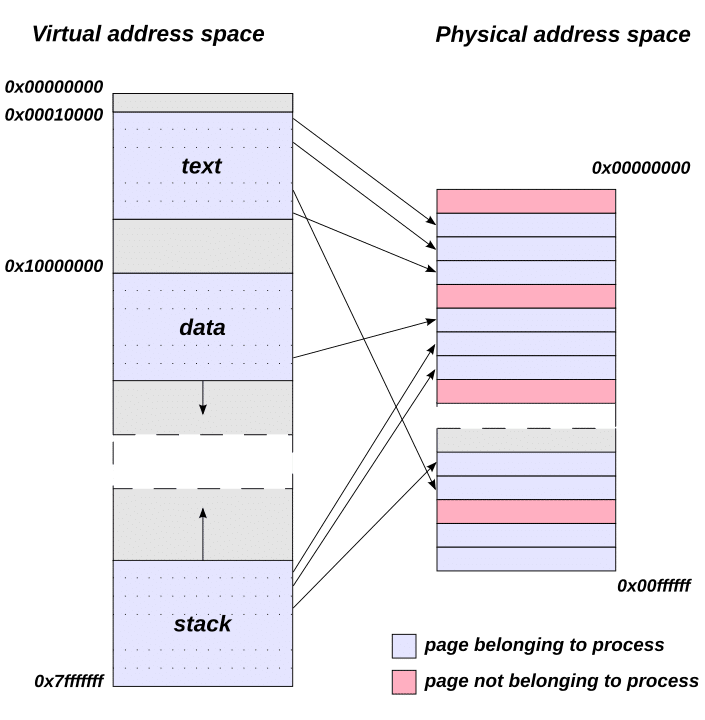

Memoria Virtual en el Sistema Operativo

La memoria virtual es una técnica utilizada por los sistemas operativos para gestionar la memoria de forma eficiente. Permite que los programas se ejecuten como si tuviesen más memoria disponible de la que realmente existe en el hardware físico. Esto se logra utilizando un área de almacenamiento en el disco duro llamada «archivo de paginación» o «swap».

Ventajas de la memoria virtual:

- Ejecución de programas grandes: Los programas que necesitan más memoria que la disponible en la RAM pueden ejecutarse dividiendo su espacio de direcciones.

- Aislamiento de procesos: Cada proceso tiene su propio espacio de memoria virtual, evitando interferencias entre procesos.

- Mejor utilización de la memoria: El sistema puede cargar solo las partes necesarias de un programa en la memoria física.

Reemplazo de Páginas en Sistemas Operativos

El reemplazo de páginas es un concepto clave dentro de la gestión de memoria virtual. Dado que el espacio físico en la RAM es limitado, el sistema operativo debe decidir qué páginas (bloques de memoria) se deben reemplazar cuando la memoria está llena.

Algoritmos de reemplazo de páginas comunes:

- FIFO (First In, First Out): La página más antigua se reemplaza primero.

- LRU (Least Recently Used): Reemplaza la página que no ha sido utilizada por más tiempo.

- Óptimo: Reemplaza la página que no se necesitará por el mayor tiempo en el futuro (ideal, pero imposible de implementar sin conocer el futuro).

- Second Chance: Variante de FIFO que da una «segunda oportunidad» a las páginas que han sido referenciadas recientemente.

Cada algoritmo tiene sus ventajas y desventajas en términos de rendimiento y eficiencia de memoria.

Segmentación en Sistemas Operativos

La segmentación es otra técnica de gestión de memoria utilizada en los sistemas operativos. A diferencia de la paginación, donde la memoria se divide en bloques de tamaño fijo (páginas), en la segmentación, la memoria se divide en segmentos de longitud variable según las necesidades de cada proceso.

Cada segmento puede representar una unidad lógica del programa, como el código, los datos o la pila. Esta técnica permite que los procesos se estructuren de manera más flexible y facilita la gestión de grandes proyectos de software.

Ventajas de la segmentación:

- Mejora la organización lógica de los programas.

- Facilita la protección y el aislamiento de memoria entre diferentes segmentos.

- Optimiza el uso de la memoria al permitir que los segmentos solo crezcan o se reduzcan según sea necesario.

¿Cómo arranca un PC?

El proceso de arranque de un PC es el procedimiento que sigue una computadora para iniciar su sistema operativo desde que se enciende hasta que está lista para ser usada. Este proceso involucra varias etapas clave:

- Encendido (Power On): Cuando se enciende el PC, la corriente fluye hacia los componentes del sistema, y la CPU se activa.

- POST (Power-On Self-Test): El BIOS/UEFI realiza una serie de pruebas de diagnóstico conocidas como POST. Estas pruebas verifican el correcto funcionamiento del hardware (como la RAM, la CPU y los dispositivos de almacenamiento).

- BIOS/UEFI: El BIOS (o UEFI en sistemas más modernos) busca un dispositivo de arranque (generalmente un disco duro o una unidad de estado sólido) que contenga un sistema operativo.

- Carga del MBR: Una vez que el dispositivo de arranque es encontrado, el control se transfiere al Master Boot Record (MBR) o al sistema de particiones GPT.

- Cargador de Arranque (Bootloader): El MBR carga el gestor de arranque, como GRUB o el cargador de Windows, que se encarga de cargar el kernel del sistema operativo.

- Carga del Sistema Operativo: Finalmente, el sistema operativo es cargado en la memoria, y los servicios básicos del sistema comienzan a funcionar. La máquina está lista para ser utilizada.

¿Qué es la BIOS?

El BIOS (Basic Input/Output System) es el firmware esencial que se almacena en un chip de la placa base de un ordenador y que inicia el proceso de arranque de un PC. El BIOS proporciona la interfaz básica para que el sistema pueda comunicarse con el hardware del ordenador y verificar su correcto funcionamiento antes de cargar el sistema operativo.

Funciones clave del BIOS:

- POST (Power-On Self-Test): Verifica que el hardware esté funcionando correctamente al arrancar el sistema.

- Configuración del hardware: Permite modificar ajustes de hardware, como el orden de arranque, la configuración de los discos duros, y el comportamiento de las interfaces de E/S.

- Cargador del Sistema Operativo: El BIOS localiza el cargador de arranque en el dispositivo de almacenamiento para que el sistema operativo pueda ser cargado.

Los sistemas modernos han reemplazado el BIOS por el UEFI (Unified Extensible Firmware Interface), que tiene más funcionalidades y es más flexible.

¿Qué es el Master Boot Record?

El Master Boot Record (MBR) es el primer sector de un disco duro o una unidad SSD. Este pequeño fragmento de código es crucial porque contiene la información sobre las particiones del disco y una parte del gestor de arranque del sistema operativo.

Componentes clave del MBR:

- Código de arranque: Un pequeño programa que carga el sistema operativo desde el dispositivo de almacenamiento.

- Tabla de particiones: Una tabla que describe cómo está dividido el disco (particiones) y cuál de esas particiones contiene el sistema operativo.

- Firma del disco: Un identificador único para el disco.

El MBR tiene un límite en cuanto al tamaño de los discos (máximo 2 TB), y ha sido reemplazado en muchos sistemas modernos por el sistema de particiones GPT (GUID Partition Table).

Semáforos en el SO

Los semaforos son mecanismos de sincronización utilizados en los sistemas operativos para gestionar el acceso concurrente a recursos compartidos por múltiples procesos o hilos. Un semáforo puede tener dos variantes principales:

- Semáforo binario: Solo puede tomar los valores 0 o 1. Funciona de manera similar a un candado, permitiendo que un solo proceso acceda a un recurso a la vez.

- Semáforo de conteo: Puede tomar un valor no negativo que representa la cantidad de recursos disponibles. Por ejemplo, si hay tres instancias de un recurso disponible, el valor del semáforo sería 3, y se reduce a medida que los procesos adquieren el recurso.

Funciones comunes de los semáforos:

- wait() o P(): Disminuye el valor del semáforo. Si el valor es negativo, el proceso se bloquea hasta que el recurso esté disponible.

- signal() o V(): Aumenta el valor del semáforo, indicando que un recurso está disponible.

Los semáforos son esenciales para evitar condiciones de carrera y garantizar la exclusión mutua.

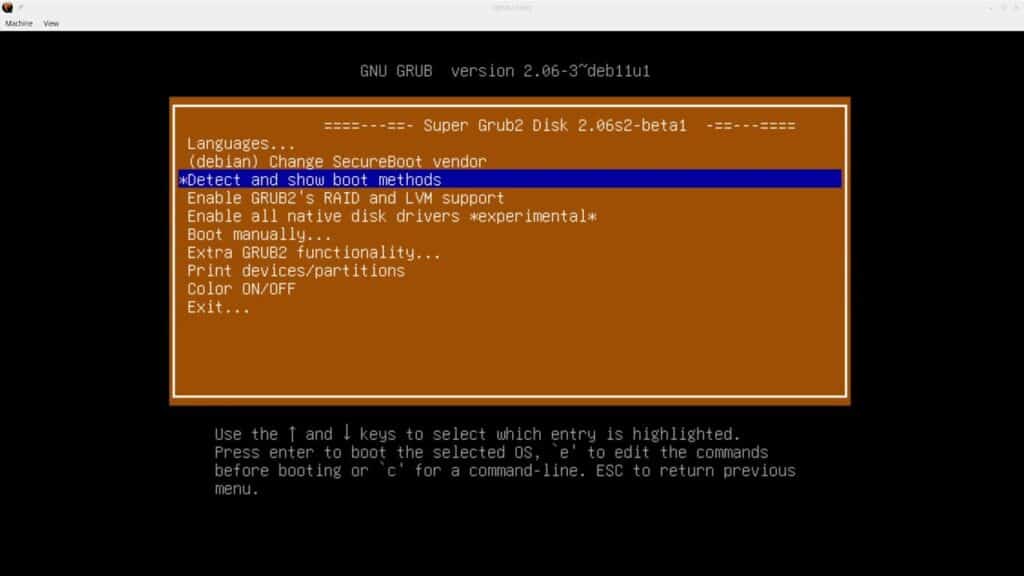

¿Qué es el arranque en un sistema operativo?

El proceso de arranque (booting) es el procedimiento mediante el cual un sistema operativo se carga en la memoria del ordenador después de que la máquina ha sido encendida o reiniciada. El arranque se divide en dos tipos:

- Arranque en frío (Cold Boot): Ocurre cuando el ordenador se enciende desde un estado completamente apagado.

- Arranque en caliente (Warm Boot): Ocurre cuando el sistema operativo reinicia el ordenador sin cortar la alimentación.

Durante el arranque, el sistema pasa por varias etapas, incluyendo la ejecución del BIOS o UEFI, la carga del gestor de arranque y, finalmente, la carga del kernel del sistema operativo en la RAM.

Deadlock en el Sistema operativo

Un deadlock (bloqueo mutuo) es una situación en los sistemas operativos donde dos o más procesos quedan atrapados en un ciclo de espera infinita porque cada uno está esperando que otro libere un recurso que necesita. Esto ocurre cuando se cumplen las siguientes cuatro condiciones simultáneamente:

- Mutua exclusión: Al menos un recurso debe estar en modo no compartido, es decir, un proceso lo posee exclusivamente.

- Retención y espera: Un proceso que ya posee un recurso puede solicitar recursos adicionales y esperar mientras mantiene sus recursos actuales.

- No apropiación: Un recurso no puede ser forzado a ser liberado de un proceso; solo puede liberarse voluntariamente.

- Espera circular: Debe existir una cadena de dos o más procesos en la que cada proceso esté esperando un recurso que tiene otro proceso de la cadena.

Para evitar los deadlocks, los sistemas operativos implementan varias estrategias, como la prevención (asegurando que una de las condiciones no se cumpla), detección y recuperación.

Creación de Procesos y Llamadas al Sistema

La creación de procesos es una operación clave en los sistemas operativos, que permite que las aplicaciones y programas se ejecuten. Un proceso es una instancia de un programa en ejecución, y su creación involucra varias etapas importantes:

- Inicialización: El sistema operativo crea una estructura de datos llamada Process Control Block (PCB) para almacenar información sobre el proceso, como su estado y registros.

- Asignación de recursos: El proceso recibe memoria y otros recursos necesarios para su ejecución.

- Carga del programa: El sistema operativo carga el código del programa y los datos necesarios en la memoria.

- Ejecución: El proceso es programado para ejecutarse por el planificador del sistema operativo.

La creación de procesos suele involucrar llamadas al sistema como fork() en sistemas UNIX, que genera un nuevo proceso copiando el proceso actual. Otras llamadas importantes son exec() para reemplazar el contenido de un proceso con uno nuevo, y wait(), que pausa la ejecución de un proceso hasta que uno de sus hijos termine.

Comunicación Entre Procesos (IPC)

La Comunicación entre Procesos (IPC) permite que diferentes procesos en un sistema operativo intercambien datos y se sincronicen. Los procesos pueden estar ejecutándose en el mismo sistema o en sistemas distribuidos. Los métodos más comunes de IPC incluyen:

- Tubos (Pipes): Permiten la comunicación unidireccional entre dos procesos relacionados.

- Colas de mensajes: Proporcionan un mecanismo para intercambiar mensajes entre procesos, de manera asincrónica.

- Memoria compartida: Dos o más procesos pueden acceder a una misma región de memoria, lo que permite una comunicación extremadamente rápida.

- Semáforos y señales: Usados para sincronizar procesos y evitar condiciones de carrera.

- Sockets: Especialmente útiles para la comunicación entre procesos en diferentes máquinas conectadas a una red.

El IPC es fundamental para tareas en sistemas multiprocesadores, donde los procesos deben coordinarse y comunicarse para evitar errores y optimizar el rendimiento.

Bloque de Control de Procesos (PCB) en el Sistema Operativo

El Process Control Block (PCB) es una estructura de datos que mantiene información esencial sobre un proceso en ejecución dentro del sistema operativo. El PCB incluye lo siguiente:

- ID del proceso: Un identificador único para cada proceso.

- Estado del proceso: Indica si el proceso está en ejecución, en espera o finalizado.

- Contador de programa: Almacena la dirección de la siguiente instrucción a ejecutar.

- Registros: Información sobre los registros de la CPU.

- Información de memoria: Direcciones de memoria y espacio asignado al proceso.

- Información sobre I/O: Datos sobre los dispositivos de entrada y salida asociados al proceso.

El PCB es crucial para la administración de los procesos, ya que permite al sistema operativo realizar un seguimiento de los procesos activos y restaurar su contexto cuando se reanudan después de una interrupción.

Estado de un Proceso en el Sistema Operativo

Un proceso en un sistema operativo puede encontrarse en uno de los siguientes estados, dependiendo de su etapa de ejecución:

- Nuevo: El proceso ha sido creado pero aún no está en ejecución.

- En ejecución (Running): El proceso está siendo ejecutado en el CPU.

- Bloqueado (Waiting): El proceso está en espera de algún evento externo, como la entrada de datos.

- Listo (Ready): El proceso está esperando ser asignado a un CPU.

- Finalizado (Terminated): El proceso ha completado su ejecución.

El cambio entre estos estados es gestionado por el planificador del sistema operativo, que decide qué procesos deben ejecutarse en función de varios criterios, como prioridad y equidad.

Llamadas al Sistema en el Sistema Operativo

Las llamadas al sistema son el mecanismo mediante el cual los programas de usuario interactúan con el núcleo del sistema operativo. Proporcionan una interfaz para que los programas realicen tareas privilegiadas, como acceder a hardware o gestionar procesos.

Ejemplos comunes de llamadas al sistema incluyen:

- Llamadas de proceso:

fork(),exec(),wait(),exit(). - Llamadas de archivo:

open(),read(),write(),close(). - Llamadas de comunicación:

socket(),send(),recv(). - Llamadas de control de dispositivos:

ioctl()para operaciones específicas de dispositivos de hardware.

Estas llamadas al sistema son esenciales para la interacción entre el hardware y el software, permitiendo a los programas realizar tareas sin acceder directamente a los recursos de bajo nivel.

Hilos en el Sistema Operativo

Un hilo (thread) es la unidad más pequeña de procesamiento que puede ser programada por el sistema operativo. Mientras que un proceso tiene su propio espacio de memoria, un hilo comparte el espacio de memoria del proceso principal, lo que permite realizar múltiples tareas de manera más eficiente dentro de un mismo proceso.

Tipos de hilos:

- Hilos de usuario: Gestionados por las bibliotecas de los programas, sin intervención del núcleo del sistema operativo.

- Hilos de kernel: Gestionados directamente por el núcleo del sistema operativo, con acceso total a los recursos del sistema.

Ventajas de los hilos:

- Mayor eficiencia: Los hilos permiten una mejor utilización de los recursos de CPU, ya que pueden ejecutar tareas en paralelo.

- Menor sobrecarga: Crear un hilo consume menos recursos que crear un proceso completo.

- Comunicación eficiente: Al compartir el mismo espacio de memoria, los hilos pueden comunicarse más rápido que los procesos independientes.

Los hilos son fundamentales en aplicaciones que requieren multitarea, como servidores web, donde múltiples peticiones pueden ser procesadas simultáneamente por diferentes hilos.

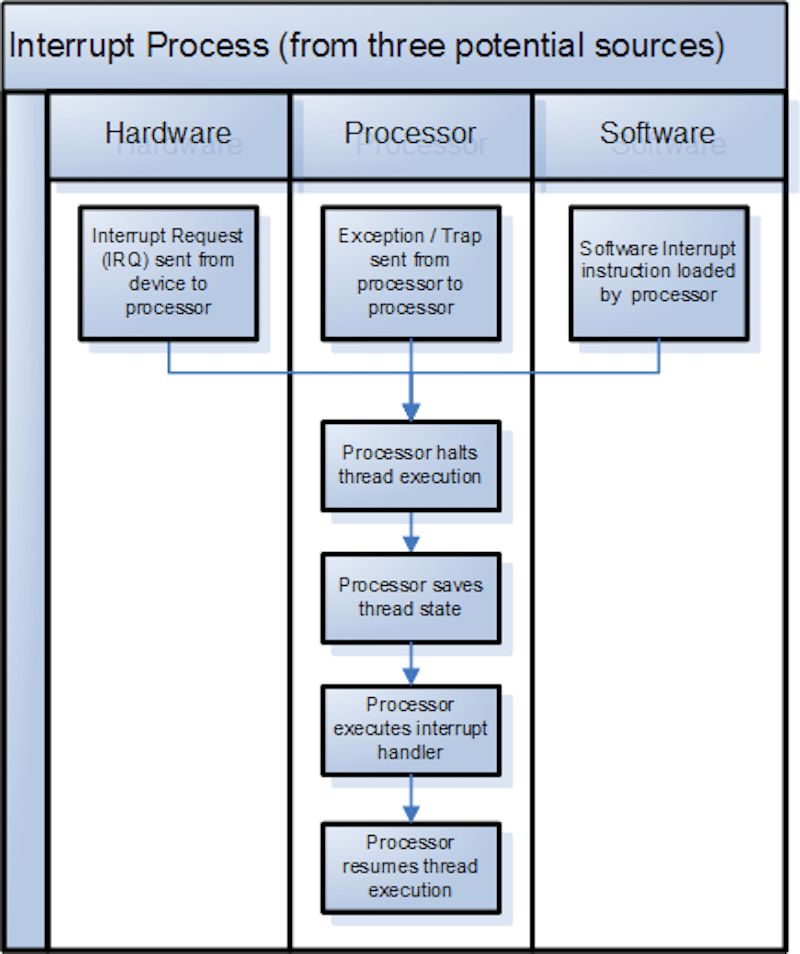

Interrupciones en el Sistema Operativo (OS)

Las interrupciones son señales enviadas al procesador por parte del hardware o software para indicarle que detenga temporalmente su tarea actual y ejecute una tarea más urgente. Son una parte esencial de la arquitectura de los sistemas operativos, ya que permiten una respuesta rápida a eventos importantes, como la llegada de datos o errores de hardware.

Existen dos tipos principales de interrupciones:

- Interrupciones de hardware: Generadas por dispositivos externos como teclados, discos duros, o tarjetas de red. Por ejemplo, cuando se presiona una tecla, el teclado envía una señal de interrupción para que el sistema operativo procese la entrada.

- Interrupciones de software: También conocidas como excepciones, son generadas por instrucciones en el código que interrumpen el flujo normal de ejecución del programa, como una división por cero o una llamada al sistema.

Introducción a las Interrupciones en el Sistema Operativo

Las interrupciones son mecanismos clave en un sistema operativo para manejar eventos asíncronos, lo que permite al procesador atender rápidamente diferentes solicitudes sin estar pendiente constantemente de cada dispositivo o proceso. El uso de interrupciones asegura que el CPU pueda realizar múltiples tareas de manera eficiente.

Cuando ocurre una interrupción, el CPU suspende temporalmente la ejecución del programa actual y transfiere el control a un manejador de interrupciones que trata la situación. Después de atender la interrupción, el sistema vuelve al estado anterior y continúa con la ejecución normal del programa.

Manejo de Interrupciones

El manejo de interrupciones es el proceso mediante el cual el sistema operativo responde a una interrupción. Este proceso sigue una secuencia estructurada:

- Detección de la interrupción: El hardware notifica al CPU sobre una interrupción pendiente.

- Guardado del contexto: Antes de atender la interrupción, el estado actual del CPU (como los registros y el contador de programa) se guarda para poder reanudar la ejecución posteriormente.

- Invocación del manejador de interrupciones: Se llama a la rutina de servicio de interrupción (ISR) específica para manejar la interrupción.

- Tratamiento de la interrupción: El ISR realiza las acciones necesarias, como leer datos del dispositivo o atender un error de software.

- Restauración del contexto: Una vez manejada la interrupción, el estado del CPU se restaura para que el proceso interrumpido pueda continuar donde fue detenido.

El manejador de interrupciones es una rutina específica diseñada para cada tipo de interrupción. Su eficiencia es crítica para el rendimiento global del sistema operativo, ya que asegura que el CPU no pierda tiempo valioso en tareas no prioritarias.

Cambio de Contexto en el Sistema Operativo (Context Switching)

El cambio de contexto ocurre cuando el sistema operativo cambia entre dos procesos o hilos en ejecución. Esto implica guardar el estado del proceso actual (como los registros, el contador de programa, y otras variables críticas) y restaurar el estado de otro proceso para que pueda continuar su ejecución.

El cambio de contexto es fundamental en sistemas multitarea, donde varios procesos deben compartir el tiempo de CPU. Este mecanismo permite que el sistema operativo administre de manera eficiente múltiples procesos y garantice que todos reciban tiempo suficiente de CPU.

Pasos del cambio de contexto:

- Guardar el contexto del proceso actual: El estado del proceso en ejecución, que incluye registros de CPU, la pila y otros parámetros, se guarda en su PCB.

- Seleccionar el siguiente proceso: El planificador del sistema operativo elige el siguiente proceso a ejecutarse, generalmente basado en su política de planificación (FIFO, Round Robin, etc.).

- Cargar el contexto del nuevo proceso: El estado del nuevo proceso se restaura desde su PCB.

- Reanudar la ejecución: El CPU comienza a ejecutar el nuevo proceso desde el punto donde fue suspendido.

El cambio de contexto puede introducir una sobrecarga en el sistema, ya que requiere tiempo para guardar y restaurar los estados de los procesos. Sin embargo, es esencial para proporcionar una experiencia multitarea fluida.

Planificación de CPU en el Sistema Operativo (OS)

La planificación de la CPU es uno de los aspectos más cruciales en el diseño de un sistema operativo. Se refiere al proceso mediante el cual el sistema operativo selecciona qué proceso o hilo debe utilizar la CPU en un momento determinado. En un entorno multitarea, varios procesos compiten por el tiempo de CPU, y el sistema operativo necesita decidir cuál debe ejecutarse primero para optimizar el uso de los recursos.

El objetivo principal de la planificación de CPU es mejorar la eficiencia general del sistema, reducir el tiempo de espera de los procesos y maximizar la utilización de la CPU. Existen varios criterios de planificación como el tiempo de respuesta, el rendimiento (throughput), la utilización de la CPU, y el tiempo de retorno (turnaround time).

Planificación de la CPU en el Sistema Operativo

La planificación de CPU se realiza utilizando algoritmos de planificación que el sistema operativo implementa para asignar tiempo de CPU a los procesos. Un buen algoritmo de planificación debe equilibrar varios factores para garantizar la eficiencia, como la equidad entre procesos, la minimización de los tiempos de espera, y la priorización correcta de los procesos críticos.

Algunos de los objetivos de la planificación de CPU son:

- Maximizar la utilización de la CPU.

- Minimizar el tiempo de espera de los procesos.

- Garantizar una ejecución justa para todos los procesos.

- Maximizar el rendimiento global del sistema.

Algoritmos de Planificación en el Sistema Operativo

Existen diferentes algoritmos de planificación de CPU que los sistemas operativos utilizan según las necesidades del sistema y los procesos. A continuación se presentan algunos de los algoritmos más comunes:

- First-Come, First-Served (FCFS): El primer proceso que llega a la cola de la CPU es el primero en ser atendido. Aunque es sencillo, puede generar tiempos de espera largos para algunos procesos debido al efecto conocido como «convoy».

- Shortest Job Next (SJN): También conocido como Shortest Job First (SJF), este algoritmo selecciona el proceso con el menor tiempo estimado de ejecución. Aunque puede reducir el tiempo promedio de espera, requiere que el tiempo de ejecución de cada proceso sea conocido o estimado de antemano.

- Round Robin (RR): Este es un algoritmo preemptivo en el que cada proceso recibe un «quantum» o tiempo limitado para ejecutar. Si no finaliza durante ese tiempo, se mueve al final de la cola, lo que permite una asignación equitativa del tiempo de CPU entre los procesos.

- Priority Scheduling: Cada proceso tiene una prioridad asignada, y la CPU se asigna al proceso con la prioridad más alta. Este esquema puede ser preemptivo o no preemptivo, y uno de sus principales problemas es el starvation, donde un proceso de baja prioridad nunca se ejecuta.

- Multilevel Queue Scheduling: En este enfoque, los procesos se dividen en varias colas, cada una con diferentes niveles de prioridad. Cada cola puede tener su propio algoritmo de planificación, y los procesos se mueven entre colas según ciertos criterios.

¿Qué es un Gestor de Arranque (Bootloader) en un Sistema Operativo?

El gestor de arranque o bootloader es un programa esencial en cualquier sistema operativo. Es responsable de cargar el sistema operativo en la memoria cuando se enciende el ordenador. Actúa como un intermediario entre el firmware (como la BIOS o UEFI) y el sistema operativo, iniciando el proceso de arranque.

Durante el arranque, el gestor de arranque carga el kernel del sistema operativo y, en algunos casos, permite al usuario elegir entre diferentes sistemas operativos instalados en el dispositivo. Ejemplos comunes de gestores de arranque incluyen GRUB (para sistemas Linux) y Windows Boot Manager.

Procesos en el Sistema Operativo

Un proceso en un sistema operativo es una instancia en ejecución de un programa. Se compone del código ejecutable, los datos asociados, y el contexto del CPU, lo que incluye registros y memoria. Los procesos son el núcleo del funcionamiento del sistema operativo, ya que todo programa en ejecución es un proceso.

Un proceso pasa por varios estados durante su ciclo de vida: nuevo, listo, en ejecución, esperando, y terminado. La gestión eficiente de los procesos es crucial para el rendimiento general del sistema operativo.

Prevención de Bloqueos (Deadlock) en el Sistema Operativo

Un deadlock (o bloqueo) en un sistema operativo ocurre cuando un grupo de procesos se bloquea porque cada uno de ellos está esperando que otro libere un recurso que necesita para continuar. Ninguno de los procesos puede avanzar, lo que resulta en un bloqueo total.

Existen varias estrategias para prevenir deadlocks en los sistemas operativos:

- Evitar la condición de exclusión mutua: Permitir que varios procesos utilicen los recursos compartidos simultáneamente, siempre que sea posible.

- Prevenir la espera circular: Establecer un orden jerárquico de asignación de recursos para evitar que los procesos se queden esperando en un ciclo.

- Evitar la retención y espera: Asegurar que los procesos no puedan retener recursos mientras esperan por otros. Esto se logra forzando a los procesos a solicitar todos los recursos que necesitarán al principio.

- Interrupción forzada: En situaciones donde no se puede evitar el deadlock, el sistema puede seleccionar uno o más procesos y liberar sus recursos, forzando su terminación o reanudación.

Sincronización en el Sistema Operativo (OS)

La sincronización en los sistemas operativos se refiere a la coordinación de múltiples procesos o hilos para asegurar que compartan recursos de manera adecuada, sin conflictos ni interferencias. Dado que los procesos pueden ejecutarse en paralelo, la sincronización es fundamental para evitar condiciones de carrera y garantizar la integridad de los datos.

El objetivo principal de la sincronización es controlar el acceso concurrente a los recursos compartidos, como archivos o variables, para evitar inconsistencias. Se utilizan varios mecanismos como semáforos, mutexes y barreras para gestionar la sincronización entre los procesos.

Problema del Productor y Consumidor en el Sistema Operativo

El problema del productor y consumidor es un clásico problema de sincronización en los sistemas operativos. Implica dos tipos de procesos: productores, que generan datos o elementos y los colocan en un buffer compartido, y consumidores, que extraen elementos del buffer para procesarlos. El desafío es asegurar que el productor no agregue datos cuando el buffer esté lleno y que el consumidor no intente extraer datos cuando el buffer esté vacío.

Se resuelve típicamente utilizando semáforos y mecanismos de sincronización como los mutexes para gestionar el acceso al buffer compartido, evitando condiciones de carrera y asegurando la integridad de los datos.

Sincronización de Procesos en el Sistema Operativo

La sincronización de procesos garantiza que varios procesos o hilos que comparten recursos trabajen juntos sin causar interferencias. Es fundamental en un entorno multitarea donde los procesos pueden ejecutarse simultáneamente y acceder a los mismos recursos.

Para manejar la sincronización de procesos, se utilizan mecanismos como:

- Semáforos: Variables que ayudan a controlar el acceso a los recursos compartidos.

- Mutexes: Bloqueos exclusivos que garantizan que solo un proceso acceda a un recurso en un momento determinado.

- Monitores: Estructuras de alto nivel que facilitan la sincronización.

Mutex en el Sistema Operativo

Un mutex (del inglés «mutual exclusion» o exclusión mutua) es un mecanismo utilizado en la programación concurrente para evitar que más de un proceso o hilo acceda a una sección crítica de código o a un recurso compartido al mismo tiempo. El mutex actúa como un candado: cuando un proceso adquiere el mutex, bloquea el acceso a la sección crítica para otros procesos hasta que lo libere.

El uso de mutexes es crucial para prevenir condiciones de carrera y garantizar que los datos se manipulen correctamente en un entorno multitarea.

Gestión de Discos en el Sistema Operativo

La gestión de discos en un sistema operativo se refiere a la organización y manipulación eficiente de los datos almacenados en el disco duro u otros dispositivos de almacenamiento. Esto incluye tareas como la asignación de espacio, la gestión de archivos, la planificación de E/S y la implementación de sistemas de archivos.

El sistema operativo debe gestionar cómo se almacenan los archivos, cómo se recuperan y cómo se organizan los datos en sectores, clústeres o bloques. Algunos de los principales enfoques de gestión de discos incluyen la planificación de discos, el almacenamiento en caché y la fragmentación.

Problema de los Filósofos Comensales en el Sistema Operativo

El problema de los filósofos comensales es un problema de sincronización que ilustra la dificultad de gestionar el acceso compartido a recursos limitados. En este caso, cinco filósofos comparten una mesa y necesitan tanto pensar como comer, pero solo hay cinco tenedores. Cada filósofo necesita dos tenedores para comer, por lo que el reto es evitar que todos tomen un solo tenedor, lo que podría resultar en un deadlock.

Este problema se resuelve mediante el uso de mecanismos como los semáforos y los mutexes para coordinar el acceso a los tenedores y evitar la espera circular que lleva al deadlock.

Algoritmo de Planificación por Prioridad

El algoritmo de planificación por prioridad asigna la CPU a los procesos en función de su prioridad. Cada proceso recibe una prioridad, y la CPU se asigna al proceso con la prioridad más alta. En sistemas no apropiativos, el proceso en ejecución continúa hasta que finaliza, mientras que en sistemas apropiativos, el sistema operativo puede interrumpir un proceso en ejecución si otro con mayor prioridad llega.

El principal desafío de este algoritmo es el starvation, donde los procesos de baja prioridad pueden no recibir nunca la CPU. Para mitigar esto, se puede utilizar la técnica de envejecimiento, que incrementa gradualmente la prioridad de un proceso a medida que espera más tiempo.

Prevención de Bloqueos en el Sistema Operativo

La prevención de bloqueos se refiere a las técnicas utilizadas para asegurarse de que un sistema operativo nunca entre en un estado de deadlock. Existen varias estrategias para prevenir bloqueos:

- Evitar la espera circular: Establecer un orden total en la solicitud de recursos para que los procesos no caigan en un ciclo de espera.

- Asignación anticipada de recursos: Exigir que los procesos soliciten todos los recursos necesarios al inicio de su ejecución, evitando que mantengan recursos mientras esperan otros.

- Liberación forzada: Si un proceso no puede obtener todos los recursos que necesita, debe liberar los que tiene para evitar bloqueos.

Planificación Multiprocesador

En los sistemas multiprocesador, la planificación es más compleja debido a la existencia de múltiples CPUs. El objetivo de la planificación multiprocesador es optimizar el uso de todas las CPUs disponibles, distribuyendo la carga de trabajo entre ellas de manera equilibrada.

Existen varios enfoques para la planificación multiprocesador:

- Planificación acoplada: Un solo planificador gestiona todas las CPUs, distribuyendo los procesos de manera uniforme.

- Planificación desacoplada: Cada CPU tiene su propio planificador y asigna procesos de forma independiente, aunque puede haber transferencia de carga entre procesadores para evitar desequilibrios.

Bloqueos y Hilos en el Sistema Operativo

Los bloqueos (o deadlocks) y los hilos son conceptos críticos en la gestión de procesos dentro de un sistema operativo.

- Bloqueo: Ocurre cuando dos o más procesos quedan en un estado de espera indefinida porque cada uno está esperando que otro libere un recurso. Esto se produce en situaciones de recursos compartidos cuando los procesos no liberan recursos que otros procesos necesitan.

- Hilos: Los hilos son las unidades más pequeñas de procesamiento en el sistema operativo. Son una subdivisión de los procesos y permiten que múltiples tareas se ejecuten simultáneamente dentro del mismo proceso, compartiendo el mismo espacio de memoria.

El reto en la programación concurrente es manejar los recursos compartidos de manera que se eviten los bloqueos y se garantice la correcta sincronización de los hilos.

Algoritmo del Panadero en el Sistema Operativo

El Algoritmo del Panadero es un algoritmo utilizado para resolver el problema de la exclusión mutua en sistemas concurrentes. Fue propuesto por el científico informático Leslie Lamport.

Este algoritmo simula el proceso que seguiría un panadero para atender a sus clientes por orden de llegada, asegurando que solo un proceso acceda a la sección crítica a la vez. Cada proceso recibe un número de «boleto» y espera su turno, garantizando que el acceso a la sección crítica sea justo y sin conflictos.

Es uno de los primeros algoritmos de exclusión mutua, pero no es ampliamente utilizado en la práctica debido a su complejidad comparada con otros mecanismos más eficientes como los semáforos o mutexes.

¿Qué es un Pool de Hilos?

Un Thread Pool (o pool de hilos) es una colección de hilos que están creados y listos para ejecutarse en segundo plano. Cuando una aplicación necesita ejecutar una tarea, en lugar de crear un nuevo hilo, reutiliza uno de los hilos disponibles en el pool, lo que mejora la eficiencia.

Los beneficios de usar un pool de hilos incluyen:

- Reutilización de hilos para evitar el sobrecoste de creación y destrucción.

- Control del número de hilos simultáneos, evitando sobrecargas en el sistema.

- Mejor rendimiento en tareas concurrentes.

Sincronización por Hardware en el Sistema Operativo

La sincronización por hardware es una técnica utilizada para evitar condiciones de carrera en sistemas multiprocesador o multitarea. Las primitivas de hardware proporcionan mecanismos eficientes para garantizar que múltiples procesos o hilos no interfieran entre sí mientras acceden a recursos compartidos.

Algunos de los mecanismos más comunes incluyen:

- Instrucciones de test-and-set: Permiten verificar y modificar un valor de manera atómica.

- Instrucciones de intercambio (swap): Intercambian el valor de dos variables de forma atómica.

- Deshabilitar interrupciones: Durante la ejecución de una sección crítica, se deshabilitan las interrupciones para evitar la preempción de la CPU.

Hilos POSIX en el Sistema Operativo

Los POSIX Threads (o Pthreads) son una implementación estándar de hilos en sistemas operativos que cumplen con las especificaciones POSIX (Portable Operating System Interface). Este estándar define una interfaz para la creación, sincronización y gestión de hilos en un entorno multitarea.

Las principales características de los Pthreads incluyen:

- Portabilidad: Se puede utilizar en sistemas operativos compatibles con POSIX.

- Sincronización: Los Pthreads ofrecen mecanismos de sincronización como mutexes y variables de condición.

- Control de hilos: Permite crear, finalizar y gestionar múltiples hilos en una aplicación.

Planificación de Procesos en Linux

La planificación de procesos en Linux es el mecanismo utilizado para asignar tiempo de CPU a los procesos en ejecución. Linux utiliza varios algoritmos de planificación que buscan optimizar el uso del procesador, la respuesta interactiva y el rendimiento general.

El planificador actual de Linux es el Completely Fair Scheduler (CFS), que introduce el concepto de justicia en la asignación de CPU. CFS distribuye el tiempo de CPU de manera equitativa entre todos los procesos en ejecución, basándose en una cola de ejecución ponderada.

Además de CFS, Linux también admite otras políticas de planificación como FIFO y Round-Robin, especialmente útiles para sistemas en tiempo real.

Diferencia entre Sistemas Multinúcleo y Multiprocesador

- Sistema Multinúcleo: Un multinúcleo (multicore) tiene múltiples núcleos de procesamiento en un único chip. Cada núcleo puede ejecutar tareas de manera independiente, pero comparten la misma memoria y bus. Es eficiente en términos de coste y consumo energético.

- Sistema Multiprocesador: Un sistema multiprocesador tiene varios procesadores físicos, cada uno con su propio chip, y cada procesador puede ejecutar tareas de manera independiente. Estos sistemas son más costosos y complejos que los multinúcleo, pero ofrecen mayor rendimiento.

La principal diferencia es que un sistema multinúcleo agrupa varios núcleos en un solo chip, mientras que los sistemas multiprocesador utilizan varios chips, cada uno con su propio procesador.

Proceso Zombi y Proceso Huérfano en el Sistema Operativo

- Proceso Zombi: Un proceso zombi es un proceso que ha terminado su ejecución pero aún tiene una entrada en la tabla de procesos porque su proceso padre no ha recogido su estado de salida. Aunque ya no utiliza recursos de CPU, el proceso zombi ocupa una entrada en la tabla de procesos.

- Proceso Huérfano: Un proceso huérfano es aquel cuyo proceso padre ha terminado antes de que lo haga el proceso hijo. En estos casos, el proceso huérfano es adoptado por el proceso init (proceso con PID 1), que se encarga de supervisar su terminación.

Los sistemas operativos modernos manejan procesos zombis y huérfanos para liberar adecuadamente los recursos del sistema.

Gestión de Discos en el Sistema Operativo

La gestión de discos en un sistema operativo es el conjunto de técnicas y procesos que permiten al sistema gestionar y organizar el almacenamiento en dispositivos físicos como discos duros, SSDs y unidades extraíbles. Esta gestión incluye la creación, partición, formateo, y mantenimiento de los volúmenes de almacenamiento, permitiendo al sistema operativo y a los usuarios acceder a los datos de manera eficiente y segura.

Funciones clave de la gestión de discos:

- Particionamiento:

- El particionamiento es el proceso de dividir un disco físico en varias secciones, llamadas particiones. Cada partición puede actuar como un disco separado dentro del sistema, con su propio sistema de archivos.

- Existen particiones primarias, extendidas y lógicas. Las particiones primarias son limitadas a cuatro por disco, mientras que las extendidas permiten crear particiones lógicas adicionales.

- Formateo:

- El formateo crea un sistema de archivos en una partición o volumen, preparando el área de almacenamiento para que los datos puedan ser guardados y leídos de manera eficiente. Los sistemas de archivos comunes incluyen FAT32, NTFS, ext4, entre otros.

- El formateo inicial de un disco nuevo es esencial para que el sistema operativo pueda gestionar adecuadamente los archivos almacenados.

- Asignación de espacio:

- Los sistemas operativos asignan bloques de espacio en disco a los archivos de acuerdo con la demanda. Existen distintas estrategias de asignación, como la asignación contigua, enlazada y indexada.

- Fragmentación y desfragmentación:

- Con el tiempo, el almacenamiento en disco puede volverse fragmentado, lo que significa que los archivos se almacenan en múltiples ubicaciones no contiguas, lo que disminuye el rendimiento de lectura/escritura. La desfragmentación reorganiza los datos para optimizar el acceso al disco.

- RAID:

- RAID (Redundant Array of Independent Disks) es una tecnología que combina múltiples discos duros en una unidad lógica para mejorar el rendimiento, la fiabilidad o ambos. Los diferentes niveles de RAID (como RAID 0, RAID 1, RAID 5) tienen distintas ventajas y desventajas.

- Volúmenes lógicos:

- Un volumen lógico es un contenedor virtual que agrupa particiones físicas y las presenta como una unidad lógica. Los sistemas operativos utilizan administradores de volúmenes lógicos (LVM, por sus siglas en inglés) para permitir la expansión de volúmenes sin necesidad de reformatear.

Herramientas de gestión de discos en diferentes sistemas operativos:

- Windows: Herramienta de administración de discos integrada que permite crear, eliminar, formatear particiones y volúmenes.

- Linux: Utilidades como

fdisk,parted, y el Administrador de Volúmenes Lógicos (LVM) son esenciales para la gestión avanzada de discos. - macOS: Utiliza la Utilidad de Discos para la gestión y formateo de discos, incluyendo la configuración de sistemas de archivos como APFS.

Glosario de Términos de Sistemas Operativos

- Proceso: Programa en ejecución, que incluye el código del programa y su estado actual (registros, memoria, etc.).

- Hilo (Thread): La unidad más pequeña de procesamiento en un sistema operativo. Un proceso puede tener múltiples hilos que comparten el mismo espacio de memoria.

- Memoria virtual: Técnica que utiliza espacio en disco para simular memoria RAM adicional, permitiendo a los sistemas ejecutar programas más grandes de lo que permitiría la memoria física.

- Sistema de archivos: Estructura utilizada para organizar y gestionar archivos en un dispositivo de almacenamiento. Ejemplos: NTFS, FAT32, ext4.

- Deadlock (Bloqueo): Situación en la que dos o más procesos están bloqueados indefinidamente porque cada uno espera que otro libere un recurso.

- Semáforo: Variable utilizada en la sincronización de procesos para controlar el acceso a recursos compartidos.

- Planificación de CPU: Algoritmo que el sistema operativo utiliza para asignar tiempo de CPU a los procesos. Ejemplos de algoritmos de planificación: FIFO, Round-Robin, SJF.

- Multitarea: Capacidad de un sistema operativo de ejecutar múltiples tareas (procesos) al mismo tiempo.

- Paginación: Método de administración de memoria en el que se divide la memoria en bloques de tamaño fijo, llamados páginas, que se asignan a procesos según sea necesario.

- Kernel (Núcleo): Parte central de un sistema operativo que gestiona los recursos del sistema (CPU, memoria, dispositivos) y permite la comunicación entre el hardware y el software.

- Interrupción: Señal enviada al procesador que interrumpe la ejecución normal de instrucciones para atender un evento, como una entrada de datos o una señal de hardware.

- Mutex: Objeto de sincronización utilizado para garantizar que solo un hilo acceda a un recurso compartido en un momento dado.

- Sistema de tiempo compartido: Sistema operativo que divide el tiempo de CPU entre múltiples usuarios o tareas, proporcionando la ilusión de simultaneidad.

- Proceso Zombi: Proceso que ha terminado su ejecución pero cuyo estado aún no ha sido recogido por su proceso padre, ocupando una entrada en la tabla de procesos.

- Pthreads: Implementación de hilos en sistemas POSIX, proporcionando una interfaz estándar para la creación y gestión de hilos.

- FIFO (First In, First Out): Estrategia de planificación en la que el primer proceso que llega es el primero en ser ejecutado.

- Round-Robin: Algoritmo de planificación en el que cada proceso recibe una pequeña cantidad de tiempo de CPU, rotando entre todos los procesos en cola.

- Master Boot Record (MBR): Primer sector de un dispositivo de almacenamiento que contiene información sobre cómo están particionados los discos y el código para arrancar el sistema operativo.

- Swap: Espacio en disco utilizado para almacenar datos de procesos cuando la memoria RAM está llena, permitiendo que el sistema continúe ejecutando otros procesos.

Este tutorial cubre los conceptos esenciales de los sistemas operativos, pero también hay otros temas avanzados como la planificación de procesos, gestión de archivos y hilos que forman la base de un SO eficiente.