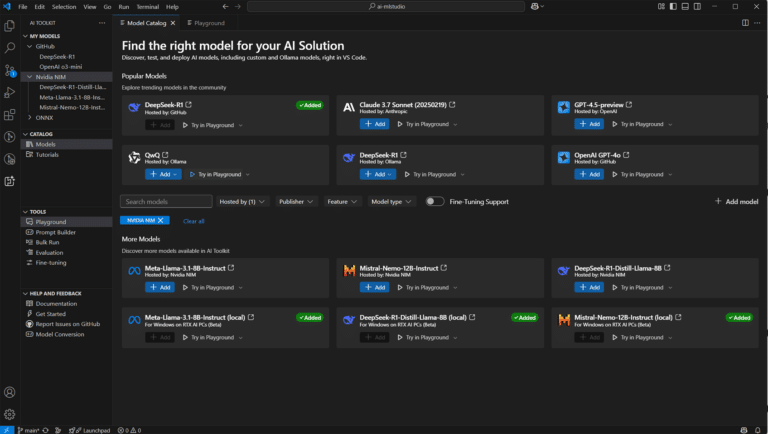

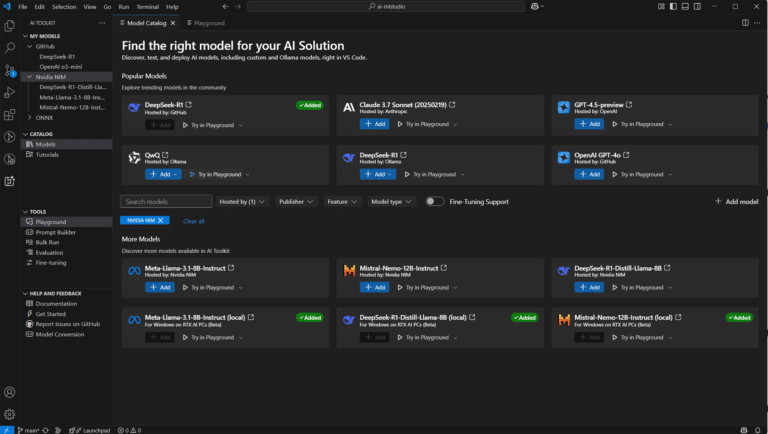

Kit de Herramientas de IA para Visual Studio Code Ahora Compatible con Microservicios NIM de NVIDIA para PCs RTX AI

El AI Toolkit ha dado un paso significativo al mejorar su funcionalidad con la integración de soporte para los modelos de fundamentos basados en microservicios de NVIDIA NIM. Esta innovación ofrece a los desarrolladores y expertos en inteligencia artificial la capacidad de realizar pruebas de inferencia en el playground de modelos del AI Toolkit. Esta incorporación facilita la exploración y