En el dinámico mundo de la inteligencia artificial (IA), la habilidad de adaptar modelos de lenguaje a industrias específicas se ha vuelto crucial. Mientras que los modelos de lenguaje de gran tamaño (LLMs) son competentes en manejar diversas tareas de lenguaje natural, su verdadero potencial reside en tareas de propósito general y no en especializadas. Esta falta de especificidad puede representar un obstáculo al manejar datos textuales de dominios con terminología única, como lo ilustra el sector automotriz.

En la industria automotriz, la precisión en los diagnósticos depende de códigos específicos de diagnóstico del vehículo (DTCs), que a menudo son exclusivos de cada fabricante. Códigos como P0300, relacionado con un fallo genérico de encendido, o C1201, que indica una falla en el sistema ABS, son vitales para realizar diagnósticos precisos. Sin estas referencias, un modelo de lenguaje generalista podría fallar al proporcionar un diagnóstico exacto, lo que podría derivar en respuestas imprecisas o alucinaciones, es decir, crear diagnósticos plausibles pero incorrectos. Tomemos como ejemplo una descripción vaga como «motor funcionando de manera irregular»; sin un DTC específico, el modelo podría ofrecer múltiples diagnósticos, muchos de los cuales no serían pertinentes o carecerían de sustento suficiente.

Además, las aplicaciones de IA generativa orientadas al consumidor revelan cómo los usuarios finales interactúan. Con una adecuada retroalimentación, estas aplicaciones pueden recopilar datos valiosos para mejorar las respuestas y comportamiento de los modelos.

Por ello, los modelos de lenguaje de pequeño tamaño (SLMs) están ganando terreno. Estos modelos, más compactos y asequibles, están diseñados para tareas específicas, gracias a su eficaz arquitectura de transformadores, ya sea de decodificador único o codificador-decodificador. Con parámetros que van de 1 a 8 mil millones, son más prácticos y rentables en su entrenamiento y despliegue en comparación con los LLMs. Los SLMs, al ser más rápidos y requerir menos recursos, son ideales para dispositivos variados, sobre todo en aplicaciones especializadas y escenarios de computación en el borde.

AWS ha desarrollado múltiples soluciones para trabajar con modelos de lenguaje. Amazon Bedrock y Amazon SageMaker son servicios gestionados que facilitan la construcción y despliegue de aplicaciones de IA generativa, ofreciendo modelos de base para ajuste y personalización. Usando Amazon SageMaker JumpStart o contenedores de Hugging Face, los SLMs pueden ser entrenados de manera eficiente gracias a técnicas como la Adaptación de Bajo Rango (LoRA), haciendo que estas herramientas estén al alcance de más clientes.

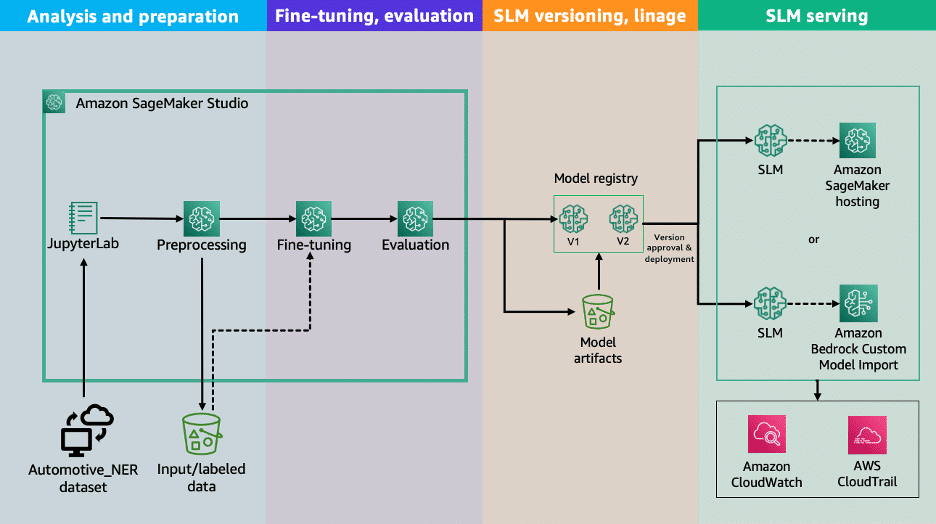

Un estudio específico detalla las fases para personalizar SLMs en AWS para aplicaciones de preguntas y respuestas en automoción. Desde el análisis de datos hasta la implementación y evaluación, se guía a través del proceso, comparando los beneficios de un SLM personalizado con un LLM generalista. Aunque el enfoque está en la terminología automotriz, los métodos son aplicables a otros campos, con documentación y recursos disponibles en el repositorio de Github asociado.