Salesforce y Amazon Web Services (AWS) han unido fuerzas en una colaboración que promete revolucionar la implementación de modelos de inteligencia artificial, con un enfoque particular en los modelos de lenguaje de gran tamaño (LLMs). Esta alianza busca abordar los desafíos inherentes a la gestión de estos modelos dentro de aplicaciones críticas mediante una infraestructura robusta proporcionada por el equipo de Model Serving de Salesforce.

Uno de los principales desafíos que enfrenta el equipo es lograr un despliegue eficiente de los modelos, asegurando un rendimiento óptimo al tiempo que se mantiene una gestión de costos efectiva. Esta tarea se complica debido a la diversidad de tamaños y requisitos de rendimiento, que pueden variar desde unos pocos gigabytes hasta 30 GB.

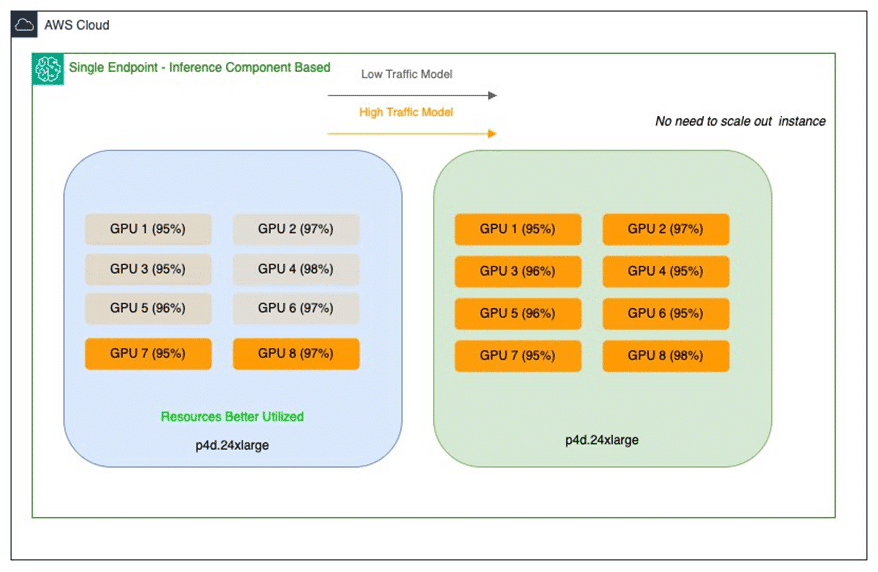

Los retos identificados incluyen el uso subóptimo de los recursos por parte de los modelos más grandes debido a la baja utilización de las instancias de múltiples GPUs. Por otro lado, los modelos de tamaño intermedio exigen un procesamiento con bajo tiempo de respuesta, lo cual resulta en mayores costos por sobreasignación de recursos.

Para superar estos desafíos, Salesforce ha implementado componentes de inferencia de Amazon SageMaker. Esta estrategia permite la implementación de múltiples modelos de base en un único endpoint, otorgando un control más preciso sobre los aceleradores y la memoria, mejorando la utilización de recursos y reduciendo los costos asociados.

La implementación de estos componentes de inferencia ofrece beneficios significativos, como la optimización del uso de GPUs y la capacidad de escalar los modelos según las necesidades de cada aplicación. Esto no solo soluciona problemas inmediatos, sino que también establece una base flexible para el futuro crecimiento y evolución de las iniciativas de inteligencia artificial de Salesforce.

Los beneficios se traducen en una mejora de la eficiencia operativa y una reducción de hasta un 80% en los costos de despliegue. Además, los modelos más pequeños también aprovechan las GPUs de alto rendimiento, ofreciendo un elevado rendimiento sin gastos excesivos.

De cara al futuro, Salesforce planifica continuar explotando la capacidad de actualizaciones continuas de los componentes de inferencia. Esto permitirá mantener los modelos al día de manera más eficiente, reduciendo la carga operativa y fomentando la integración de innovaciones futuras, posicionando a la compañía para una continua expansión en el ámbito de la inteligencia artificial.