Los avances en los modelos de inteligencia artificial generativa han generado un interés creciente en la creación de contenido multimedia de alta calidad. La diferencia entre un contenido meramente bueno y uno realmente extraordinario radica en los pequeños detalles que solo la retroalimentación humana puede capturar. La segmentación de audio y video ofrece un método estructurado para recopilar esta retroalimentación detallada, permitiendo que los modelos aprendan a través del aprendizaje por refuerzo a partir del feedback humano (RLHF) y el ajuste fino supervisado (SFT).

En las aplicaciones de generación de texto a video, los modelos deben aprender no solo qué generar, sino cómo mantener la coherencia y el flujo natural a lo largo del tiempo. Aspectos como el ritmo de los movimientos, la consistencia visual y la suavidad de las transiciones son cruciales para la calidad del contenido. A través de una segmentación y anotación precisa, los anotadores humanos pueden proporcionar un feedback detallado sobre cada uno de estos aspectos, ayudando a los modelos a entender qué hace que una secuencia de video generada se sienta natural y no artificial.

En el ámbito de la generación de texto a voz, comprender las sutilezas del habla humana, como la duración de las pausas entre frases o los cambios en el tono emocional, requiere una retroalimentación humana detallada a nivel de segmento. Esta información permite a los modelos generar discursos que suenan naturales, con el ritmo y la consistencia emocional adecuados. A medida que los modelos de lenguaje grandes (LLM) integran más capacidades multimedia, el feedback humano se vuelve aún más crítico en su entrenamiento para generar contenido rico y multimodal que cumpla con los estándares de calidad humana.

La creación de modelos de inteligencia artificial efectivos para la generación de audio y video presenta varios desafíos específicos. Los anotadores necesitan identificar momentos precisos donde el contenido generado coincide o se desvía de las expectativas naturales del ser humano. En la generación de discurso, esto implica marcar los puntos exactos donde cambian las entonaciones, donde las pausas se sienten antinaturales o donde el tono emocional cambia inesperadamente. En la generación de video, los anotadores deben señalar los fotogramas donde los movimientos se vuelven bruscos, donde la consistencia del objeto se quiebra o donde los cambios de iluminación parecen artificiales.

Amazon SageMaker Ground Truth facilita el RLHF al permitir a los equipos integrar el feedback humano detallado directamente en el entrenamiento del modelo. Mediante flujos de trabajo personalizados de anotación humana, las organizaciones pueden equipar a los anotadores con herramientas para una segmentación de alta precisión. Este sistema permite al modelo aprender a partir de datos etiquetados por humanos, perfeccionando su capacidad para producir contenido que se alinee con las expectativas naturales del ser humano.

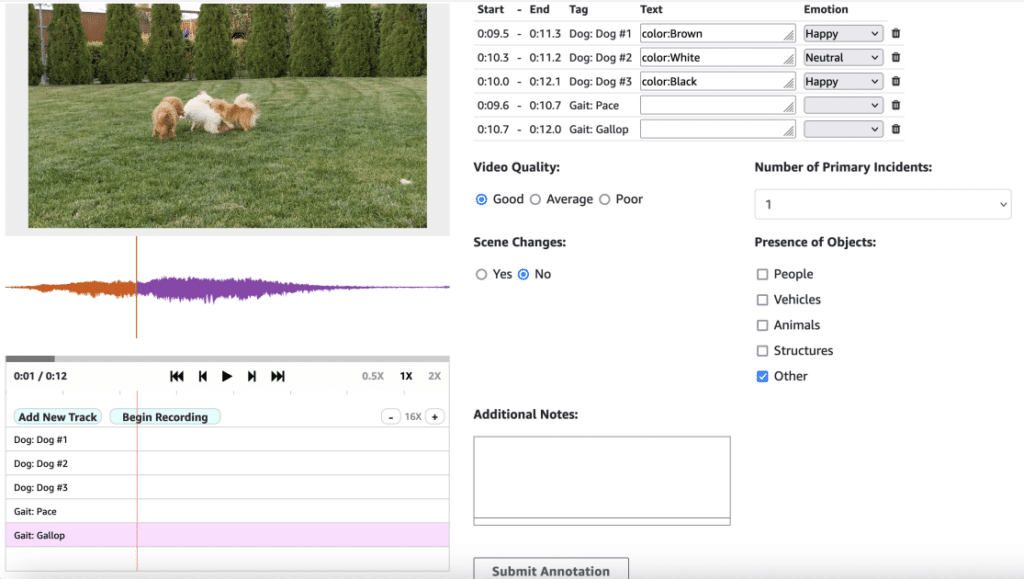

La solución de segmentación de audio y video presentada, realizada con SageMaker Ground Truth, guía a los usuarios a través de la implementación de la infraestructura necesaria, la creación de una fuerza de trabajo de etiquetado interno y la configuración del primer trabajo de etiquetado. El uso de Wavesurfer.js para la visualización y segmentación precisa de audio permite personalizar la interfaz según las necesidades específicas, abarcando tanto enfoques basados en consola como programáticos para crear trabajos de etiquetado.

La calidad de los datos es fundamental para entrenar modelos de inteligencia artificial generativos capaces de producir contenido de audio y video natural y afín al humano. El rendimiento de estos modelos depende directamente de la precisión y el detalle del feedback humano obtenido a través de un proceso de anotación preciso y completo. Herramientas como la desarrollada en SageMaker Ground Truth abordan desafíos comunes en la anotación de audio y video, proporcionando funciones avanzadas como el zoom para facilitar la captura precisa de momentos breves pero impactantes que afectan la percepción de la calidad en los modelos de generación de discurso y video.

El uso combinado de varios servicios de AWS en esta fase de anotación robusta, incluida la distribución de contenido protegido a través de Amazon CloudFront, garantiza una entrega eficiente y segura de los componentes de la interfaz de usuario. Funciones opcionales de AWS Lambda pueden enriquecer el flujo de trabajo, permitiendo adaptaciones flexibles para necesidades específicas sin modificar el proceso de anotación central.

Con esta solución de segmentación de audio y video, las organizaciones pueden generar datos de alta calidad cruciales para el entrenamiento eficaz de modelos generativos de inteligencia artificial, mejorando aplicaciones como la síntesis de voz, la generación de videos o el reconocimiento de patrones de audio complejos. En esta era de contenido multimedia generado por IA, el feedback humano sigue siendo un componente esencial para mejorar continuamente la calidad y autenticidad del contenido generado.