El avance en los modelos de lenguaje amplios (LLMs) ha revolucionado la integración de la inteligencia artificial en aplicaciones mediante el uso de API. Sin embargo, muchas empresas prefieren alojar sus propios modelos para asegurar la soberanía de los datos y personalizar los modelos según sus necesidades específicas. Esta decisión, aunque compleja y costosa debido a la gestión de infraestructuras y GPU, busca garantizar que la información sensible permanezca segura dentro de la empresa y que los modelos se ajusten precisamente a los conjuntos de datos industriales.

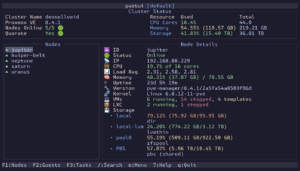

Amazon SageMaker AI aborda estas complejidades ofreciendo puntos finales administrados que simplifican la gestión de GPU. Esto permite a los equipos centrarse en el rendimiento de los modelos sin preocuparse por la infraestructura. Los contenedores de inferencia proporcionados están diseñados para maximizar la velocidad y disminuir la latencia, aunque lograr el mejor rendimiento se convierte en un reto que requiere una configuración detallada de parámetros como el tamaño del lote y el paralelismo tensorial.

Para facilitar este proceso, BentoML ha introducido LLM-Optimizer, una herramienta que automatiza la búsqueda de configuraciones óptimas. Este avance elimina las pruebas manuales, simplificando la tarea de identificar configuraciones que cumplan con los objetivos de servicio, haciendo que el proceso sea mucho más accesible.

Un ejemplo práctico detalla los pasos para optimizar un modelo específico, el Qwen-3-4B, en un punto final de SageMaker AI. Este incluye la definición de restricciones de rendimiento, realización de pruebas de referencia y el despliegue de configuraciones optimizadas, equilibrando así la latencia, el rendimiento y los costos involucrados.

La optimización de la inferencia se centra en métricas clave como el rendimiento y la latencia. Para los ingenieros, entender cómo interactúan estos factores es vital, especialmente cuando los modelos son trasladados de API a soluciones alojadas internamente, responsabilizándose del proceso de optimización.

El uso de LLM-Optimizer junto con Amazon SageMaker AI permite a las empresas emplear un método sistemático y basado en datos para reemplazar los laboriosos ajustes manuales, mejorando la eficiencia y la experiencia del usuario. En conclusión, la combinación de optimización automatizada con infraestructuras gestionadas representa un avance notable hacia la accesibilidad y la rentabilidad de la inteligencia artificial en el ámbito empresarial.