Los equipos de ciencia de datos dedicados a la inteligencia artificial enfrentan desafíos complejos debido al creciente tamaño y complejidad de los modelos que manejan. A pesar de que los Contenedores de Aprendizaje Profundo de Amazon (DLCs) presentan ambientes de trabajo optimizados, la personalización específica para proyectos individuales requiere tiempo y destrezas técnicas avanzadas.

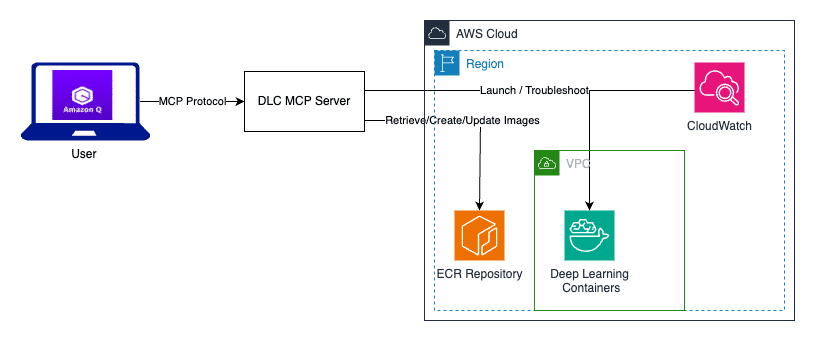

Para solucionar esta dificultad, Amazon ha introducido el Amazon Q Developer junto con el Protocolo de Contexto de Modelo (MCP). Esta combinación optimiza los flujos de trabajo de los DLCs al automatizar la creación, ejecución y personalización, simplificando el trabajo de los desarrolladores.

Los AWS DLCs son entornos preconfigurados que permiten el entrenamiento y despliegue de modelos de lenguaje a gran escala en plataformas de Amazon como Elastic Compute Cloud y Elastic Kubernetes Service. Actualizados constantemente con las últimas versiones de bibliotecas y controladores, estos contenedores ayudan a evitar problemas de incompatibilidad sin incurrir en costes adicionales.

No obstante, muchas organizaciones encuentran obstáculos al realizar personalizaciones necesarias, como la instalación de bibliotecas propietarias. Tradicionalmente, esto implicaba un proceso manual y laborioso de reconstrucción de contenedores, configuraciones y pruebas, demandando días de trabajo y exponiéndose a errores.

Amazon Q se perfila como un asistente experto en AWS que ofrece guía práctica mediante interacciones en lenguaje natural. Al mismo tiempo, el Protocolo de Contexto de Modelo conecta a los asistentes de IA con herramientas externas, facilitando configuraciones necesarias para los contenedores DLC.

El servidor DLC MCP gestiona esta tarea mediante seis funciones clave, incluyendo la gestión de contenedores, la creación de imágenes personalizadas e implementación en servicios de AWS. Además, su servicio de diagnóstico soluciona problemas relacionados con los DLC.

La sinergia entre Amazon Q y el servidor DLC MCP ha demostrado reducir significativamente el tiempo de configuración y la posibilidad de errores, permitiendo a los equipos enfocarse en desarrollar soluciones de IA en lugar de lidiar con la infraestructura técnica. Esta metodología promueve una transición más fluida desde el desarrollo hasta la producción, incrementando la eficiencia y efectividad en proyectos de inteligencia artificial.