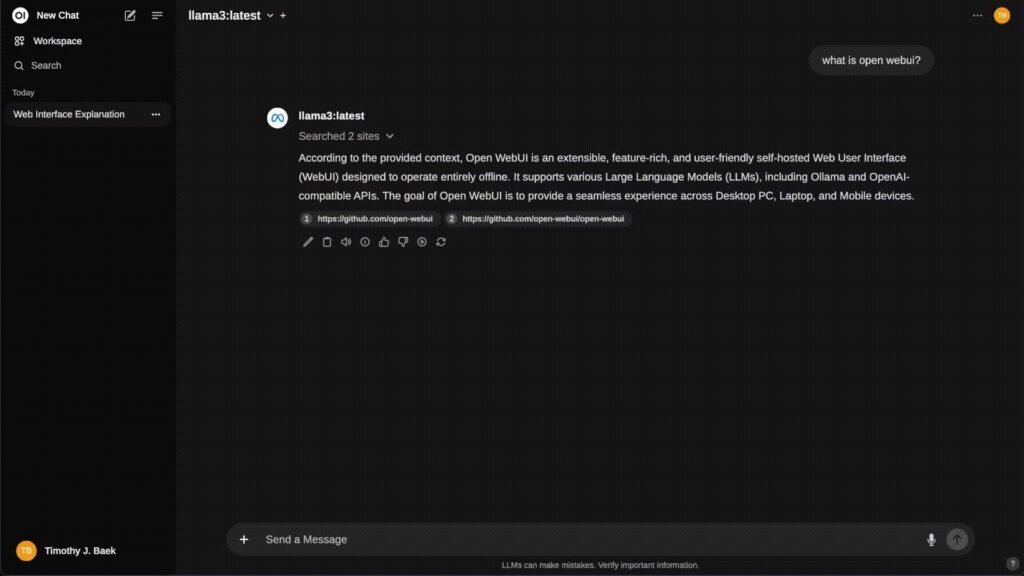

Mientras todo el mundo habla de modelos y APIs, una pieza clave pasa muchas veces desapercibida: la interfaz y la plataforma desde la que tus usuarios van a trabajar con la IA. Ahí es donde entra Open WebUI, un proyecto open source que se ha convertido en uno de los frontends más completos y cuidados para trabajar con modelos locales (Ollama) y con APIs compatibles con OpenAI… todo ello autoalojado, extensible y preparado para funcionar sin conexión a Internet.

Si estás pensando en montar tu propio “ChatGPT corporativo” on-premise o en tu cloud, Open WebUI es, a día de hoy, uno de los candidatos más serios.

¿Qué es exactamente Open WebUI?

Open WebUI es una plataforma web de IA autoalojada con estas ideas clave:

- Funciona totalmente en tu infraestructura (servidor, NAS, homelab, Kubernetes…).

- Se integra con:

- Ollama (modelos locales tipo Llama, Phi, Qwen, etc.).

- Cualquier API compatible con OpenAI (OpenAI, Groq, Mistral, OpenRouter, LM Studio, etc.).

- Incluye:

- Chat multi-modelo.

- RAG local (carga de documentos y bibliotecas).

- Navegación web, búsqueda externa, generación de imágenes.

- Sistema de usuarios, grupos, permisos y plugins.

En la práctica, es la “capa de experiencia de usuario” que le faltaba a muchos despliegues de LLMs autoalojados.

Puntos fuertes para admins y empresas

1. Autoalojado y preparado para funcionar offline

Open WebUI está pensado para entornos donde:

- No quieres (o no puedes) enviar datos a servicios externos.

- Necesitas que la herramienta funcione en redes aisladas o segmentadas.

Puedes levantarlo con:

- Docker (el camino habitual y más sencillo).

- Python/pip (instalación nativa).

- Kubernetes (manifiestos, kustomize, Helm).

Y además soporta modo offline (con HF_HUB_OFFLINE=1) para evitar que intente descargar modelos de Hugging Face si trabajas en entornos cerrados.

2. Integración flexible con modelos: local y remoto

Open WebUI no se casa con un único proveedor:

- Ollama:

- Puedes usar el contenedor normal apuntando a tu servidor Ollama.

- O usar la imagen “todo en uno” que trae Open WebUI + Ollama en el mismo contenedor (con o sin GPU).

- APIs OpenAI-compatibles:

Definiendo la URL y la API key puedes conectarte a:- OpenAI

- GroqCloud

- Mistral

- OpenRouter

- LM Studio

- Y cualquier backend compatible.

Esto te permite cambiar de modelo o proveedor sin cambiar de interfaz, e incluso usar varios modelos a la vez según el caso de uso.

3. Gestión de usuarios, permisos y empresa

Para despliegues serios, la parte de identidad y permisos es clave. Open WebUI incluye:

- RBAC (Role-Based Access Control):

- Control de quién puede usar qué modelos.

- Restricción de creación/descarga de modelos (solo admins).

- Grupos y permisos granulares, orientados a entornos con múltiples equipos.

- Soporte SCIM 2.0:

- Integración con Okta, Azure AD, Google Workspace, etc.

- Aprovisionamiento y ciclo de vida de usuarios automatizado.

Es decir, no es solo un “chat bonito”, es una pieza que puede encajar en la arquitectura de identidad corporativa.

4. RAG local, navegación web y búsqueda integrada

Open WebUI trae de serie varias capacidades que normalmente obligan a ensamblar varias piezas:

- RAG local:

- Subir documentos directamente al chat.

- Crear una biblioteca de documentos reutilizable.

- Referenciar ficheros con

#antes de la consulta.

- Búsqueda web integrada para RAG:

- Soporta proveedores como SearXNG, Google PSE, Brave, DuckDuckGo, Tavily, Bing y otros.

- Los resultados se inyectan directamente en el contexto del modelo.

- Navegación web:

- Puedes pasar una URL con

#https://...y que el sistema incorpore contenido de la página en la conversación.

- Puedes pasar una URL con

Esto lo convierte en un entorno ideal para:

- Asistentes de documentación interna.

- Agentes de investigación.

- Herramientas internas de soporte y knowledge base.

5. Plugins, pipelines y Python nativo

Pensando en desarrolladores y equipos de plataforma, Open WebUI incluye:

- Pipelines / Plugins:

- Framework para integrar lógica propia y librerías Python.

- Permite cosas como:

- Function calling custom.

- Rate limiting por usuario.

- Monitorización de uso (por ejemplo, con Langfuse).

- Traducción automática en vivo.

- Filtros de toxicidad.

- Herramientas Python nativas:

- Editor de código integrado en el workspace de herramientas.

- Puedes “traer tus propias funciones” (BYOF) simplemente añadiendo funciones Python y exponiéndolas como herramientas al LLM.

En resumen: puedes transformar Open WebUI en una plataforma de agentes corporativos con lógica de negocio embebida.

6. Experiencia de usuario muy cuidada

Aunque es una herramienta muy técnica, la UX está bastante trabajada:

- UI responsive para escritorio, portátil y móvil.

- PWA para tenerla “como app” en el móvil, incluso en local.

- Soporte completo de Markdown y LaTeX.

- Llamadas de voz y vídeo manos libres.

- Soporte multilenguaje (i18n) y comunidad activa traduciendo.

Para un despliegue interno, esto se traduce en algo importante: los usuarios se adaptan rápido, sin formación complicada.

Instalación rápida: Docker en una línea

Si ya tienes Ollama en el mismo servidor:

docker run -d \

-p 3000:8080 \

--add-host=host.docker.internal:host-gateway \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:main

Lenguaje del código: JavaScript (javascript)Si quieres usar solo OpenAI API:

docker run -d \

-p 3000:8080 \

-e OPENAI_API_KEY=tu_api_key \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:main

Lenguaje del código: JavaScript (javascript)Y si prefieres Open WebUI + Ollama en un solo contenedor (CPU):

docker run -d \

-p 3000:8080 \

-v ollama:/root/.ollama \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:ollama

Lenguaje del código: JavaScript (javascript)Para GPU basta con añadir --gpus all en el docker run.

¿Para qué tipo de proyectos encaja mejor?

Open WebUI es especialmente interesante si:

- Quieres montar tu propio “ChatGPT interno” con modelos locales u hospedados por ti.

- Necesitas control de datos, compliance y soberanía (on-prem, cloud privada, VPS propio, etc.).

- Tu equipo de IT prefiere soluciones autoalojadas, integrables con LDAP/IdP y fáciles de observar/monitorizar.

- Te interesa un frontend único aunque uses múltiples modelos y proveedores a la vez.

- Estás trabajando en proyectos de:

- Soporte interno.

- Asistentes para documentación técnica.

- Herramientas de productividad para equipos (dev, soporte, ventas, etc.).

- Entornos educativos o laboratorios de IA.