Microsoft acaba de mover ficha en un terreno clave para la próxima ola de aplicaciones con IA: la voz. La compañía ha publicado VibeVoice-Realtime-0.5B, un modelo de texto a voz open source capaz de generar audio en tiempo real con una latencia de unos 300 ms, pensado para integrarse en terminales, backends y aplicaciones interactivas.

A diferencia de muchas soluciones de TTS “enlatadas” vía API, VibeVoice nace con un enfoque muy claro: dar a equipos técnicos un framework completo para construir experiencias conversacionales largas, multi-turno y con baja latencia, con capacidad de auto-hosting y control de la infraestructura.

¿Qué aporta VibeVoice a un equipo técnico?

Para desarrolladores y administradores de sistemas, VibeVoice es interesante por varias razones:

- Modelo en tiempo real: VibeVoice-Realtime-0.5B está optimizado para streaming, generando el primer fragmento de audio en torno a los 300 ms y permitiendo ir enviando texto de forma incremental (ideal para agentes, asistentes o bots de soporte).

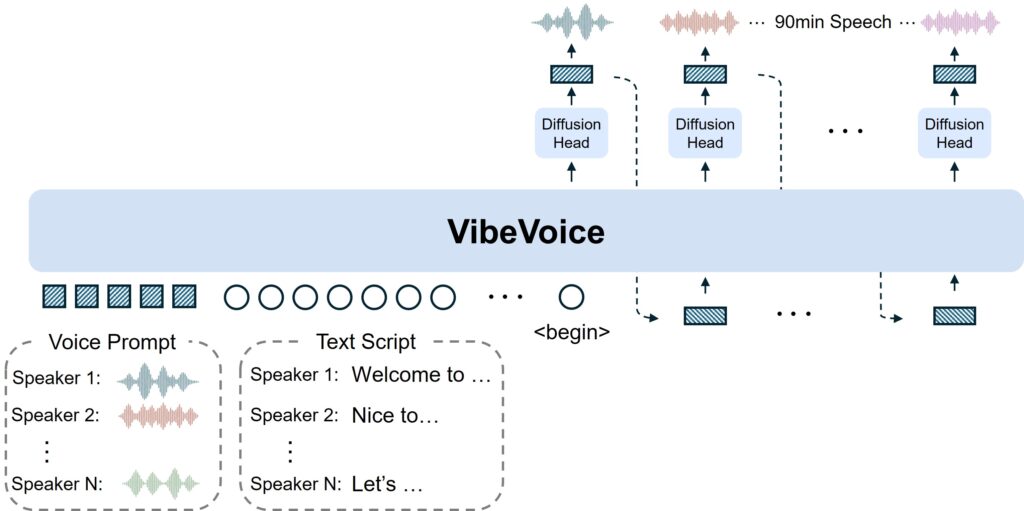

- Diseñado para secuencias largas: el framework original de VibeVoice está pensado para conversaciones de hasta unos 90 minutos y hasta 4 interlocutores en su variante de larga duración, algo poco habitual en TTS tradicionales.

- Stack moderno y modular: el sistema usa tokenizadores de audio continuos (acústico y semántico) que operan a solo 7,5 Hz, reduciendo el coste computacional manteniendo calidad de audio. Encima de eso, un LLM (basado en Qwen2.5-1.5B en esta versión) gestiona el contexto y un “diffusion head” añade los detalles acústicos finos.

- Open source y reproducible: el código y los modelos están en GitHub y Hugging Face bajo licencias abiertas para investigación y desarrollo, algo clave para empresas que no quieren depender al 100 % de servicios cerrados en la nube.

Nueve voces experimentales y foco en el español

Uno de los anuncios que más ha llamado la atención es la inclusión de voces experimentales en nueve idiomas, entre ellos el español, además de alemán, francés, italiano, japonés, coreano, neerlandés, polaco y portugués. La idea es ofrecer speakers listos para usar en escenarios multilingües y facilitar las pruebas en distintos mercados.

Aquí conviene matizar algo importante para perfiles técnicos: la propia documentación de VibeVoice indica que el modelo está entrenado principalmente con datos en inglés (y, en versiones anteriores, chino), y que el soporte para otros idiomas puede producir resultados inesperados. En otras palabras, las voces en otros idiomas son hoy terreno experimental y no un TTS maduro para producción masiva.

Para proyectos de prototipado, demos internas o herramientas de soporte que no requieran una perfección absoluta, estas voces pueden ser más que suficientes. Para productos finales de cara al usuario, la recomendación sigue siendo testear bien, ajustar expectativas y combinar con otros TTS cuando haga falta.

Arquitectura pensada para agentes, backends y terminal

VibeVoice encaja muy bien en el tipo de aplicaciones que los equipos de desarrollo y operaciones están empezando a desplegar: agentes de IA, asistentes internos, paneles de control hablados, sistemas de monitoring con alertas de voz, etc.

Algunos puntos clave desde el punto de vista de integración:

- Soporte de streaming vía WebSocket: el propio repositorio incluye ejemplos para montar un servidor con websockets y servir audio en tiempo real, lo que facilita conectarlo a UIs web, apps móviles o incluso frontends en terminal.

- Separation of concerns: el modelo no gestiona música, efectos ni solapes complejos de audio. Se centra en voz limpia, lo que simplifica la orquestación con otros servicios (motor de juego, mezcladores de audio, etc.).

- Pensado para infra propia: al no depender de una API comercial cerrada, se puede desplegar en on-premise, en nubes privadas o incluso en entornos air-gapped, siempre que haya GPU suficiente. Para muchos sysadmins, esto es una diferencia clave en sectores regulados (sanidad, banca, administración pública).

Rendimiento, costes y dónde encaja en la infraestructura

El uso de tokenización a 7,5 Hz y de un modelo de ~0,5B parámetros en la variante realtime busca un equilibrio entre latencia y coste de cómputo. No estamos ante un “juguete”, pero tampoco ante un modelo gigantesco imposible de mover fuera de un hiperescala.

A nivel práctico:

- en GPU de gama media se puede aspirar a uso interactivo para unos cuantos usuarios concurrentes;

- en entornos servidores con varias GPU se puede escalar para call centers virtuales, asistentes de soporte o herramientas internas habladas;

- en entornos sin GPU, la experiencia real-time será mucho más limitada, por lo que no es la opción ideal si la única base es CPU.

Para equipos de operaciones, la ventaja es que se puede monitorizar, containerizar y versionar igual que cualquier otro servicio interno: imágenes Docker, orquestación con Kubernetes, límites de recursos, métricas de latencia, etc.

Seguridad, deepfakes y control de uso

Microsoft insiste bastante en el apartado de riesgos y limitaciones. De hecho, el repositorio de VibeVoice llegó a deshabilitarse temporalmente en 2025 por usos no alineados con el objetivo de investigación responsable, y se reabrió con más controles.

Medidas y advertencias relevantes para equipos técnicos:

- Mitigación de deepfakes: los voice prompts se proporcionan en formato embebido, no como audios arbitrarios subidos por el usuario, para evitar clonaciones directas 1:1 de voces reales. Para personalizar voz hay que pasar por el equipo de Microsoft.

- Uso recomendado para I+D: la propia documentación desaconseja por ahora el despliegue directo en entornos comerciales sin pruebas adicionales, tanto por sesgos y errores del modelo como por los riesgos de uso malicioso.

- Cumplimiento normativo: los equipos deben asumir la obligación de avisar cuando un contenido es generado por IA y respetar la legislación local en materia de protección de datos, propiedad intelectual y fraudes de voz.

Para sysadmins, esto se traduce en políticas claras de quién puede acceder al servicio, trazabilidad de llamadas, etiquetado de contenido y, en algunos casos, rate limiting o aislamiento por proyectos.

¿Por qué importa VibeVoice para el ecosistema?

Más allá del “hype”, VibeVoice encaja en una tendencia clara: los agentes de IA pasan de ser texto en una consola a convertirse en interfaces de voz en tiempo real, que se integran con sistemas corporativos, herramientas de desarrollo y flujos de trabajo internos.

Que un actor como Microsoft libere un framework de este calibre, con foco en baja latencia y en conversación larga, es una señal fuerte para el ecosistema open source:

- reduce la dependencia exclusiva de APIs SaaS de TTS;

- permite a equipos de plataforma montar su propia capa de voz ajustada a sus requisitos;

- y, sobre todo, abre la puerta a experimentar de forma controlada con callbots, asistentes internos, interfaces de administración habladas o herramientas dev-ops conversacionales.

Para desarrolladores y administradores de sistemas, el mensaje es claro: la voz ya no es solo un “extra” para demos, sino un componente más de la pila de infraestructura de IA. VibeVoice ofrece un punto de partida potente, auditable y extensible para empezar a construir sobre ella… siempre que se haga con cabeza, buenas prácticas de seguridad y métricas claras de coste y rendimiento.