Amazon Bedrock ha anunciado el lanzamiento de una innovadora funcionalidad llamada Knowledge Bases, que promete revolucionar la implementación de los flujos de trabajo de Generación Aumentada por Recuperación (RAG). Este sistema completamente gestionado se encarga desde la ingestión de datos hasta la recuperación y la augmentación de prompts, eliminando así la necesidad de crear integraciones personalizadas con distintas fuentes de datos y de gestionar los flujos de datos de manera manual.

La empresa ha destacado que no existe una fórmula única para optimizar el rendimiento de estas bases de conocimiento, ya que cada caso de uso tiene sus propias particularidades. Por esta razón, es imprescindible realizar pruebas constantes y ajustar rápidamente las configuraciones para determinar la mejor solución para cada escenario específico.

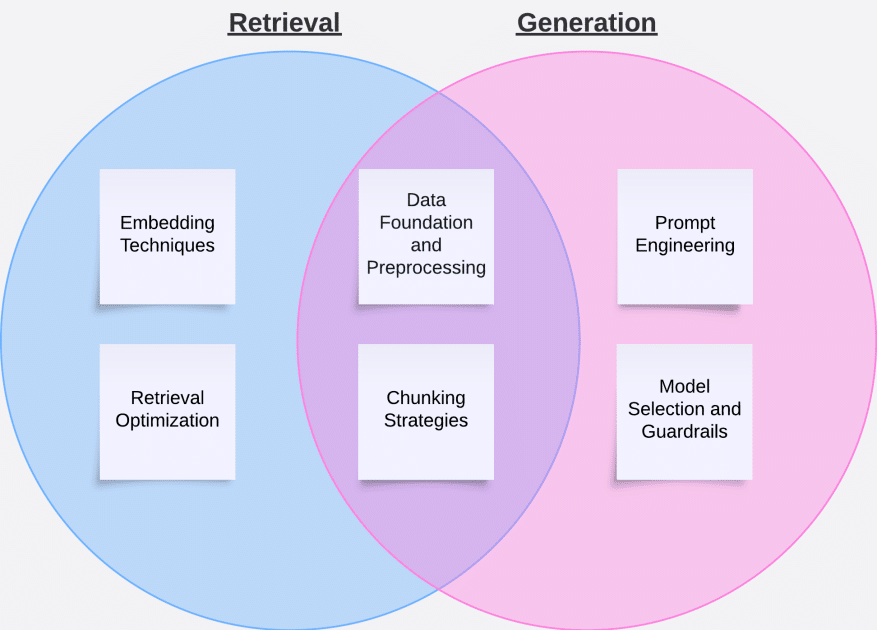

Un reciente informe proporciona una guía detallada sobre cómo evaluar el rendimiento de una base de conocimiento, describiendo varias etapas pertinentes al proceso. El primer paso es la evaluación independiente de la recuperación y la generación de respuestas. La fase de recuperación consiste en obtener fragmentos relevantes de documentos en base a una consulta, añadiendo estos elementos recuperados al contexto del prompt final. La generación, por otro lado, implica enviar el prompt del usuario junto con el contexto recuperado a un modelo de lenguaje grande (LLM), y posteriormente devolver al usuario la respuesta generada por el LLM.

Para la evaluación de la recuperación, se emplean dos métricas clave: la relevancia del contexto y la cobertura del contexto. La relevancia del contexto asegura que la información recuperada realmente responde a la intención de la consulta, mientras que la cobertura del contexto evalúa la exhaustividad del material recuperado en comparación con la verdad objetiva. Estas métricas se determinan comparando los resultados obtenidos con las respuestas esperadas dentro de un conjunto de datos de prueba especialmente formateado.

Validar que el flujo de trabajo de RAG recupera el contexto relevante permite pasar a la evaluación de la fase de generación. Para ello, Amazon Bedrock propone un marco de evaluación que cubre ocho métricas, que miden tanto la calidad de la respuesta como el cumplimiento de los criterios de inteligencia artificial responsable. Entre las métricas de calidad se encuentran la utilidad, corrección, coherencia lógica, completitud y fidelidad. Las métricas de inteligencia artificial responsable, por su lado, supervisan la presencia de contenido dañino o estereotipado y la capacidad del sistema para rechazar preguntas inapropiadas.

Un aspecto fundamental para una evaluación significativa es construir un conjunto de datos de prueba robusto, para el cual se recomienda utilizar datos anotados manualmente y generar datos sintéticos con la ayuda de modelos de lenguaje grandes (LLMs). Además, se sugiere una estrategia de mejora continua basada en la retroalimentación de los usuarios.

La optimización de las Bases de Conocimiento de Amazon Bedrock se presenta como un proceso iterativo que requiere pruebas y refinamientos sistemáticos. El éxito de este proceso depende del uso metódico de técnicas como la ingeniería de prompts y el chunking, que pueden mejorar tanto la etapa de recuperación como la de generación. El seguimiento de las métricas clave permite medir el impacto de las optimizaciones y asegura que se cumplan los requisitos específicos de cada aplicación.