Las grandes empresas están adoptando modelos de lenguaje de gran escala (LLMs) a través de Amazon Bedrock para obtener conclusiones de sus datos internos. Amazon Bedrock proporciona modelos de inteligencia artificial de alto rendimiento de proveedores destacados como AI21 Labs, Anthropic y Amazon, todo mediante una única API. Este servicio asegura la construcción de aplicaciones de inteligencia artificial generativa que priorizan la seguridad, privacidad y responsabilidad.

Un desafío común para las organizaciones que utilizan sistemas de inteligencia artificial conversacional es la velocidad de respuesta a consultas complejas. Este problema se agrava en industrias reguladas donde la seguridad es primordial. Un ejemplo de esto es una organización financiera global con más de 1.5 billones de dólares en activos, que experimentó problemas de lentitud en sus sistemas de IA conversacional, incluso después de integrar múltiples LLMs y sistemas de seguridad estrictos.

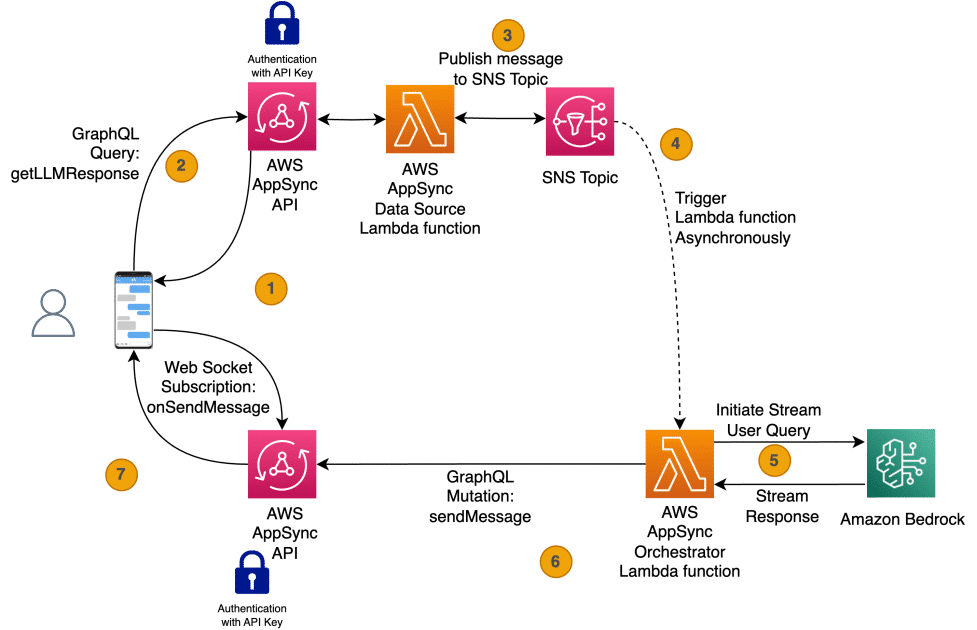

AWS AppSync emerge como una solución efectiva a este problema. Este servicio gestionado permite a los desarrolladores crear APIs GraphQL sin servidor, ofreciendo capacidades en tiempo real. Utilizando suscripciones de AWS AppSync junto a puntos finales de streaming de Amazon Bedrock, las organizaciones pueden entregar respuestas de IA generativa de manera incremental.

La solución funciona mediante AWS AppSync para iniciar conversaciones de manera asíncrona. Una función de AWS Lambda interactúa con la API de streaming de Amazon Bedrock. Los tokens generados por los LLM se transmiten al usuario a través de mutaciones y suscripciones de AWS AppSync, garantizando que las respuestas lleguen en tiempo real.

Este enfoque implica varios pasos que inician con el usuario conectándose a la aplicación mediante WebSocket, formulando una consulta que activa una función GraphQL. Esta, a su vez, publica un evento en Amazon SNS para notificar al usuario, completando el flujo sincrónico. Luego, una función Lambda recibiendo el evento SNS se comunica con Amazon Bedrock y envía los tokens al front-end en tiempo real.

La implementación de este sistema ha mostrado mejoras significativas. Con esta solución, una entidad financiera logró reducir los tiempos de respuesta para consultas complejas de 10 segundos a entre 2 y 3 segundos. Esto no solo mejoró la experiencia del usuario, sino que también redujo las tasas de abandono y aumentó el compromiso con las aplicaciones. Esta estrategia se perfila como un avance importante para las empresas que buscan optimizar sus interacciones y eficiencia en tiempo real.