El ajuste fino de modelos de lenguaje grandes (LLM) se ha convertido en una práctica cada vez más relevante en el ámbito de la inteligencia artificial. Este proceso no solo permite a los usuarios personalizar los modelos para que se adapten a tareas específicas, sino que también asegura que mantengan su precisión y efectividad aun cuando los entornos de datos cambian. La técnica continúa evolucionando y ha introducido métodos innovadores para enfrentar los desafíos de adaptación continua.

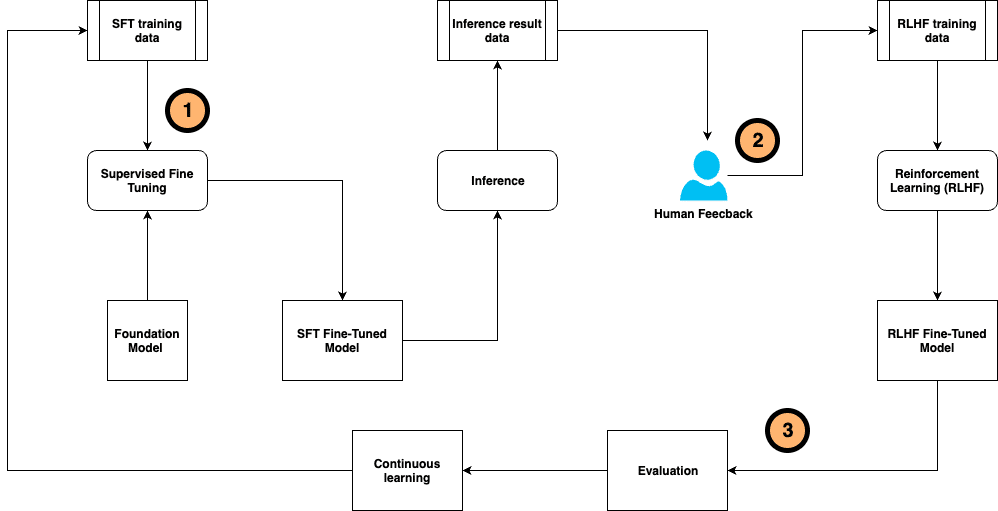

Una de las técnicas clave en este ámbito es el ajuste fino supervisado (SFT), complementado por la afinación de instrucciones. Este método se basa en conjuntos de datos anotados por humanos, donde el aprendizaje por refuerzo basado en la retroalimentación humana (RLHF) desempeña un papel crucial. A través de esta técnica, las respuestas del modelo se alinean mejor con las preferencias humanas, al recibir recompensas por las salidas que cumplen dichas expectativas.

Sin embargo, lograr resultados precisos y responsables sigue siendo un desafío. La anotación manual y la recolección de retroalimentación consumen tiempo y recursos significativos. El proceso requiere una coordinación meticulosa entre la generación de datos, el entrenamiento del modelo, y la continua alineación con las preferencias de los usuarios.

Para afrontar estos retos, se ha desarrollado un marco innovador de ajuste fino auto-instruido continuo, que busca unificar y simplificar el proceso. Este sistema integra la generación y anotación de datos de entrenamiento, la evaluación del modelo, y la recolección de retroalimentación humana, optimizando así la eficiencia del flujo de trabajo. Esto se logra mediante la personalización continua del modelo base usando datos etiquetados por humanos y retroalimentación post-inferencia del modelo.

En este contexto, un sistema compuesto de inteligencia artificial ha sido planteado para superar las limitaciones de los modelos tradicionales. La interacción entre múltiples componentes, incluyendo modelos, recuperadores y herramientas externas, permite crear soluciones más sofisticadas y efectivas. Para facilitar esta construcción, se ha introducido DSPy, un marco de programación de Python de código abierto, que proporciona a los desarrolladores una metodología modular y declarativa para el desarrollo de aplicaciones LLM, mejorando tanto los resultados como la experiencia del usuario.

El desarrollo de este sistema de ajuste fino continuo y auto-instruido representa un avance significativo en la precisión y rendimiento de los modelos de lenguaje. Ofrece un marco que maximiza la reutilización y adaptabilidad, necesario para mantenerse al día con la evolución constante de los datos y las demandas del usuario, evidenciando una continua innovación en el campo de la inteligencia artificial.