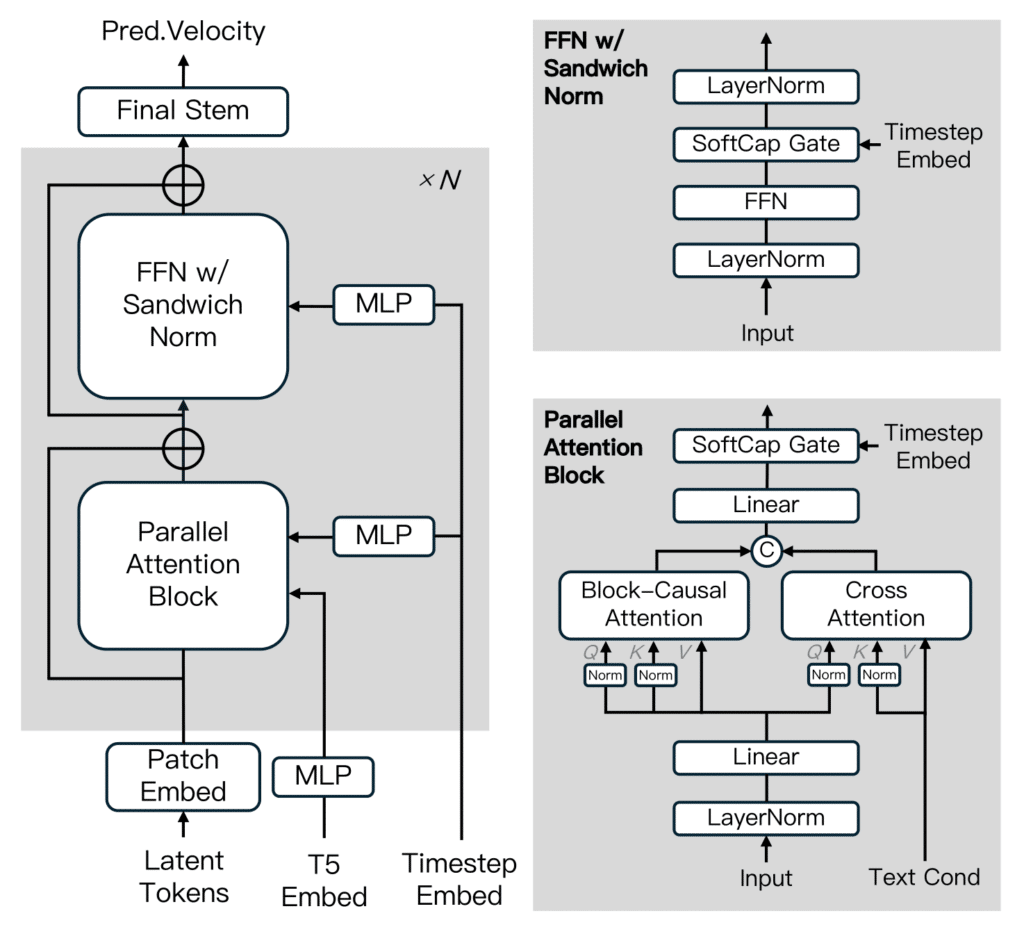

La revolución de la inteligencia artificial generativa en vídeo suma un nuevo competidor de alto calibre: MAGI-1, una IA de código abierto desarrollada por la startup china Sand AI. Con una arquitectura autoregresiva optimizada para producción escalable y control por fragmentos, MAGI-1 ofrece una alternativa real a los modelos comerciales cerrados como Sora (OpenAI), Kling (ByteDance) o VideoPoet (Google).

Diseñado para entornos exigentes como streaming, síntesis multimodal y generación en tiempo real, MAGI-1 combina innovación arquitectónica, control narrativo granular y rendimiento competitivo en benchmarks clave.

¿Qué hace diferente a MAGI-1?

- Generación autoregresiva por bloques de 24 frames, con procesamiento concurrente y continuidad temporal garantizada.

- Control total de narrativa mediante prompts segmentados, permitiendo modificar escenas dinámicamente.

- Alto realismo en movimiento, coherencia semántica y comprensión física superior.

- Código abierto completo, compatible con infraestructuras Docker y Conda, con soporte para GPUs profesionales y prosumidor.

Comparativa técnica: MAGI-1 frente a sus competidores

| Modelo | Código Abierto | Arquitectura | Control Narrativo | Precisión Física (Physics-IQ) | Realismo de Movimiento | Inferencia Streaming |

|---|---|---|---|---|---|---|

| MAGI-1 | ✅ Sí | Diffusion Transformer autoregresivo | ✅ Por fragmentos (chunk-wise) | 🟢 Alto (30.23 I2V / 56.02 V2V) | 🟢 Excelente | ✅ Soportado |

| Sora | ❌ No | Diffusion + transformer | ❌ Limitado | 🔴 Bajo (10.00) | 🟡 Bueno | ❌ No soportado |

| Kling | ❌ No | Transformer | 🟡 Medio | 🟡 Medio (23.64) | 🟢 Bueno | ❌ Parcial |

| VideoPoet | ❌ No | Mixto (transformer + autoregresivo) | 🟡 Medio | 🟠 Bajo (20.30) | 🟡 Variable | ❌ Parcial |

| Wan-2.1 | ✅ Sí | Diffusion | ❌ Limitado | 🟠 Bajo (20.89) | 🟡 Básico | ❌ No |

Nota: Los datos de Physics-IQ indican la precisión en predicciones físicas realistas en tareas de vídeo continuado. Los valores más altos indican mayor entendimiento causal y espacial.

Ficha técnica: cómo ejecutar MAGI-1 en tu entorno

Requisitos mínimos sugeridos:

| Modelo | Hardware recomendado |

|---|---|

| MAGI-1-24B | 8× NVIDIA H100/H800 o 8× RTX 4090 |

| MAGI-1-4.5B | 1× RTX 4090 o superior |

| MAGI-1-24B-distill | 4× H100 o 8× RTX 4090 |

1. Ejecución rápida con Docker (recomendado)

docker pull sandai/magi:latest

docker run -it --gpus all --privileged --shm-size=32g --name magi \

--net=host --ipc=host --ulimit memlock=-1 --ulimit stack=6710886 \

sandai/magi:latest /bin/bash2. Ejecución desde código fuente

# Crear entorno Conda

conda create -n magi python=3.10.12

conda activate magi

# Instalar PyTorch + CUDA

conda install pytorch=2.4.0 torchvision=0.19.0 torchaudio=2.4.0 pytorch-cuda=12.4 -c pytorch -c nvidia

# Instalar dependencias

pip install -r requirements.txt

# Instalar FFmpeg

conda install -c conda-forge ffmpeg=4.4

# Clonar e instalar MagiAttention

git clone https://github.com/SandAI-org/MagiAttention.git

cd MagiAttention

git submodule update --init --recursive

pip install --no-build-isolation .Lenguaje del código: PHP (php)3. Iniciar inferencia por texto o imagen

Imagen a vídeo (i2v):

bash example/4.5B/run.sh \

--mode i2v \

--prompt "A futuristic cityscape at night" \

--image_path example/assets/image.jpeg \

--output_path results/output.mp4Lenguaje del código: JavaScript (javascript)Texto a vídeo (t2v):

bash example/4.5B/run.sh \

--mode t2v \

--prompt "A cat flying through a neon sky with rainbows" \

--output_path results/flying_cat.mp4Lenguaje del código: JavaScript (javascript)Conclusión

MAGI-1 representa un cambio de paradigma: rendimiento de última generación, arquitectura autoregresiva optimizada para inferencia concurrente, y todo bajo una licencia abierta y reproducible. En un mercado saturado de modelos cerrados, Sand AI ofrece una alternativa potente, escalable y transparente.

¿Estamos ante el nuevo estándar de vídeo por IA open source? La comunidad de desarrolladores, creadores y empresas tiene ahora en sus manos una herramienta que democratiza el acceso a la generación visual avanzada, con niveles de control y coherencia que rivalizan con las plataformas propietarias más populares.

Fuente: Noticias inteligencia artificial