Durante mucho tiempo, ejecutar un modelo de lenguaje “en serio” implicaba un patrón casi inevitable: GPU, servicios cloud, facturación por uso y, en demasiadas ocasiones, datos sensibles saliendo del perímetro. Pero el auge del edge —portátiles potentes, mini PCs, y sobre todo la llegada masiva de NPUs en móviles y equipos nuevos— está reabriendo una posibilidad que interesa especialmente a administradores de sistemas: hacer inferencia local, con latencia baja y sin dependencia de internet.

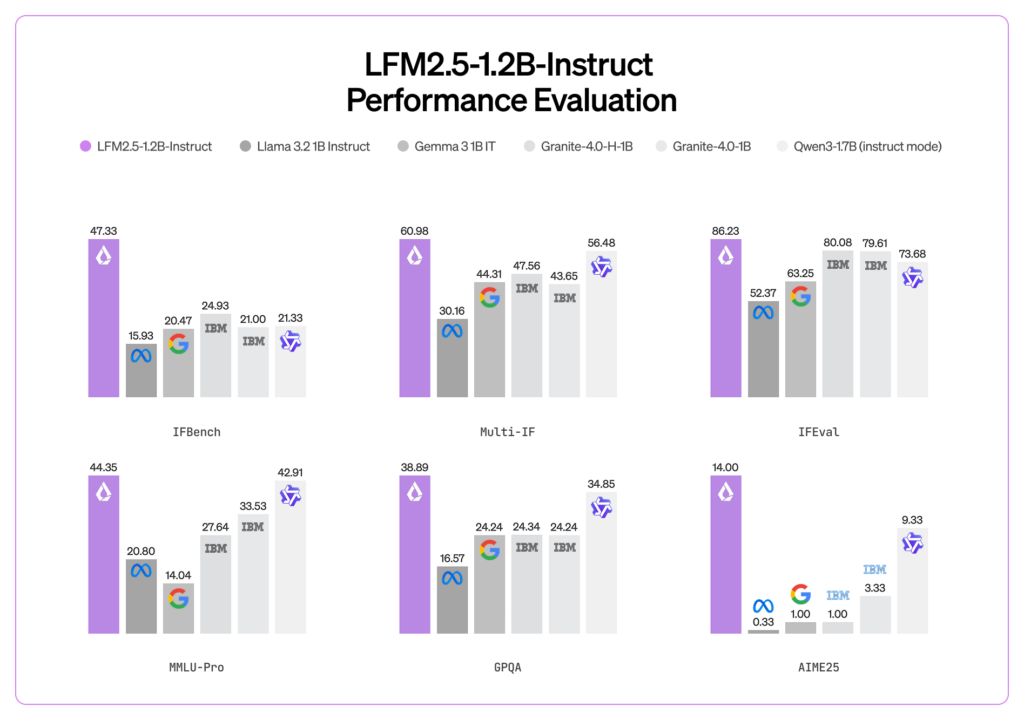

En ese contexto, Liquid AI está empujando con fuerza su familia LFM2.5, y en particular el modelo LFM2.5-1.2B-Instruct, que se presenta como una opción orientada a despliegues “de producción” en hardware modesto. La tarjeta del modelo pone cifras llamativas encima de la mesa: 239 tokens por segundo en CPU AMD, 82 tokens por segundo en una NPU móvil y un perfil de memoria por debajo de 1 GB. Si esos números se sostienen en escenarios reales, el mensaje para un equipo de sistemas es directo: hay automatizaciones, asistentes internos y flujos de soporte que podrían ejecutarse “on-prem”, incluso en el endpoint, sin añadir una nueva dependencia externa.

Por qué esto importa en operaciones: menos fricción y más control

Para un sysadmin, el atractivo no es la novedad del modelo, sino la reducción de fricción operativa:

- Sin claves ni APIs: elimina el punto único de fallo de un proveedor o una cuota de API.

- Sin internet: útil en entornos restringidos, plantas industriales, air-gapped o simplemente cuando la conectividad no es fiable.

- Privacidad por diseño: logs, volcados, tickets, runbooks o procedimientos internos pueden procesarse localmente sin exponer contenido.

Ese giro no sustituye a los modelos “frontera” en tareas complejas, pero sí encaja en una categoría que en IT es enorme: texto técnico repetitivo, clasificación, extracción, normalización y ayuda contextual.

Qué trae LFM2.5-1.2B-Instruct y qué no promete

La ficha técnica describe un modelo de 1,17 miles de millones de parámetros, con 16 capas y una arquitectura híbrida que mezcla bloques convolucionales y atención (GQA). También destaca una ampliación del preentrenamiento hasta 28 billones de tokens y un ciclo de refuerzo (RL) para mejorar el seguimiento de instrucciones. En operaciones, esto se traduce en algo menos glamuroso pero más útil: más consistencia en tareas de “obediencia” (formatear salidas, seguir plantillas, resumir con estructura) y un coste de ejecución mucho menor.

Aun así, Liquid AI marca límites claros: recomienda el modelo para tareas agénticas, extracción de datos y RAG (responder apoyándose en documentación), pero no lo recomienda para tareas intensivas de conocimiento o programación. En clave sysadmin: puede ser un buen “copiloto” para procedimientos internos y triage, pero no conviene exigirle que sea un sustituto de un modelo grande cuando toca razonar sobre software complejo o generar código delicado.

32.768 tokens de contexto: el detalle que cambia el juego en soporte interno

Un punto especialmente relevante para administradores es el contexto de 32.768 tokens. En la práctica, esto permite meter más “historia” en un prompt: fragmentos de documentación interna, plantillas de respuesta, extractos de logs o pasos de un procedimiento. Para un escenario típico de helpdesk o NOC, eso significa que el modelo puede trabajar con más información en una sola pasada, reduciendo el número de rondas y, por tanto, el tiempo total de resolución.

Despliegue: formatos pensados para la realidad del día a día

LFM2.5 no se limita a un único camino de inferencia. El modelo se distribuye en varios formatos, cada uno con un “público” claro:

- GGUF: orientado a despliegues CPU eficientes con llama.cpp y herramientas compatibles.

- ONNX: pensado para portabilidad y aceleración en distintos entornos.

- MLX: optimizado para Apple Silicon (Mac).

Para un equipo de sistemas, esto reduce la fricción típica de “el modelo va bien, pero integrarlo es un dolor”: aquí el foco está en entrar rápido en pipelines ya conocidos, tanto en local como en escenarios más estructurados.

Casos de uso realistas para sysadmins

En un medio de administración de sistemas, la pregunta no es “¿qué benchmarks gana?”, sino “¿dónde ahorra tiempo sin meter riesgo?”. Algunos usos razonables, sin vender humo:

- Asistente de procedimientos: responder en lenguaje natural usando documentación interna (RAG) para cambios, despliegues o incidencias.

- Triage de tickets: clasificar incidencias, extraer campos, detectar palabras clave, proponer checklist de diagnóstico.

- Resumen de incidentes: convertir un hilo largo (chat, correo, ticket) en un parte estructurado para postmortem.

- Normalización de logs: convertir logs heterogéneos en eventos resumidos, con etiquetas y posibles causas (con supervisión humana).

- Automatización local: pequeñas acciones encadenadas (por ejemplo, redactar respuesta al usuario + preparar lista de comandos sugeridos) sin mandar datos fuera.

La clave, como siempre en producción, es definir la frontera: el modelo puede ayudar, pero los cambios en sistemas deben seguir pasando por controles, revisiones y guardrails.

Preguntas frecuentes

¿Qué ventaja tiene un modelo como LFM2.5 para entornos sin salida a internet (air-gapped)?

Permite inferencia local para tareas de soporte, documentación y automatización sin necesidad de conectividad ni servicios externos, manteniendo los datos dentro del perímetro.

¿Qué formato suele ser más práctico para inferencia rápida en CPU en Linux?

El formato GGUF está orientado a herramientas tipo llama.cpp, habituales en despliegues locales y en servidores sin GPU.

¿Para qué sirve tener 32.768 tokens de contexto en operaciones?

Facilita trabajar con documentación interna más extensa, historiales de tickets y fragmentos de logs en una sola interacción, reduciendo rondas y mejorando la consistencia del output.

¿Puede sustituir a un LLM grande para tareas complejas de programación o conocimiento profundo?

No es el objetivo. La propia documentación lo orienta a extracción, RAG y tareas agénticas, y desaconseja su uso para tareas intensivas de conocimiento o programación.

fuente: Noticias Inteligencia artificial