La inteligencia artificial generativa está impulsando una transformación en diversas industrias, permitiendo a las empresas ofrecer experiencias excepcionales y fomentar la innovación a una escala sin precedentes. Sin embargo, este avance tecnológico también ha generado preocupaciones sobre el uso responsable de estas herramientas.

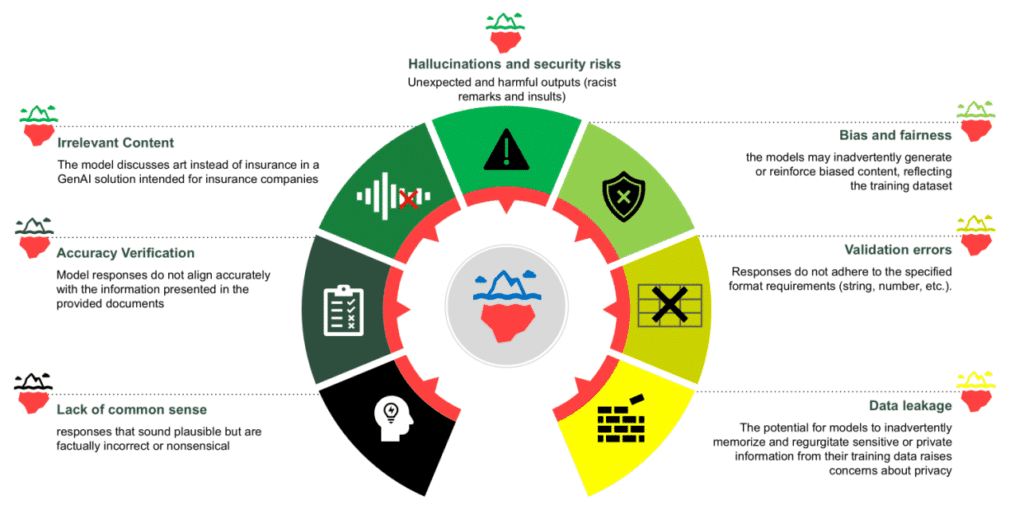

A pesar de la atención creciente hacia la inteligencia artificial responsable durante la última década, los modelos generativos presentan desafíos únicos. Riesgos como las alucinaciones, la falta de control, las violaciones de la propiedad intelectual y comportamientos dañinos no intencionados deben ser abordados proactivamente. Adoptar técnicas de mitigación y controles adecuados es esencial para maximizar el potencial de la IA generativa mientras se minimizan estos riesgos.

El red teaming es una metodología que simula condiciones adversas para evaluar sistemas, sometiendo a los modelos de IA a rigurosas pruebas para identificar debilidades y evaluar su resiliencia. Esta práctica es fundamental para desarrollar sistemas de IA que sean funcionales, seguros y confiables. Al integrar el red teaming en el ciclo de vida de desarrollo de la IA, las organizaciones pueden anticipar amenazas y fomentar la confianza en sus soluciones tecnológicas.

Los sistemas de IA generativa presentan desafíos de seguridad que requieren enfoques especializados. Las vulnerabilidades de estos modelos pueden incluir respuestas alucinadas, contenido inapropiado y la divulgación no autorizada de datos. Estos riesgos podrían ser explotados maliciosamente mediante técnicas como la inyección de comandos.

Data Reply, en colaboración con AWS, ofrece apoyo y mejores prácticas en la incorporación de la IA responsable y el red teaming en los flujos de trabajo organizativos. Esto ayuda a mitigar riesgos inesperados, cumplir con regulaciones emergentes y reducir la posibilidad de filtraciones de datos o usos indebidos de los modelos.

El Red Teaming Playground de Data Reply permite a los creadores de IA explorar escenarios y evaluar las reacciones de los modelos en condiciones adversas mediante herramientas de código abierto y servicios de AWS. Este enfoque es crucial para identificar riesgos y mejorar la seguridad de los sistemas de IA generativa.

Un ejemplo práctico de la aplicación de estas técnicas es un asistente de triaje de salud mental, que requiere un manejo cuidadoso de temas sensibles. Definiendo casos de uso claros, los modelos pueden ser guiados para ofrecer respuestas seguras y apropiadas.

La mejora continua en políticas de IA responsable es crucial. La colaboración entre Data Reply y AWS busca fortalecer desde chequeos de equidad hasta pruebas de seguridad, ayudando a las organizaciones a mantenerse a la vanguardia frente a amenazas emergentes y estándares en evolución.