En un entorno donde la inteligencia artificial generativa está alcanzando nuevas cotas de popularidad, las empresas se ven impulsadas a buscar modelos de fundación que se adecúen a sus necesidades específicas. Estos modelos innovadores están focalizados en tareas concretas como la resumición de documentos, adaptaciones para industrias específicas, y la generación y asesoría técnica de códigos. A partir de ellos, las organizaciones pueden ofrecer experiencias personalizadas con un mínimo de conocimientos técnicos, lo que no solo potencia la innovación, sino que también mejora sus servicios en sectores como el procesamiento del lenguaje natural y la generación de contenido.

Sin embargo, la implementación de estos modelos de IA en el ámbito empresarial enfrenta desafíos significativos. Los modelos genéricos disponibles muchas veces no poseen el conocimiento necesario para ciertos dominios o terminologías propios de las organizaciones. Para subsanar esta deficiencia, las empresas están adoptando modelos de lenguaje grande (LLMs) específicos para cada dominio. Estos LLMs están diseñados para ejecutar tareas especializadas en dominios o micro-dominios concretos y son particularmente útiles en áreas como las finanzas, ventas, marketing, tecnología de la información, recursos humanos, salud y atención al cliente.

Ante el aumento del interés en soluciones personalizadas de IA, las organizaciones enfrentan el reto de gestionar eficientemente una multiplicidad de modelos ajustados a diversos casos de uso y segmentos clientes. Desde el análisis de currículums hasta la confección de correos electrónicos especializados, las empresas frecuentemente lidian con la administración de cientos de modelos afinados, con el riesgo de que esto se torne costoso y complejo. Las soluciones tradicionales para alojar estos modelos pueden complicarse y requerir muchos recursos, derivando en altos costos de infraestructura y cuellos de botella en el rendimiento.

Para hacer frente a estos desafíos, el uso de Low-Rank Adaptation (LoRA) surge como una solución prometedora. Esta técnica permite adaptar modelos de lenguaje preentrenados a nuevas tareas o dominios mediante la adición de pequeñas matrices de pesos entrenables. No obstante, la estrategia tradicional de amalgamar capas ajustadas con los pesos del modelo base presenta ineficiencias en términos de recursos y costos.

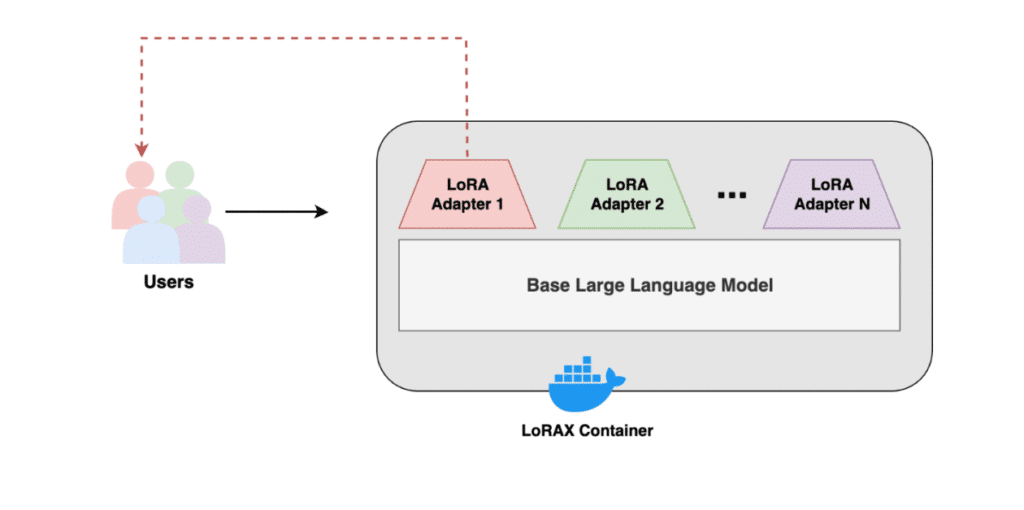

El software de código abierto LoRAX ofrece una alternativa viable para enfrentar estos problemas, permitiendo a las organizaciones manejar y desplegar su creciente gama de modelos ajustados de manera más eficiente y rentable. Gracias a LoRAX, las empresas pueden ajustar un modelo base para diversas tareas y alojar diferentes variantes en una única instancia de EC2, resultando en un ahorro significativo sin sacrificar el rendimiento.

El aumento en la adopción de LoRAX en AWS ha posibilitado la construcción de diversas soluciones para desplegar adaptadores LoRA. Con el apoyo de una comunidad activa y opciones de personalización para integraciones, LoRAX se muestra como una opción robusta para el despliegue de modelos de IA generativa, especialmente en situaciones que demandan un soporte sólido.

En última instancia, la implementación de LoRAX no solo mejora la gestión masiva de modelos, sino que también ofrece una evaluación más flexible y controlada de los costos asociados, permitiendo a las empresas maximizar el uso de los modelos de fundación para cumplir con sus necesidades en la era digital.