En el dinámico campo de la inteligencia artificial, los modelos de lenguaje a gran escala (LLMs) están emergiendo como actores clave en la evolución tecnológica. Capaces de comprender y generar lenguaje natural con notable eficiencia, estos sistemas han transformado la manera en que interactuamos con la tecnología y cómo las empresas desarrollan soluciones innovadoras. Este interés ha impulsado investigaciones y desarrollos que buscan superar los límites existentes en términos de tamaño, rendimiento y eficiencia de estos modelos.

En este contexto, Amazon SageMaker ha dado un importante paso en 2023 con la introducción de sus instancias P5, que cuentan con hasta ocho de las últimas GPUs NVIDIA H100 Tensor Core. Estas instancias están diseñadas para optimizar el entrenamiento de modelos de gran escala, permitiendo la capacitación distribuida a través de tecnologías de red de alto ancho de banda, como EFA. Gracias a esta infraestructura, las organizaciones pueden incrementar significativamente la eficiencia y velocidad de sus procesos de entrenamiento de modelos.

Una de las innovaciones más significativas en este ámbito es la implementación de la precisión FP8 en el entrenamiento de LLMs. Este formato de datos ha sido una innovación transformadora, ya que permite un uso más eficiente de los recursos, ofreciendo una computación más rápida sin sacrificar la calidad del modelo. La adopción de la precisión FP8 reduce tanto el tamaño de los datos como los requerimientos computacionales, lo que se traduce en la capacidad de entrenar modelos más complejos usando el mismo hardware o de acortar los tiempos de entrenamiento manteniendo un desempeño similar.

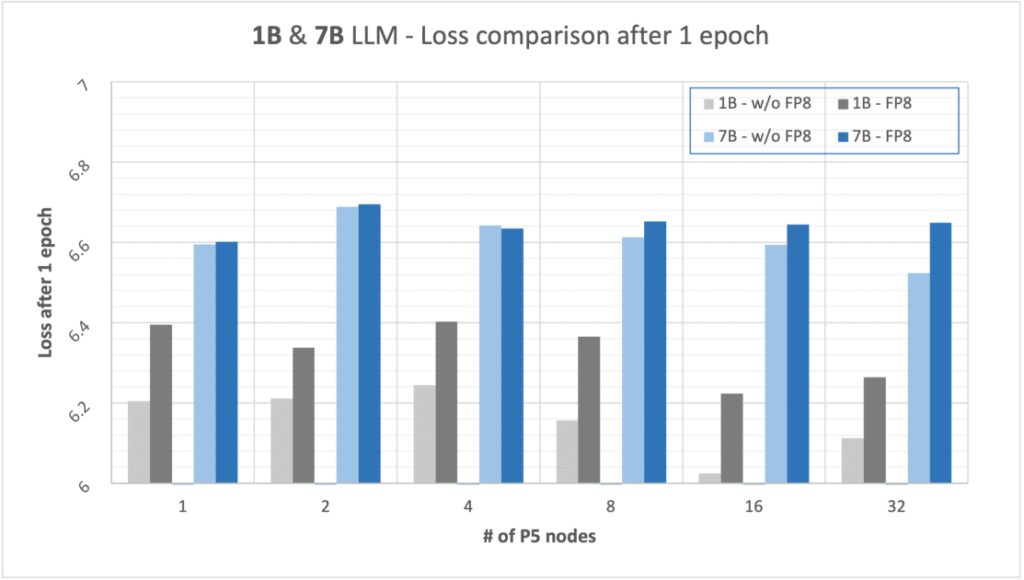

Los ensayos realizados con modelos que cuentan con 1 mil millones y 7 mil millones de parámetros, utilizando FP8, han demostrado un aumento del 13% en velocidad para los modelos más pequeños y hasta un 18% para los de mayor escala. Aunque ha habido un ligero aumento en la pérdida del modelo tras un ciclo de entrenamiento, esta se considera marginal, con solo un incremento del 3% para modelos de 1B y un 2% para modelos de 7B, comparado con los entrenamientos sin FP8.

La combinación de la precisión FP8 con las capacidades de las instancias P5 de SageMaker marca un hito en la evolución del entrenamiento de LLMs. Esto abre nuevas oportunidades para que investigadores y organizaciones adopten estas técnicas, potenciando no solo la aceleración del entrenamiento de modelos de IA a gran escala, sino también mejorando áreas como la visión por computadora y el aprendizaje por refuerzo. Estas herramientas permiten entrenar modelos complejos en un menor tiempo y con menos recursos, lo que se traduce en un rendimiento significativamente mejorado incluso durante etapas de inferencia.

En resumen, la implementación de la precisión FP8 y las instancias P5 señalan un progreso crucial en la búsqueda de una optimización y eficacia superiores para el entrenamiento de modelos de lenguaje a gran escala, sentando las bases para innovaciones futuras en el vasto campo de la inteligencia artificial.