El despliegue global de soluciones de inteligencia artificial generativa enfrenta importantes desafíos, especialmente en la evaluación de la calidad de las respuestas en distintos idiomas. Las empresas deben garantizar un rendimiento consistente, pero las evaluaciones humanas requieren recursos considerables, complicando la escalabilidad sin comprometer la calidad ni afectar los presupuestos.

En respuesta a este reto, Amazon Bedrock Evaluations se presenta como una herramienta eficiente. Gracias a su capacidad de «LLM-as-a-judge», permite evaluar salidas de IA de manera consistente a través de diversas barreras lingüísticas. Este sistema disminuye el tiempo y los recursos necesarios para las evaluaciones multilingües, manteniendo altos estándares de calidad.

Aprovechando las capacidades de Amazon Bedrock, las organizaciones pueden obtener resultados fiables sin necesidad de infraestructuras localizadas o prompts personalizados. Mediante pruebas exhaustivas, se sugieren estrategias prácticas que reducen el costo y la complejidad de las evaluaciones.

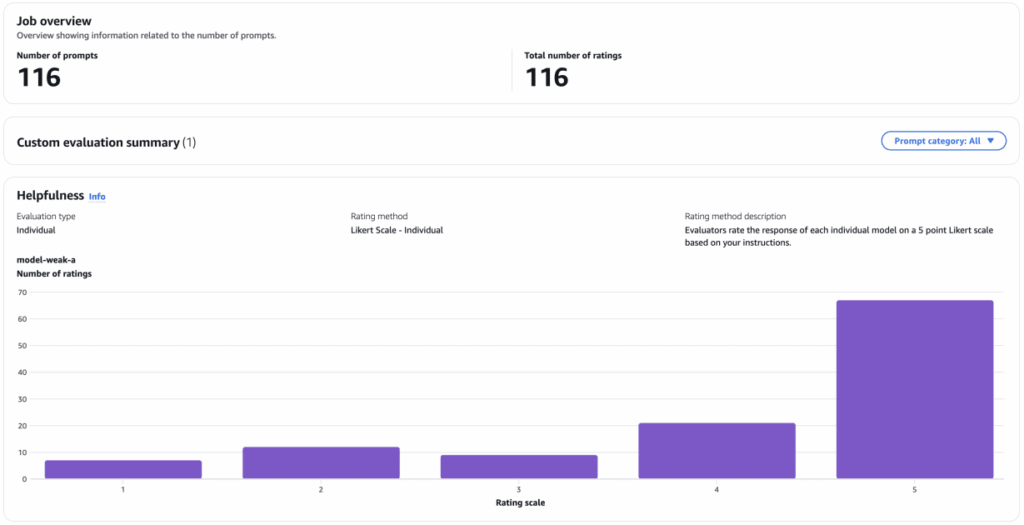

El proceso se simplifica a través de métodos automáticos y humanos para valorar la calidad de los modelos. Las evaluaciones automáticas ofrecen métricas integradas o personalizables, mientras que las humanas establecen una referencia esencial. En particular, se emplearon divisiones en indonesio de un conjunto de datos conversacional, transformando interacciones multigeneracionales en turnos individuales para evaluaciones coherentes.

En la comparación de eficiencias, se observó una concordancia notable entre las calificaciones de jueces LLM y evaluadores humanos en modelos fuertes, aunque en modelos más débiles, las puntuaciones automáticas resultaron más elevadas. Este análisis permitió explorar la correlación entre ambos, mostrando un alineamiento significativo en respuestas de modelos débiles, mientras que fue más moderado en modelos fuertes.

Además, la evaluación multilingüe confirmó que los resultados son consistentes, incluso utilizando prompts en inglés para resultados generados en otros idiomas. Esto facilita la expansión global de las evaluaciones de IA.

En conclusión, los métodos de LLM-as-a-judge son prácticos y económicos, adecuados para implementaciones de gran escala. Sin embargo, las evaluaciones humanas son cruciales para establecer estándares de referencia, asegurando que las automatizadas se alineen con las expectativas de los usuarios finales.