Los modelos de lenguaje grandes (LLMs) están demostrando ser herramientas prometedoras en el ámbito de la traducción automática. Capaces de competir con modelos neuronales como Amazon Translate, los LLMs se destacan por su habilidad para aprender del contexto del texto de entrada, permitiéndoles capturar matices culturales y generar traducciones más naturales.

Un ejemplo práctico de esta capacidad se aprecia en la traducción de la pregunta «¿Te desempeñaste bien?», la cual puede variar significativamente según el idioma y contexto. En un entorno deportivo, por ejemplo, al preguntar «¿Te desempeñaste bien en el torneo de fútbol?», se necesita una traducción en francés que refleje la especificidad cultural del deporte en ese contexto. Así, los modelos de inteligencia artificial que logran captar tanto el contexto como las particularidades culturales son esenciales para obtener traducciones más fluidas y precisas.

Diversas empresas globales están empezando a aprovechar esta capacidad de los LLMs para mejorar la calidad de su contenido traducido. La localización de contenido se basa en un proceso de Traducción Automática con Edición Posterior (MTPE), que combina herramientas automatizadas con intervención humana. Esta combinación ofrece múltiples beneficios como reducción de costos en actividades de MTPE, tiempos de entrega más rápidos y una mejor experiencia para los usuarios.

No obstante, los LLMs también enfrentan desafíos en la traducción automática. Estos incluyen la calidad inconsistente en algunos pares de idiomas, la falta de un patrón estandarizado para integrar la memoria de traducción (TM), y la posibilidad de «alucinación» o errores en sus salidas.

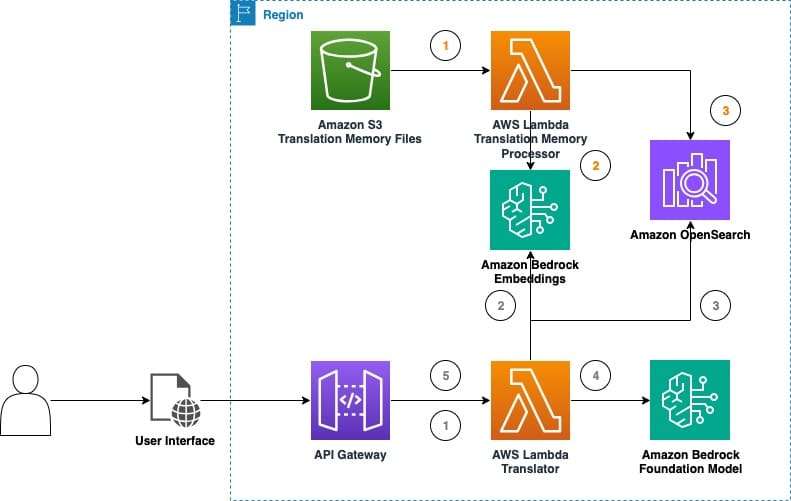

A pesar de estas brechas, la industria de la traducción está comenzando a reconocer que estas herramientas tienen potencial suficiente como para ser consideradas una valiosa opción. Una solución reciente utiliza modelos disponibles en Amazon Bedrock para experimentar con la traducción automática en tiempo real. Esta solución integra técnicas de memoria de traducción y archivos TMX, comunes en herramientas de traducción asistida por computadora.

La memoria de traducción, una base de datos que almacena segmentos de texto previamente traducidos, incrementa la eficiencia y consistencia de los traductores, en especial en proyectos con contenido repetitivo. Al combinar TMs con LLMs, se mejora notablemente la calidad y eficiencia de las traducciones automáticas, ya que estas TMs proporcionan traducciones precisas y específicas de un dominio.

Esta revisión de traducciones previas no solo puede reducir el esfuerzo de edición posterior, sino también aumentar la productividad y disminuir costos. Además, la integración es posible sin complicaciones operativas mediante el uso de estrategias de aprendizaje del contexto y técnicas de ingeniería de prompt.

El «parque de pruebas de traducción LLM» permite experimentar con estas capacidades de traducción, ofreciendo herramientas útiles, como la creación y comparación de configuraciones de inferencia. Durante pruebas simples, los LLMs demostraron una adaptación natural al contexto de las frases, lo que evidencia su potencial para mejorar la calidad de traducción y la experiencia del usuario en base a contextos específicos.

Las investigaciones y desarrollos continuos en LLMs para la traducción automática no solo prometen mejorar la calidad de las traducciones, sino también hacen el proceso de localización más eficiente y accesible para empresas de diferentes tamaños. Esta evolución en tecnología de traducción se perfila como una ventaja competitiva crucial para futuros proyectos de localización de contenido en el mundo empresarial.