Los agentes de inteligencia artificial (IA) están ganando rápidamente protagonismo en los flujos de trabajo de atención al cliente en diversas industrias. Estos agentes facilitan la automatización de tareas complejas, mejoran la toma de decisiones y optimizan operaciones. Sin embargo, su integración en sistemas de producción requiere de pipelines de evaluación escalables. Una evaluación robusta de los agentes permite medir su desempeño en acciones específicas, proporcionando información crucial que mejora la seguridad, el control, la confianza, la transparencia y la optimización del rendimiento de estos sistemas.

Amazon Bedrock Agents aprovecha la lógica de modelos de base disponibles en Amazon Bedrock. Junto con APIs y datos, desglosan solicitudes de los usuarios, recopilan información relevante y ejecutan tareas de manera eficiente. Esto permite que los equipos se enfoquen en trabajos de alto valor al automatizar procesos que requieren múltiples pasos.

Por otro lado, Ragas es una librería de código abierto para evaluar aplicaciones de modelos de lenguaje grande (LLM) en varios casos de uso, como la generación aumentada por recuperación (RAG). Este marco permite medir la efectividad de la implementación de RAG y se utilizó para evaluar la capacidad RAG de Amazon Bedrock Agents.

La metodología LLM-as-a-judge consiste en emplear LLMs para evaluar la calidad de las salidas generadas por la IA, actuando como evaluador imparcial. Este enfoque se usó para analizar y puntuar las capacidades de conversión de texto a SQL y de razonamiento en cadena de los agentes de Amazon Bedrock.

Langfuse, otra plataforma de ingeniería LLM de código abierto, ofrece características como trazas, evaluaciones, gestión de solicitudes y métricas que ayudan a depurar y mejorar aplicaciones basadas en LLM.

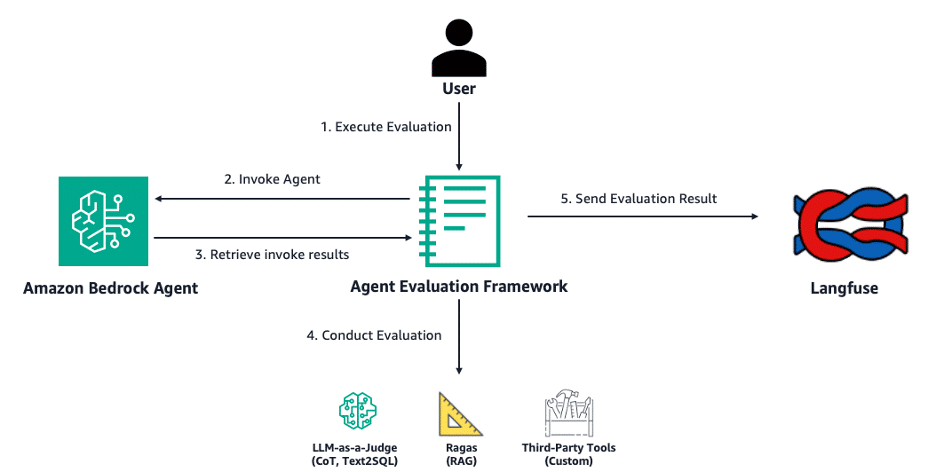

Recientemente, se presentó un marco de evaluación de agentes Bedrock de código abierto que evalúa agentes en su rendimiento en tareas de RAG, conversión de texto a SQL y uso de herramientas personalizadas. Un aspecto significativo de este avance es la posibilidad de visualizar resultados y trazas a través de paneles integrados en Langfuse.

En la evaluación de agentes, los desarrolladores enfrentan desafíos técnicos, como la dificultad de realizar una evaluación end-to-end con métricas específicas para agentes de Amazon Bedrock y la complicada gestión de experimentos debido a múltiples configuraciones posibles.

Para simplificar el proceso, el marco de Open Source Bedrock Agent Evaluation permite que los usuarios especifiquen un ID de agente y ejecuten trabajos de evaluación invocando agentes en Amazon Bedrock. Este proceso genera trazas que se analizan y evalúan, enviando los resultados a Langfuse para obtener información y métricas agregadas.

La relevancia de estas evaluaciones destaca en la investigación farmacéutica, donde se han diseñado agentes que colaboran y analizan datos relacionados con biomarcadores. Estos agentes utilizan un enfoque de colaboración para facilitar el descubrimiento de información clave en la investigación médica, haciendo crucial la integración y evaluación de sus capacidades. Esto resalta la importancia de herramientas efectivas para evaluar agentes de IA, mejorando su eficacia y asegurando confianza y seguridad en entornos críticos.