Dropbase ha irrumpido en el radar de la comunidad dev con una promesa nítida: construir aplicaciones web reales —no prototipos— más rápido, con ayuda de inteligencia artificial, pero sin renunciar al control del código y a un enfoque local-first y self-hosted. El proyecto, disponible en GitHub, describe una plataforma que genera y orquesta la aplicación completa (frontend y backend) y que se integra con fuentes de datos y servicios de terceros, desde paneles de administración hasta herramientas internas y tableros de facturación.

A diferencia de buena parte del low-code/no-code que prosperó la última década, Dropbase se define, ante todo, como una herramienta para desarrolladores. Su tesis: los constructores visuales pueden acelerar, pero rara vez escalan bien cuando hay que mantener, migrar o extender lógica de negocio compleja. En respuesta, propone un “modo IA” que genera código revisable y editable, un web framework propio y un runtime que vive en la base de código del usuario. Todo ello, con despliegue local y bajo control del equipo técnico.

Un generador de software con IA que no oculta el código

La visión del proyecto pasa por un “ingeniero de software” asistido por IA, especializado en construir apps internas con rapidez y seguridad. Dropbase articula esa promesa sobre dos pilares: un framework diseñado para sacarle partido a modelos como GPT, y una experiencia de desarrollo donde el código permanece siempre accesible —se puede inspeccionar, versionar y adaptar—, de forma que el equipo conserva las riendas.

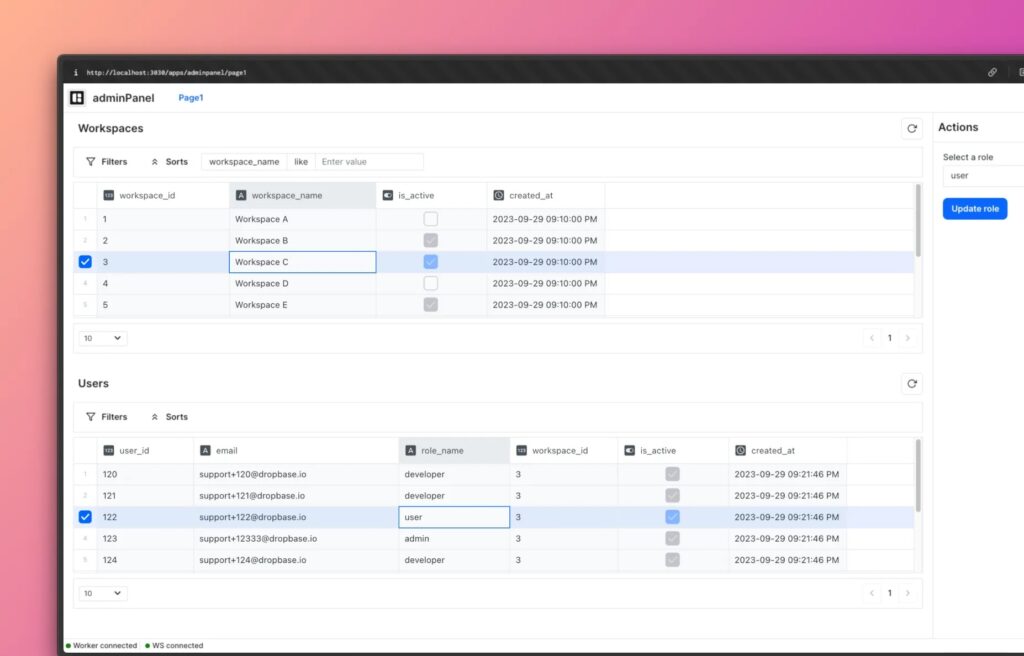

El fabricante ha ido perfilando casos de uso abundantes en departamentos de operaciones y back-office: editores de bases de datos con interfaz de hoja de cálculo, validación de datos celda a celda, filtros y auditoría fina; y paneles de administración que convierten consultas SQL en vistas funcionales con controles y permisos. Son piezas muy comunes en empresas que, sin ser “producto” para clientes, sostienen procesos críticos.

Local-first y self-hosted: privacidad y portabilidad por defecto

Uno de los rasgos diferenciales de Dropbase es su apuesta por el self-hosted. Todo el stack puede levantarse en local —recomiendan Docker Desktop, especialmente en equipos con chips Apple— y operar dentro de la propia red o VPC de la organización. La compañía defiende este enfoque por razones de privacidad, cumplimiento y seguridad: los datos no tienen por qué circular por nubes ajenas; el equipo controla dónde viven las claves y cómo se conectan las fuentes de datos. La contrapartida: hoy no existe un servicio plenamente cloud “de un clic”; el camino oficial pasa por seguir los pasos de instalación local.

En la práctica, el proyecto enfatiza que “Dropbase vive en tu codebase”: las apps generadas son portables (carpetas zip compartibles entre usuarios de Dropbase), los scripts y librerías personalizados se importan con normalidad y la plataforma se apoya en Python como lenguaje universal para extender funcionalidades, incluyendo paquetes de PyPI.

Qué puede construir hoy: de hojas de cálculo vivas a paneles con permisos

La lista de ejemplos públicos se centra en necesidades in-house: editores de contactos o leads sincronizados con CRM, tablas con búsqueda/filtrado para operaciones, y paneles con trazabilidad para equipos de atención o finanzas. Todos ellos comparten una misma base: UI preconstruida, acceso granular por permisos, auditoría y posibilidad de inyectar lógica Python o consultas SQL para moldear exactamente el comportamiento que la empresa necesita.

Más allá de lo visual, la clave está en cómo Dropbase entiende las integraciones: el worker se configura mediante un archivo worker.toml donde viven las variables de entorno sensibles (p. ej., tokens de Stripe o Mailgun) y las conexiones a bases de datos. Este diseño busca facilitar que la IA “sepa” qué credenciales o fuentes están disponibles —sin exponerlas externamente— y que el equipo dev pueda versionar la infraestructura de la app junto con el código.

Cómo empezar: clonar, levantar y crear la primera app

El proceso de arranque está descrito de forma concisa en el repositorio:

- Pre-requisitos. Instalar Docker (mejor Docker Desktop en Apple Silicon).

- Clonar el repositorio con

git clone https://github.com/DropbaseHQ/dropbase.git. - Levantar el servidor: dar permisos al script (

chmod +x start.sh) y ejecutarlo (./start.sh). - Abrir el constructor en el navegador en

http://localhost:3030/appsy pulsar Create app para iniciar el primer proyecto.

La activación de funciones de IA requiere añadir una clave de OpenAI o Anthropic en server.toml, con el modelo preferido (por ejemplo, gpt-4o). Es importante situar las variables de entorno adicionales antes del bloque de configuración de LLM, ya que ese bloque se define como tabla en TOML y requiere un orden específico.

El archivo worker.toml concentra las variables del proceso worker: claves de APIs, tokens y datasources. El formato de bases de datos sigue un patrón tipo database.<tipo>.<alias>; por ejemplo, un PostgreSQL “my_source” se define con host, database, username, password y port. Para ejecutar la demo integrada, debe existir database.sqlite.demo en esa configuración. Desde versiones superiores a dropbase-server v0.6.0, el proyecto remarca que worker.toml debe residir en el directorio de trabajo.

Python y PyPI como lengua franca

La documentación refuerza la idea de que cualquier paquete instalable con pip puede añadirse al entorno de tareas de Dropbase. El proyecto ofrece un requirements-custom.txt en el directorio del worker para enumerar dependencias, y basta con relanzar ./start.sh para que el entorno incorpore los paquetes. Es un enfoque familiar para quien ya versiona entornos con requirements.txt, y reduce fricciones cuando la IA genera código que se apoya en librerías habituales del ecosistema.

Una comunidad que crece y mira al largo plazo

La plataforma ha ido ganando tracción en el último año. En verano de 2024, el equipo celebró haber superado las 1.000 estrellas en GitHub —una señal de interés temprano—, con una narrativa centrada en que “el futuro de construir software será prompt-based”. El discurso, compartido por su cofundador Jimmy E. Chan, subraya la continuidad entre rapidez y mantenibilidad: lo generado por IA debe poder escalar, migrar y pasar por code review como cualquier otro módulo del sistema.

Esa tensión entre velocidad y control es, probablemente, el punto donde Dropbase intenta diferenciarse de alternativas que priorizan el clic sobre el código. Donde otros “encierran” la lógica en cajas negras, Dropbase insiste en exponer el esqueleto de la app: componentes de UI reutilizables, lógica en Python, consultas SQL, workers configurables y auditoría. Si el equipo quiere abandonar la herramienta en el futuro, la portabilidad de las carpetas de app, más la presencia del código en el repositorio, apuntan a una salida menos dolorosa que la media del sector.

Seguridad y cumplimiento: claves, datos y auditoría

El post sobre el worker autoalojado aporta contexto sobre el enfoque de seguridad. El fabricante reconoce que optar por self-hosted conlleva más pasos iniciales, pero argumenta que, para sectores regulados o con datos sensibles, mantener el procesamiento en la propia VPC aporta ventajas claras en términos de cumplimiento y control de superficie de ataque. La plataforma incluye controles de acceso por permisos, trazas de auditoría y separación de responsabilidades entre quien define la UI y quien gestiona las credenciales y fuentes de datos.

¿Para quién tiene más sentido ahora?

La propuesta encaja especialmente bien en organizaciones que construyen muchas herramientas internas y que hoy gastan horas en “apps de formularios sobre datos”. Equipos de ops, atención al cliente, finanzas o growth suelen necesitar interfaces ad hoc encima de bases de datos corporativas o APIs SaaS. Si el objetivo es reducir time-to-value sin hipotecar el futuro del código, y si la empresa valora que los datos no salgan de casa, el enfoque local-first y Python-céntrico de Dropbase puede resultar atractivo.

Quien espere un “siguiente, siguiente, finalizar” puramente cloud quizá deba mirar otras opciones o esperar a que el proyecto madure en esa dirección. Pero para el perfil dev que quiere ver, tocar y versionar cada pieza —y no ceder los secretos de su negocio a un backend opaco—, el equilibrio que propone Dropbase es sugerente: IA para acelerar, código para gobernar.

Qué dice el road-testing comunitario

Como en toda herramienta emergente, la experiencia puede variar según entorno. El issue tracker del repositorio recoge casos puntuales —por ejemplo, puesta en marcha en macOS con Docker—, útiles para calibrar compatibilidades y tiempos de adopción en equipos heterogéneos. El valor de un proyecto así no solo depende de su promesa técnica, sino del pulso que mantenga con su comunidad y de la cadencia de correcciones y mejoras.

Conclusión

Dropbase se posiciona en un punto medio difícil pero necesario: llevar la velocidad del prompt-engineering a la construcción de software real, sin renunciar a las garantías que exige un sistema que va a vivir años: control de versiones, revisiones de código, portabilidad y seguridad. Para quienes miran con recelo el vendor lock-in del no-code clásico, su combinación de IA + Python + self-hosting puede ser, como mínimo, una prueba obligada.

Preguntas frecuentes

¿Cómo se activa la IA generativa dentro de Dropbase?

Es necesario añadir la clave de OpenAI o Anthropic en el archivo server.toml, indicando el modelo a utilizar (por ejemplo, gpt-4o). La configuración de LLM debe situarse como tabla en TOML y respetar el orden dentro del archivo. Tras guardar, la interfaz habilita funciones de desarrollo asistido por IA.

¿Qué pasos mínimos necesita para levantarlo en local y crear una app?

Con Docker instalado, se clona el repositorio (git clone), se hace ejecutable el script de arranque (chmod +x start.sh) y se lanza (./start.sh). Después, se accede a http://localhost:3030/apps y se pulsa Create app para generar el primer proyecto.

¿Cómo se conectan bases de datos y APIs de terceros con claves seguras?

Las credenciales y orígenes se definen en worker.toml. Las variables de entorno (por ejemplo, stripe_key o mailgun_api_key) conviven con bloques de configuración de fuentes de datos siguiendo el patrón database.<tipo>.<alias>. Para la demo integrada, debe existir database.sqlite.demo en el archivo.

¿Qué tipo de apps internas puede acelerar desde el día uno?

Casos como editores de datos con interfaz de hoja de cálculo, validación a nivel de celda, búsqueda/filtrado, audit trail y paneles de administración que convierten consultas SQL en vistas operativas con permisos. Son patrones comunes en ops, finanzas y atención al cliente, donde el tiempo de entrega es crítico.

Fuentes: repositorio oficial, documentación y publicaciones del proyecto Dropbase.