Docker ha oficializado la disponibilidad general (GA) de Docker Model Runner (DMR), su propuesta para gestionar, ejecutar y distribuir modelos de IA en local —con los mismos comandos, flujos y políticas que los equipos ya usan con Docker. La meta es clara: hacer pull, run y serve de modelos empaquetados como artefactos OCI, exponerlos por APIs compatibles con OpenAI y enlazar todo ello con Docker Desktop, Docker Engine, Compose y Testcontainers sin añadir nuevas herramientas ni excepciones de seguridad.

¿Qué es DMR y qué problema resuelve?

Docker Model Runner convierte los modelos en artefactos de primera clase dentro del ecosistema Docker. Permite:

- Tirar de modelos desde Docker Hub (como OCI artifacts) o desde Hugging Face si están en GGUF (en cuyo caso el backend de HF los empaqueta “al vuelo” como OCI).

- Servir modelos mediante una API estilo OpenAI, lo que facilita integrar aplicaciones existentes sin reescribir clientes.

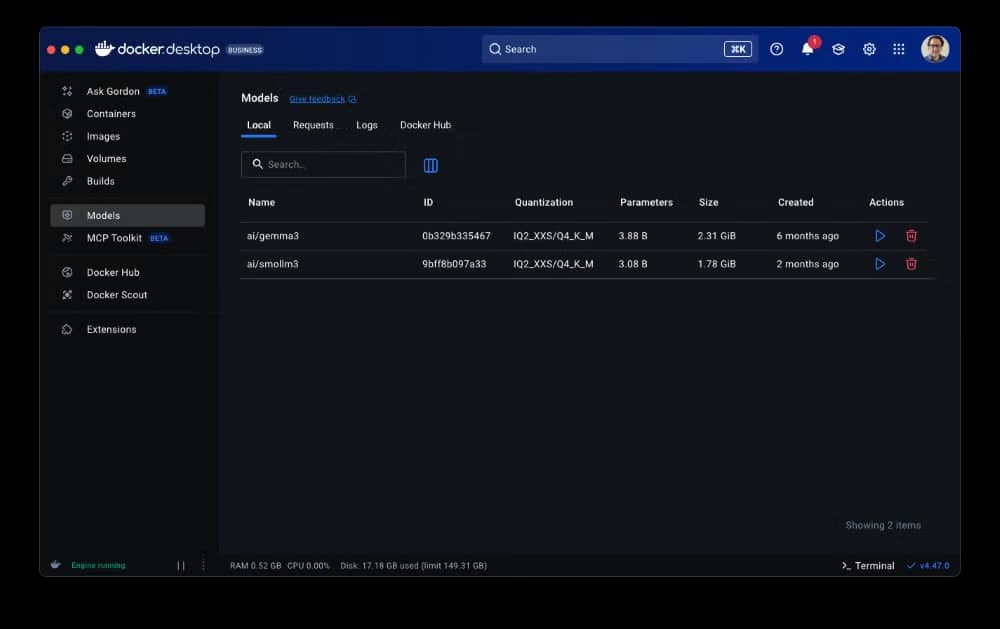

- Trabajar desde CLI y/o UI: ya sea con Docker Desktop (experiencia guiada y gestión automática de recursos) o con Docker CE en Linux para automatización y CI/CD.

La propuesta reduce fricción en el inner loop del desarrollo (probar prompts, tools, agents en el portátil/GPU local), acelera pruebas en pipelines y permite decidir con calma cuándo pasar a despliegues híbridos (local + nube).

Once capacidades que han calado en la comunidad

- Motor sobre

llama.cpp: base sólida hoy, con flexibilidad para añadir motores en el futuro (p. ej., MLX o vLLM). - Aceleración GPU multiplataforma: Apple Silicon en macOS, NVIDIA en Windows y aceleración ARM/Qualcomm gestionadas por Docker Desktop.

- Soporte nativo en Linux: ejecución con Docker CE, ideal para automatización, CI/CD y entornos de producción.

- Experiencia dual CLI/UI: desde la CLI o la pestaña de modelos en Docker Desktop, con onboarding guiado y ajuste automático de RAM/GPU.

- Distribución flexible: pull/push de modelos en OCI desde Docker Hub o pull directo de Hugging Face (GGUF).

- Abierto y gratuito: open source y sin coste, lo que rebaja la barrera de entrada.

- Aislamiento y control: ejecución en entorno sandbox; opciones de seguridad (activar/desactivar, host-side TCP, CORS) para encaje corporativo.

- Inferencia configurable: longitud de contexto y flags de

llama.cpp, con más ajustes en camino. - Depuración integrada: tracing de peticiones/respuestas, inspección de tokens y visibilidad de librerías para optimizar apps.

- Integración con el ecosistema Docker: funciona con Docker Compose, Testcontainers y Docker Offload (descarga en la nube).

- Catálogo de modelos: selección curada en Docker Hub, lista para desarrollo, pipelines, staging o incluso producción.

Por qué encaja en empresa

DMR no exige nuevas excepciones de seguridad o compliance: reutiliza registries privados, controles de acceso por políticas (p. ej., Registry Access Management en Docker Hub), auditoría y trazabilidad ya adoptadas por los equipos de plataforma. Además, empaquetar modelos como OCI artifacts facilita versionado determinista, promoción entre entornos y air-gaps cuando es necesario.

Para equipos que ya estandarizaron Compose y Testcontainers, DMR añade el eslabón de inferencia sin romper el “modo Docker”: lo que se prueba en local se codifica como infraestructura y se explota igual en CI/CD.

Casos de uso donde brilla

- Inner loop con GPU local: probar prompts y tool calling con aceleración en el portátil (Apple Silicon/NVIDIA), sin pelear dependencias de Python.

- CI/CD reproducible: tratar modelos como artefactos OCI, fijando versiones y hashes; ejecutar pruebas deterministas con Testcontainers.

- Privacidad y datos sensibles: inferir dentro del perímetro, sin compartir cargas con terceros en fases de diseño/prueba; decidir descarga a nube cuando compense.

- Apps agénticas: construir agentes que usen DMR como backend de modelo y desplegarlos con Compose, integrando fácilmente otras piezas del stack Docker.

Lo que llega en la hoja de ruta

- Experiencia de uso más fluida: interfaz “tipo chat” más rica en Docker Desktop/CLI, multimodal en UI (ya disponible por API), debug mejorado y más opciones de configuración.

- Más motores de inferencia: soporte para bibliotecas/engines populares (p. ej., MLX, vLLM) y config avanzada por motor y modelo.

- Despliegue independiente: capacidad para ejecutar Model Runner sin Docker Engine en casos de grado productivo.

- Onboarding sin fricciones: guías paso a paso y apps de ejemplo con casos reales y buenas prácticas.

- Catálogo al día: llegada rápida de nuevos modelos a Docker Hub, ejecutables en DMR en cuanto se publiquen.

Limitaciones y trade-offs a tener en cuenta

- Compatibilidad OpenAI API: ya cubre la mayoría de casos; la cobertura seguirá ampliándose iterativamente.

- Aceleración y drivers: revisar requisitos por plataforma (drivers NVIDIA en Windows, Apple Silicon en macOS, configuración en Linux) antes de estandarizar.

- Ergonomía vs. aislamiento: el uso de GPU locales y bindings del host puede requerir ajustes de seguridad que Docker planea endurecer con sandboxing más profundo.

Cómo empezar (sin reinventar tu stack)

- Actualiza e instala Docker Desktop (o usa Docker CE en Linux).

- Activa DMR desde la configuración o la CLI.

- Haz

pullde un modelo (Docker Hub/OCI o Hugging Face/GGUF) y sírvelo por la API compatible con OpenAI. - Decláralo en Compose y llévalo a CI/CD con Testcontainers para reproducibilidad.

Preguntas frecuentes

¿DMR es compatible con la API de OpenAI?

Sí. Expone endpoints compatibles, lo que permite conectar aplicaciones existentes sin cambiar clientes o SDKs.

¿Qué formatos y registries admite para distribuir modelos?

Soporta artefactos OCI (en Docker Hub o cualquier registro OCI-compatible) y GGUF desde Hugging Face, empaquetados como OCI de forma transparente.

¿En qué plataformas y GPUs funciona?

macOS (Apple Silicon), Windows (GPU NVIDIA) y Linux (CPU/GPU con Docker CE). Conviene verificar drivers y compatibilidades por sistema.

¿Qué trae la hoja de ruta tras la GA?

Mejoras de UX (incluida multimodal en la UI), depuración más completa, más motores (MLX, vLLM), config avanzada y despliegue independiente de Docker Engine.

Fuentes

- Docker — Docker Model Runner: Now Generally Available (GA): https://www.docker.com/blog/announcing-docker-model-runner-ga/

- Documentación oficial — Docker Model Runner: https://docs.docker.com/ai/model-runner/

- Docker — Behind the scenes: How we designed Docker Model Runner and what’s next: https://www.docker.com/blog/how-we-designed-model-runner-and-whats-next/