Durante años, plataformas como Heroku, Vercel o Railway han vendido una idea muy atractiva: sube tu código, configura unas variables y despliega. Sin pelearte con servidores, sin tocar redes, sin aprender Kubernetes. El problema es que esa comodidad suele venir con dos peajes: coste creciente a medida que el proyecto escala y dependencia de un proveedor que decide precios, límites y reglas.

En ese hueco aparece dFlow, un proyecto open source que se define como alternativa a Railway/Vercel/Heroku, pero con un matiz clave: está pensado para ejecutarse en tu infraestructura (o en el proveedor cloud que tú elijas).

Qué es dFlow y qué intenta resolver

dFlow se presenta como una plataforma “self-hosted” de despliegue e infraestructura orientada a equipos que quieren mantener el control de sus servidores sin asumir la complejidad típica del DevOps tradicional. En su documentación lo resume con una frase muy directa: un “alternativa más simple” a Vercel/Railway/Heroku, diseñada para autoalojarse y usarse en escenarios reales de producción.

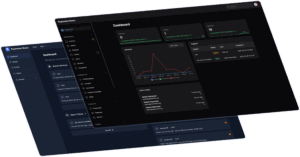

La propuesta va más allá de “hacer deploy”:

- Un panel para gestionar proyectos, dominios y entornos.

- Automatización de workflows: despliegues, tareas programadas (cron), logs y monitorización.

- Soporte de bases de datos habituales y servicios asociados.

- Gestión multi-servidor, con foco en simplificar el día a día.

Un enfoque peculiar: orquestación multi-servidor “sin Kubernetes”

Uno de los puntos más llamativos de dFlow es su posicionamiento técnico: la documentación destaca la orquestación multi-servidor sobre SSH y la idea de escalar “sin contenedores o Kubernetes” en la capa de orquestación tradicional.

Esto no significa que “no use Docker” (de hecho, para autoalojar la propia plataforma recomiendan Docker Compose), sino que intenta evitar que el usuario tenga que montar un entramado de herramientas y YAMLs para el ciclo básico de desplegar y operar.

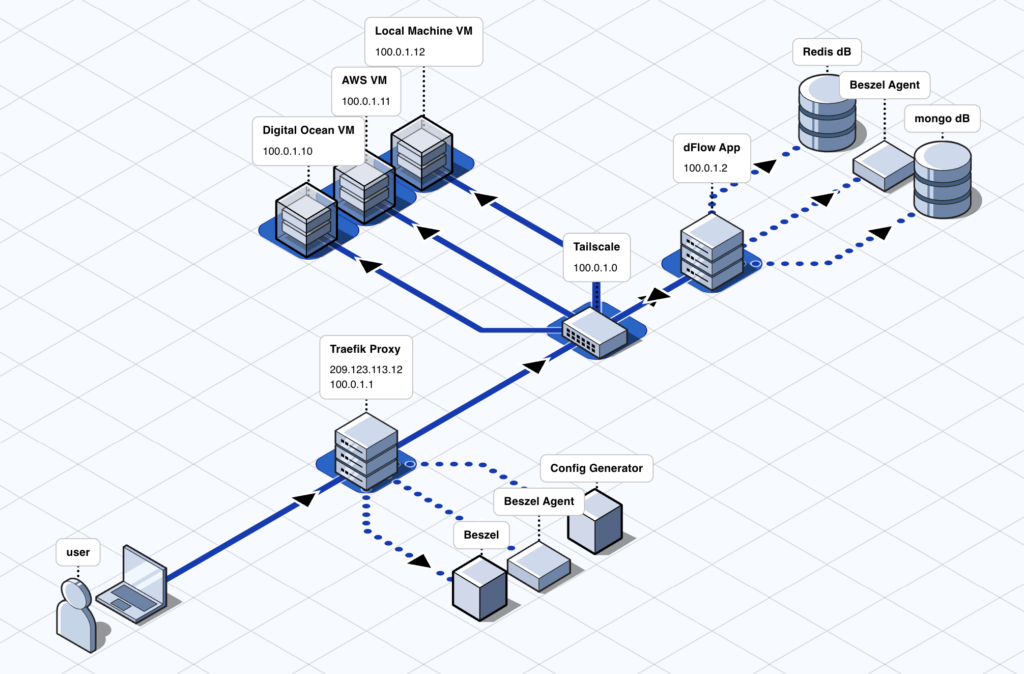

Seguridad y red privada: “Zero Trust” con Tailscale

En el discurso de dFlow hay otra palabra recurrente: red privada. El repositorio oficial menciona soporte Zero Trust con Tailscale (cifrado extremo a extremo) y la promesa de no depender de llaves SSH para operar.

Para equipos que despliegan servicios internos o apps de clientes en infra propia, este punto es relevante: reduce fricción en el acceso remoto y encaja con una tendencia clara del self-hosting moderno: exponer menos servicios a Internet y operar dentro de una malla privada.

Qué puedes desplegar: repos, imágenes y bases de datos

dFlow presume de “deploy anything”: permite desplegar repositorios Git públicos o privados, imágenes Docker y también servicios de base de datos comunes (Postgres, MongoDB, MySQL/MariaDB, Redis).

Además incluye:

- RBAC (roles y permisos) para separar administradores y usuarios.

- Plantillas para arrancar despliegues con stacks populares.

- White labeling (marca blanca): posibilidad de adaptar marca y dominios, algo especialmente útil para agencias.

Qué hay “debajo del capó” cuando lo autoalojas

Si se opta por self-hosting, la propia documentación describe un despliegue con Docker Compose y componentes concretos: Traefik como reverse proxy con SSL automático (Let’s Encrypt), MongoDB para persistencia, Redis para caché y trabajos en segundo plano, Beszel para monitorización, un config generator para routing dinámico y Payload CMS como parte central de la plataforma.

Este detalle es importante por dos motivos:

- Permite hacerse una idea de qué tipo de “control plane” estás montando (no es un binario único).

- Aclara por qué dFlow puede pedir recursos razonables si se quiere montar algo “production-grade”.

Requisitos: aquí conviene leer la letra pequeña

En el README del repositorio, dFlow habla de mínimos modestos (por ejemplo, Ubuntu 22.04/24.04, desde 1 vCPU/2 GB RAM, recomendado 2 vCPU/8 GB).

Sin embargo, en su documentación de instalación aparece una recomendación más exigente para el servidor (mínimo 6 vCPU y 12 GB RAM, y almacenamiento SSD/NVMe), además de puertos 80/443, Docker 20.10+ y Docker Compose 2+.

La lectura razonable es que los mínimos del README sirven para “arrancar y probar”, mientras que la guía oficial apunta a un despliegue más robusto, especialmente si se van a gestionar varios servicios y equipos.

Estado del proyecto: evolución rápida y foco en migraciones

dFlow no se esconde: es un proyecto en movimiento. En GitHub muestra varias releases y, a finales de 2025, figura una versión v0.4.4 publicada en noviembre, lo que sugiere iteración frecuente.

El roadmap público también apunta a una prioridad clara: hacer más fácil el salto desde Railway, incluyendo automatización para migrar configuraciones y servicios, y funciones como migración de bases de datos entre servidores o backups de bases de datos externas.

¿Para quién tiene más sentido?

dFlow encaja especialmente bien en tres perfiles, que la propia documentación menciona como objetivo:

- Indie developers que quieren desplegar en 1–3 servidores sin volverse “equipo de SRE”.

- Startups que necesitan automatización sin el coste variable típico de PaaS a medida que crecen.

- Agencias que gestionan múltiples proyectos y valoran RBAC y marca blanca.

En todos los casos, el argumento de fondo es el mismo: mantener control (y a menudo reducir coste) sin renunciar a la experiencia “sube y despliega”.

Cómo empezar, sin complicarse

Para un primer contacto, dFlow ofrece dos caminos habituales:

- Probar el producto en demo/instancia alojada para ver panel y flujo de despliegue antes de tocar servidores.

- Autoalojarlo: el repositorio propone un instalador “curl | bash” (práctico, pero conviene revisarlo y entender qué hace antes de ejecutarlo en producción) y la documentación recomienda Docker Compose como vía estable.

Preguntas frecuentes

¿dFlow sustituye a Kubernetes?

No exactamente. dFlow intenta evitarte la complejidad de un stack de orquestación clásico para el flujo de despliegue y operación, y su documentación enfatiza la gestión multi-servidor sobre SSH como enfoque.

¿Puedo desplegar bases de datos además de aplicaciones?

Sí: el proyecto menciona despliegue de bases de datos como Postgres, MongoDB, MySQL/MariaDB y Redis, además de repos Git e imágenes Docker.

¿Es apto para producción o está “verde”?

Tiene guía de despliegue “production-grade” (Docker Compose con Traefik, Redis, MongoDB y monitorización), pero también muestra que evoluciona rápido (releases frecuentes) y un roadmap con funciones todavía en desarrollo.

¿Qué aporta Tailscale aquí?

dFlow lo usa como pilar de su enfoque Zero Trust/red privada, con cifrado extremo a extremo y operación sin depender de llaves SSH según su propio repositorio y web.