La inteligencia artificial generativa sigue avanzando rápidamente, y herramientas como la Generación Aumentada por Recuperación (RAG, por sus siglas en inglés) se han convertido en esenciales para mejorar la precisión y confiabilidad de las respuestas generadas por estos sistemas. RAG permite integrar datos adicionales no considerados durante el entrenamiento de los modelos de lenguaje, lo que ayuda a minimizar la presencia de información falsa o engañosa, conocida en el ámbito de la IA como «alucinaciones».

Con la creciente integración de los sistemas de inteligencia artificial en nuestra vida diaria y en procesos críticos de toma de decisiones, detectar y mitigar estas alucinaciones es cada vez más crucial. Hasta ahora, la mayoría de las técnicas se centran únicamente en la pregunta y la respuesta, pero el contexto adicional proporcionado por RAG permite introducir nuevas estrategias para abordar mejor este desafío.

Diversos métodos están disponibles para crear un sistema de detección de alucinaciones en aplicaciones basadas en RAG. El análisis de estas técnicas permite evaluar sus pros y contras en términos de precisión, recuperación y costo. Las innovaciones actuales buscan ofrecer métodos accesibles que se puedan incorporar rápidamente en las canalizaciones de RAG, mejorando así la calidad de las respuestas generadas.

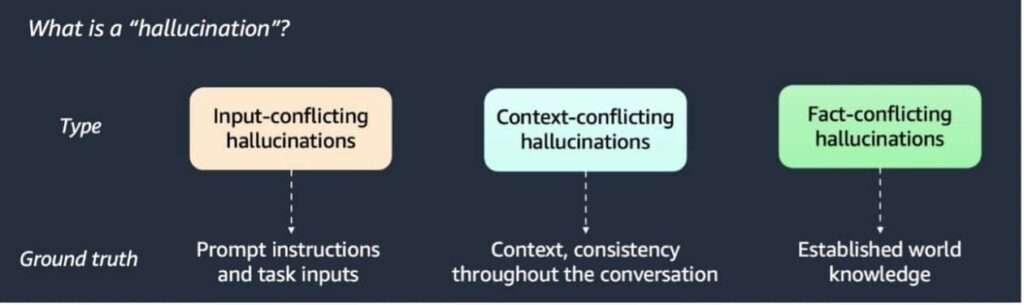

Se identifican tres tipos de alucinaciones, y se han propuesto múltiples técnicas para su detección, incluyendo el detector basado en modelos de lenguaje grande (LLM), el detector de similitud semántica y el verificador estocástico BERT. Cada método varía en eficacia y rendimiento según los conjuntos de datos evaluados, como artículos de Wikipedia y datos generados sintéticamente.

En cuanto a los requisitos técnicos, se necesita una cuenta de AWS con acceso a herramientas como Amazon SageMaker y Amazon S3. Para que un sistema RAG funcione adecuadamente, se deben almacenar tres elementos: el contexto relevante, la pregunta y la respuesta del modelo de lenguaje.

El uso de detección basada en LLM permite clasificar las respuestas del sistema RAG al verificar si entran en conflicto con el contexto. Por su parte, los métodos de similitud semántica y comparación de tokens ofrecen distintos enfoques para identificar inconsistencias, y se ha demostrado que el verificador BERT es altamente eficaz en la recuperación de información, aunque con un costo adicional.

Comparaciones entre las distintas técnicas sugieren que el enfoque basado en LLM logra un buen equilibrio entre precisión y costo. De este modo, se recomienda un enfoque híbrido que combine un detector de similitud de tokens con uno basado en LLM, subrayando la importancia de la adaptabilidad y el análisis en las aplicaciones de inteligencia artificial generativa.

En conclusión, a medida que las aplicaciones de RAG continúan evolucionando, los métodos de detección de alucinaciones serán herramientas fundamentales para mejorar la fiabilidad y la confianza en estos sistemas.