Desplegar modelos de aprendizaje automático (ML) en producción es una tarea que tradicionalmente exige un alto grado de conocimiento técnico y recursos considerables. Este desafío es particularmente notable para aquellas empresas que carecen de experiencia profunda en áreas como ML y DevOps. Para abordar esta problemática, Amazon SageMaker Canvas ha introducido una solución revolucionaria, facilitando el proceso mediante una interfaz de no-código. Esto permite a los usuarios construir modelos de ML con alta precisión a partir de sus datos existentes, eliminando la necesidad de escribir código.

Sin embargo, la creación de un modelo es solo una parte del proceso completo. La implementación eficiente y económica es igualmente crucial. Amazon SageMaker Serverless Inference está diseñado para gestionar eficazmente las cargas de trabajo con patrones de tráfico variables y períodos de inactividad. Este servicio maneja automáticamente la provisión y el escalado de la infraestructura basándose en la demanda, eliminando así la necesidad de gestionar servidores o preconfigurar la capacidad.

Para aquellos que desean desplegar un modelo de ML creado en SageMaker Canvas mediante SageMaker Serverless Inference, existe un flujo de trabajo simplificado. Comienza con añadir el modelo entrenado al registro de modelos de SageMaker y culmina con la creación de un endpoint sin servidor. Este enfoque eficiente permite pasar rápidamente de la creación del modelo a obtener predicciones listas para producción, sin necesidad de gestionar ninguna infraestructura.

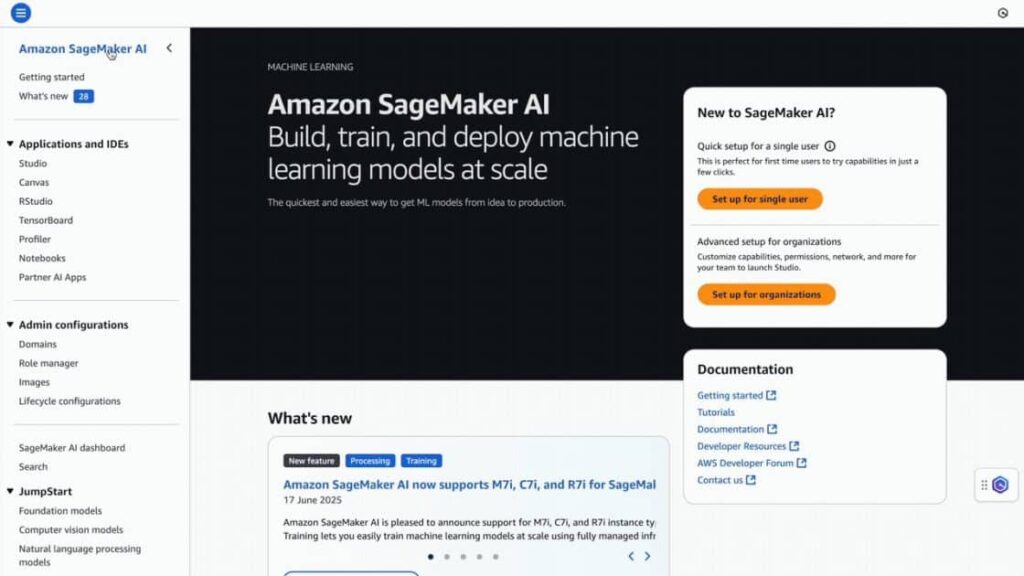

Para llevar a cabo este proceso, se requiere tener acceso tanto a Amazon S3 como a Amazon SageMaker AI. Es necesario contar con un modelo de regresión o clasificación ya entrenado. El procedimiento comienza con guardar el modelo en el registro de modelos de SageMaker y, posteriormente, aprobarlo para su despliegue.

La creación de un nuevo modelo implica nombrarlo, seleccionar la opción adecuada del contenedor y agregar las variables de entorno necesarias. Luego, se procede a configurar el endpoint y crear el mismo.

Con esta arquitectura, las empresas tienen la oportunidad de implementar modelos de ML de manera simplificada, permitiendo que organizaciones de todos los tamaños y niveles técnicos accedan al potencial completo de la inteligencia artificial y el aprendizaje automático. Utilizando estas herramientas, se minimiza la complejidad de la gestión de infraestructuras, lo que permite a los equipos comenzar a recibir predicciones rápidamente y de manera efectiva.