En los últimos años, la inteligencia artificial generativa ha dado pasos agigantados gracias a significativas inversiones en el desarrollo de modelos de lenguaje. Destacan ejemplos como Claude Opus 4 y Sonnet 4 de Anthropic, junto con Amazon Nova y Bedrock. Estos modelos no solo son capaces de razonar, redactar y generar respuestas con una creciente sofisticación, sino que también enfrentan el desafío de estar limitados por la información accesible, un problema crucial para muchas empresas.

Tres obstáculos principales suelen surgir para las compañías: los silos informáticos que aíslan datos valiosos tras APIs personalizadas, la complejidad de integración que requiere conectores específicos para cada fuente de datos y los cuellos de botella en escalabilidad al intentar conectar modelos a múltiples sistemas. Estas dificultades han resaltado la necesidad de soluciones más eficientes, como el Protocolo de Contexto de Modelo (MCP).

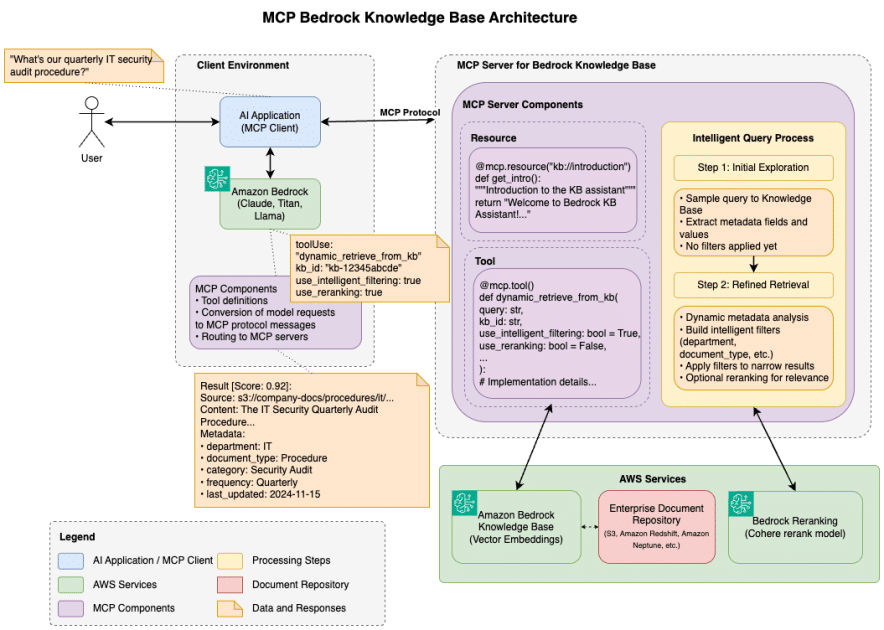

El MCP, desarrollado por Anthropic como un proyecto de código abierto, introduce un lenguaje universal que permite a los sistemas de IA comunicarse con fuentes de datos externas de forma estandarizada. Funciona en una arquitectura cliente-servidor donde las aplicaciones de IA actúan como clientes que requieren acceso a los datos, mientras que los servidores MCP proporcionan acceso estandarizado a diversas fuentes de información.

Este protocolo simplifica el complejo problema de integración M×N, donde M representa aplicaciones de IA y N diversas fuentes de datos, facilitando el trabajo necesario para establecer conexiones. Con esta arquitectura, las organizaciones pueden crear soluciones de IA eficientes y escalables, aprovechando también las capacidades de seguridad de Amazon Web Services (AWS), como la gestión de identidad y acceso.

Especialmente beneficioso para los usuarios de AWS, el MCP mejora la integración de los modelos de lenguaje de Amazon Bedrock con los servicios de datos de AWS, produciendo soluciones más modulares y escalables. Esto permite una experiencia de usuario que combina capacidades de IA con acceso a datos pertinentes, reduciendo a su vez los costos de desarrollo y mantenimiento.

Mirando hacia el futuro, el MCP continúa evolucionando con nuevas capacidades implementadas regularmente. Incluye un nuevo nivel de transporte HTTP diseñado para facilitar los despliegues a gran escala, garantizando una integración segura y eficiente entre las aplicaciones de IA y la amplia variedad de servicios de AWS.

En conclusión, el Protocolo de Contexto de Modelo no solo representa un avance significativo en la interacción de las aplicaciones de IA con los datos empresariales, sino que también ofrece una visión clara para que las organizaciones maximicen el potencial de esta tecnología en el futuro.