Amazon ha presentado una nueva actualización de su plataforma Amazon SageMaker, diseñada para permitir a los usuarios crear, entrenar y desplegar modelos de aprendizaje automático (ML) de manera escalable y a medida. Esta innovación es de particular importancia para sectores que necesitan soluciones personalizadas, tales como el análisis geoespacial, la bioinformática o los modelos de aprendizaje cuántico.

La plataforma SageMaker ahora ofrece la posibilidad a los desarrolladores de ampliar su funcionalidad mediante contenedores personalizados, permitiendo la incorporación de modelos y dependencias de software específicos que no están disponibles en las imágenes de contenedor preexistentes gestionadas por SageMaker. Recientemente, se ha publicado una guía que destaca el uso del modelo Prithvi, desarrollado con la colaboración de NASA e IBM. Este modelo, basado en una arquitectura de transformadores de visión temporal, ha sido entrenado con datos de satélites Landsat y Sentinel 2.

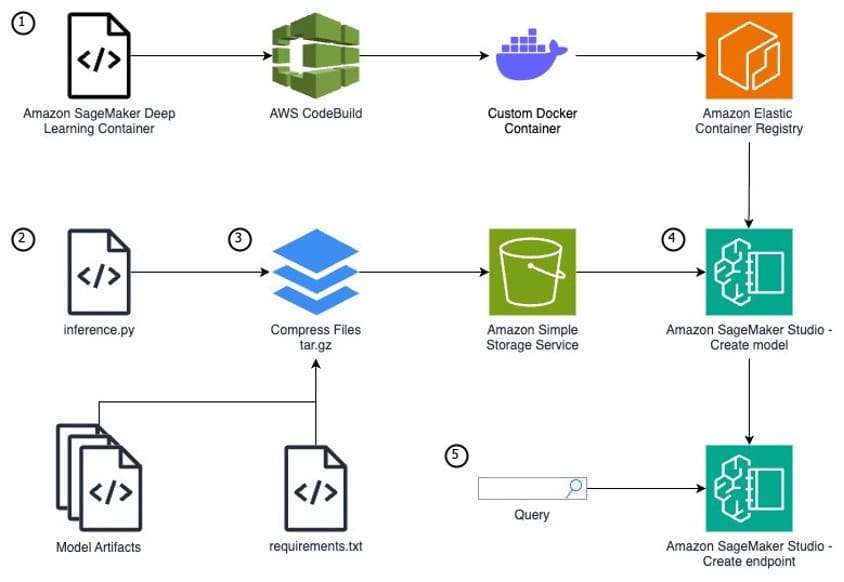

El modelo Prithvi se adapta para tareas como la detección de cicatrices por incendios, la clasificación de cultivos y la cartografía de inundaciones, gracias al uso de la biblioteca mmsegmentation. Implementar modelos personalizados en SageMaker implica un proceso que incluye crear definiciones de modelos personalizados, preparar artefactos y archivos de inferencia estructurados correctamente y subir estos elementos a Amazon S3.

Una de las grandes ventajas de estas nuevas capacidades es la posibilidad de integrar librerías y paquetes adicionales que no están presentes en las imágenes estándar de contenedor, ofreciendo a investigadores y desarrolladores un control total sobre el entorno y las dependencias de sus modelos.

El despliegue de un modelo en SageMaker requiere construir una imagen de contenedor que contenga el modelo y sus dependencias, crear un archivo de especificación de compilación y seguir una serie de pasos a través de la interfaz de Amazon SageMaker Studio. Una vez configurada la infraestructura, es posible poner a prueba el endpoint de inferencia mediante la creación de casos de prueba que envían imágenes a ser procesadas para recibir predicciones en tiempo real.

Este avance evidencia el compromiso continuo de Amazon con la innovación en el área del aprendizaje automático, proporcionando a los desarrolladores e investigadores herramientas avanzadas y personalizables que facilitan la implementación de soluciones complejas. En un contexto donde el uso de la inteligencia artificial y el análisis de datos continúa su expansión, SageMaker se posiciona como una plataforma esencial para el desarrollo y aplicación de modelos de machine learning adaptados a necesidades concretas.