La potencia informática se ha multiplicado por cientos de millones en medio siglo

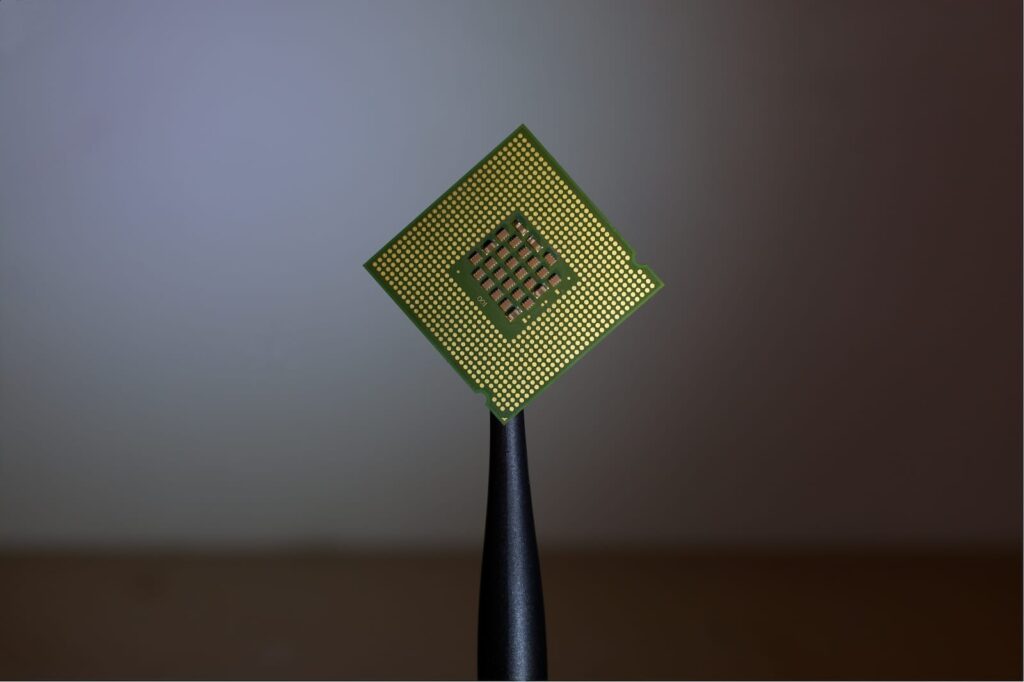

En solo cinco décadas, la humanidad ha sido testigo de una transformación tecnológica sin precedentes. Hemos pasado de procesadores capaces de realizar decenas de miles de instrucciones por segundo a chips que ejecutan billones de operaciones en el mismo tiempo. Una evolución vertiginosa que ha transformado radicalmente el mundo, desde los humildes comienzos del Intel 4004 hasta los colosos modernos como NVIDIA Blackwell, núcleo de la actual era de la inteligencia artificial.

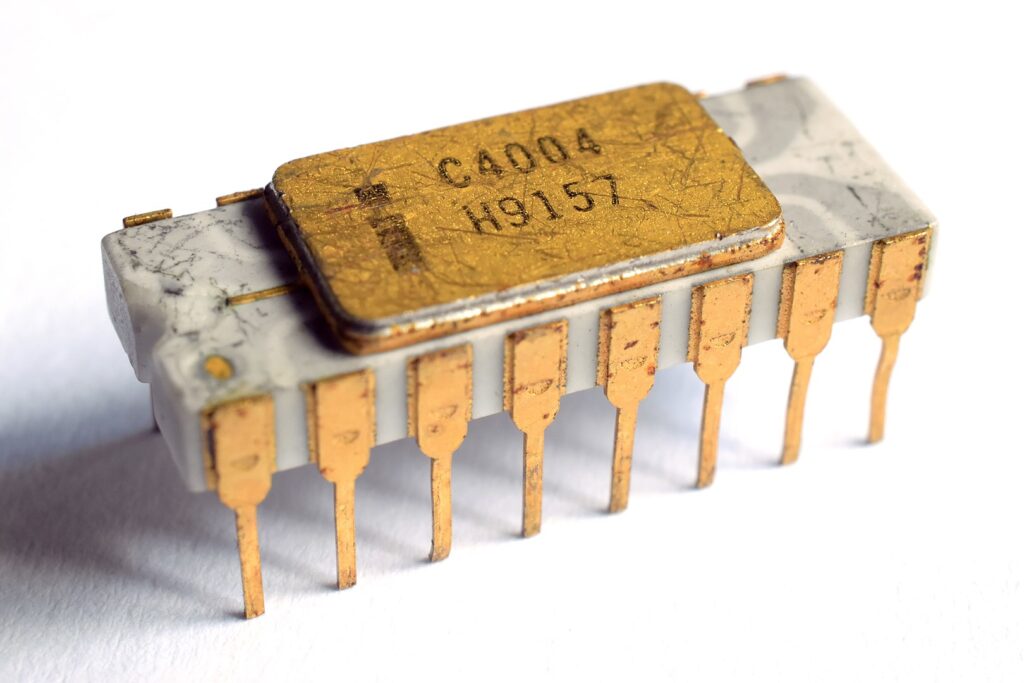

El nacimiento de una era: Intel 4004

El 15 de noviembre de 1971 marcó un punto de inflexión en la historia de la humanidad. Ese día, Intel, en colaboración con la empresa japonesa Busicom, lanzó el primer microprocesador comercial del mundo: el Intel 4004. Este chip de 4 bits, con una frecuencia de reloj de apenas 740 kHz y una capacidad de ejecución de 92.600 instrucciones por segundo (IPS), tenía como destino inicial una calculadora de sobremesa japonesa.

Con tan solo 4 KB de memoria de programa y 640 bytes de RAM, parecía modesto incluso para los estándares de aquella época. Sin embargo, el 4004 marcó un antes y un después: abría la puerta a una informática programable, versátil y en miniatura. Federico Faggin, Ted Hoff y Stan Mazor fueron los cerebros detrás de esta revolución, con Faggin desarrollando la innovadora tecnología Silicon Gate que hizo posible integrar 2.300 transistores en un chip del tamaño de una uña.

La historia detrás del 4004 es fascinante: inicialmente, Busicom había solicitado 12 chips personalizados para su calculadora. Los ingenieros de Intel propusieron una solución más elegante: solo 4 chips, incluyendo uno programable. Cuando el mercado de calculadoras se desplomó durante el desarrollo, Intel recompró los derechos exclusivos a Busicom por $60.000. Una decisión que cambiaría el curso de la historia tecnológica.

Moore tenía razón: la profecía que marcó medio siglo

En 1965, Gordon Moore, cofundador de Intel, observó que el número de transistores en un chip se duplicaba aproximadamente cada dos años. Lo que comenzó como una observación empírica se convirtió en la brújula que guió la industria durante décadas. Aunque muchos pronosticadores, incluido el propio Gordon Moore, predicen que la Ley de Moore terminará alrededor de 2025, ha servido como motor de una carrera imparable por aumentar la potencia de cálculo.

Esta tendencia, combinada con innovaciones en arquitectura, sistemas paralelos, multinúcleo y procesamiento gráfico, ha resultado en un salto exponencial que nos ha llevado a multiplicar por cientos de millones la capacidad computacional desde el 4004. La capacidad computacional de las computadoras ha aumentado exponencialmente, duplicándose cada 1.5 años, desde 1975 hasta 2009.

Del silicio humilde al silicio inteligente: el salto a Blackwell

NVIDIA, líder indiscutible en hardware para inteligencia artificial, ha llevado este avance a una nueva dimensión con su arquitectura Blackwell, nombrada en honor a David Harold Blackwell, matemático especializado en teoría de juegos y estadísticas, y el primer académico negro inducto en la Academia Nacional de Ciencias.

NVIDIA Blackwell es la GPU más grande jamás creada, con 208 mil millones de transistores—más de 2.5 veces los transistores de las GPU Hopper de NVIDIA. Utiliza el proceso TSMC 4NP desarrollado específicamente para NVIDIA y ofrece un rendimiento computacional revolucionario, alcanzando 20 petaFLOPS en un solo chip.

La arquitectura Blackwell representa un cambio paradigmático. Mientras el 4004 era un procesador secuencial diseñado para calculadoras, Blackwell es una arquitectura pensada para la computación paralela extrema. El chip GB100 contiene 104 mil millones de transistores, un aumento del 30% sobre los 80 mil millones de transistores del die GH100 de la generación anterior Hopper. Para no estar limitado por el tamaño del die, el acelerador B100 de NVIDIA utiliza dos dies GB100 en un solo paquete, conectados con un enlace de 10 TB/s que NVIDIA llama la Interfaz de Alto Ancho de Banda NV (NV-HBI).

La magnitud del salto: números que desafían la comprensión

Para entender la magnitud de esta transformación, consideremos las cifras:

- Intel 4004 (1971): 92.600 instrucciones por segundo

- NVIDIA Blackwell (2024): Más de 20 petaFLOPS (20.000 billones de operaciones por segundo)

Esto representa un incremento de aproximadamente 216 millones de veces en capacidad de procesamiento en poco más de 50 años. Para poner esto en perspectiva, es como si un automóvil que viajaba a 1 km/h en 1971 ahora pudiera viajar a 216 millones de km/h.

Más allá del hardware: una transformación civilizacional

Esta evolución no ha sido meramente técnica. La informática pasó de ser una disciplina de nicho para científicos y militares, a convertirse en el pilar invisible de la vida moderna. Desde los smartphones hasta los modelos de lenguaje, los coches autónomos o la biotecnología, cada aspecto de nuestra existencia está tocado por esta revolución silenciosa.

Como recordaba Jensen Huang, CEO de NVIDIA, durante la presentación de Blackwell: «Durante tres décadas hemos perseguido la computación acelerada, con el objetivo de habilitar avances transformadores como el aprendizaje profundo y la IA. La IA generativa es la tecnología definitoria de nuestro tiempo».

Los números hablan por sí solos: El clúster NVIDIA GB200 NVL72 permite el procesamiento acelerado de datos, ofreciendo hasta 18 veces más rendimiento en consultas de bases de datos que las CPU tradicionales. NVIDIA Blackwell incluye un motor de descompresión y la capacidad de acceder a cantidades masivas de memoria en la CPU NVIDIA Grace a través de un enlace de alta velocidad—900 gigabytes por segundo (GB/s) de ancho de banda bidireccional.

Los desafíos del presente: cuando la física impone límites

Sin embargo, esta carrera exponencial enfrenta desafíos sin precedentes. El impulsor tecnológico clásico que ha respaldado la Ley de Moore durante los últimos 50 años está fallando y se prevé que se aplaste hacia 2025. Los arquitectos de microprocesadores reportan que desde alrededor de 2010, el avance de semiconductores se ha ralentizado en toda la industria por debajo del ritmo predicho por la Ley de Moore.

Los obstáculos son fundamentales:

Límites físicos: La velocidad de la luz es finita, constante y proporciona una limitación natural en el número de cálculos que un solo transistor puede procesar. Los transistores ya pueden medirse a escala atómica, con los más pequeños disponibles comercialmente de solo 3 nanómetros de ancho, apenas más anchos que una hebra de ADN humano (2.5nm).

Costos exponenciales: El costo de fabricar un nuevo chip de 10 nm es de alrededor de $170 millones, casi $300 millones para un chip de 7 nm y más de $500 millones para un chip de 5 nm.

Lo que nos espera: más allá del silicio

En términos históricos, 50 años no son nada. Y sin embargo, la distancia tecnológica entre 1971 y 2025 parece mayor que entre la Edad de Bronce y la Revolución Industrial. Tecnologías como la comunicación inalámbrica, la computación en la nube, la física cuántica y el Internet de las Cosas (IoT) convergerán para impulsar la innovación en la computación, mejorando la eficiencia, la conectividad y el poder de procesamiento.

Las alternativas están emergiendo:

- Computación cuántica: Las computadoras cuánticas se basan en qubits (bits cuánticos) y usan efectos cuánticos como la superposición y el entrelazamiento para su beneficio, superando así el problema de la miniaturización.

- Arquitecturas especializadas: GPUs han sido ya utilizadas para entrenamiento de IA durante más de una década. En años recientes, Google introdujo TPUs (unidades de procesamiento tensor) para impulsar la IA y ahora hay más de 50 compañías fabricando chips de IA.

- Optimización de software: Los autores fueron capaces de lograr 5 órdenes de magnitud en mejoras de velocidad en ciertas aplicaciones solo optimizando métodos de codificación.

Reflexión final: una historia humana

Como reconoce Elizabeth Jones, historiadora de Intel Corporation: «Es una historia de reducir las cosas. Y al reducirlas, aumentas el potencial de los lugares a los que pueden ir y las cosas que pueden pasar».

La historia de la computación es, en el fondo, una historia humana: de visión, ingenio y ambición desmedida. Si en 1971 se necesitaba una habitación entera para lo que hoy cabe en un chip del tamaño de una uña, ¿hasta dónde llegaremos en los próximos 50 años?

La respuesta quizás no esté solo en el silicio, sino en la inteligencia que estamos aprendiendo a construir. Como observa la historiadora de Intel: «Tenemos mucho más que una calculadora en nuestro bolsillo, gracias al Intel 4004». Y ese «mucho más» apenas está comenzando a revelarse.

La revolución continúa, y nosotros somos tanto sus arquitectos como sus testigos privilegiados.

50 years of human ingenuity. Amazing progress.

— Pushkar Ranade (@magicsilicon) July 27, 2025

The power of exponential growth! pic.twitter.com/3oGikx31UB