En los últimos meses, el uso de modelos de lenguaje de gran escala ha experimentado un notable auge en el ámbito empresarial, gracias a su capacidad para mejorar la atención al cliente y optimizar el rendimiento de los equipos internos. Muchas organizaciones han comenzado a utilizar asistentes virtuales basados en la generación aumentada por recuperación, que aprovechan el poder de estos modelos de lenguaje para consultar documentos específicos de la empresa y ofrecer respuestas adaptadas a sus necesidades particulares.

Un avance destacado en este campo ha sido el desarrollo de modelos fundacionales multimodales, capaces de interpretar y generar texto a partir de imágenes, integrando la información visual con el lenguaje natural. Sin embargo, estos modelos aún presentan la limitación de depender únicamente de la información contenida en sus datos de entrenamiento.

En este entorno, Amazon Web Services (AWS) ha innovado al demostrar cómo construir un chatbot multimodal utilizando su plataforma Amazon Bedrock. Este sistema permite a los usuarios enviar imágenes y preguntas, obteniendo respuestas basadas en un conjunto cerrado de documentos propietarios. Un caso práctico podría ser el uso de este asistente en la industria minorista para potenciar la venta de productos, o en el sector de la manufactura, facilitando la reparación y mantenimiento de maquinaria.

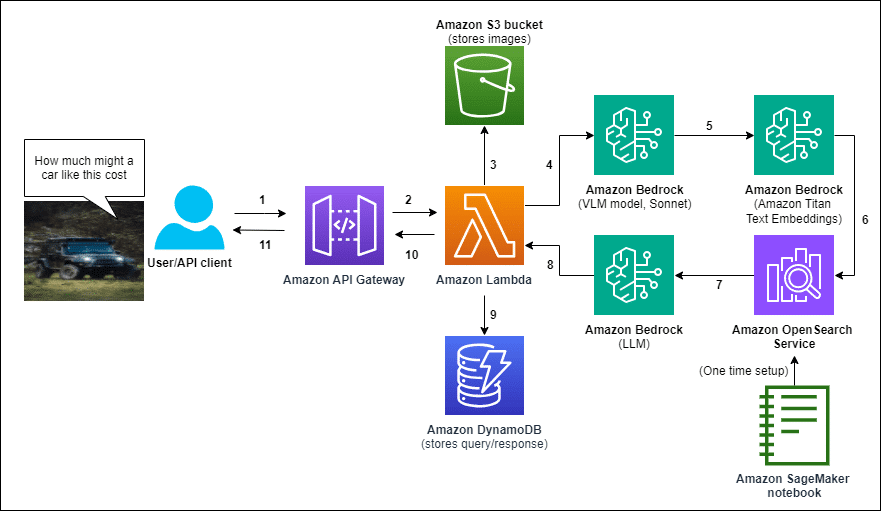

La propuesta de AWS inicia con la creación de una base de datos vectorial de documentos relevantes mediante Amazon OpenSearch Service. Posteriormente, se despliega el asistente completo a través de una plantilla de AWS CloudFormation. El flujo operativo comienza cuando un usuario sube una imagen y hace una pregunta, que se procesan a través de Amazon API Gateway y una función de AWS Lambda. La imagen se almacena en Amazon S3 para posibles futuros análisis.

AWS Lambda coordina las llamadas a los modelos de Amazon Bedrock para elaborar una descripción textual de la imagen, convertir la pregunta y esta descripción en representaciones vectoriales, recuperar información relevante de OpenSearch, y generar una respuesta basada en los documentos obtenidos. Finalmente, tanto la consulta del usuario como la respuesta se almacenan en Amazon DynamoDB, vinculadas con el identificador de la imagen en S3.

Este innovador sistema ofrece una ventaja significativa para sectores que requieran respuestas específicas basadas en sus propios datos a partir de entradas multimodales. Un ejemplo aplicado se encuentra en un mercado de automóviles, donde los usuarios pueden subir una imagen de un vehículo y recibir respuestas fundamentadas en una base de datos propia de listados de automóviles, demostrando así la versatilidad de esta tecnología.

La solución no solo mejora la experiencia del usuario al proporcionar respuestas precisas y contextualizadas, sino que también incrementa la eficiencia operativa. Además, su diseño permite una personalización y escalabilidad significativas, posibilitando que las empresas adapten el asistente a sus requerimientos específicos y exploren nuevas formas de interacción entre humanos y máquinas.