Las empresas del sector asegurador enfrentan constantes desafíos al procesar grandes volúmenes de datos no estructurados que provienen de diversos formatos, tales como PDFs, hojas de cálculo, imágenes, videos y audios. La información contenida en documentos de reclamación, videos de accidentes, transcripciones de chats o pólizas de seguro es crucial para el ciclo de procesamiento de reclamaciones.

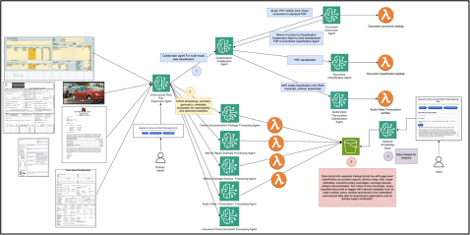

Los métodos tradicionales de preprocesamiento de datos presentan limitaciones en precisión y consistencia, afectando la extracción de metadatos, la velocidad del flujo de trabajo y la eficacia del uso de datos en inteligencia artificial para detectar fraudes o analizar riesgos. Para superar estas barreras, se ha desarrollado un sistema colaborativo de múltiples agentes especializados en tareas como clasificación, conversión y extracción de metadatos. Este enfoque orquestado automatiza la ingestión y transformación de datos no estructurados, mejorando la precisión y habilitando un análisis exhaustivo.

Para organizaciones con menor volumen de documentos homogéneos, un agente único es suficiente. Sin embargo, para datos variados, como documentos de reclamación o videos de colisiones, la arquitectura de múltiples agentes ofrece ventajas significativas. Cada agente especializado permite una extracción más precisa gracias a la ingeniería de prompts dirigida, facilitando una mejora continua basada en el feedback de expertos del dominio.

El sistema puede respaldarse con herramientas como Amazon Bedrock, que facilita la creación de aplicaciones de inteligencia artificial generativa con modelos de empresas líderes. Amazon Bedrock permite el desarrollo de agentes inteligentes conscientes del dominio que pueden procesar información a gran escala, adaptándose a flujos de trabajo dinámicos.

Este centro de preprocesamiento de datos clasifica, extrae metadatos, convierte documentos y valida campos inciertos a través de intervención humana. Los datos resultantes enriquecidos nutren un lago de datos no estructurados, sentando las bases para una avanzada detección de fraudes y análisis.

El flujo de trabajo está centrado en un agente supervisor, con agentes especializados en tareas clave, y Amazon S3 como destino final de los datos. La modularidad permite una gestión más escalable y robusta, reduciendo el tiempo de validación humana y mejorando la precisión de la extracción de metadatos. La integración de conocimientos humanos asegura que la calidad de los datos mejore continuamente.

La transformación de datos no estructurados en salidas ricas en metadatos permite a las empresas acelerar la detección de fraudes, optimizar perfiles de clientes y facilitar decisiones basadas en análisis avanzados. Este sistema evolucionará para reducir la necesidad de intervención humana, potenciando la automatización completa y consolidando su papel en el procesamiento de reclamaciones en el futuro de la industria aseguradora.