En el mundo de la inteligencia artificial, las aplicaciones modernas demandan eficiencias en tiempos de respuesta y costos, especialmente al manejar documentos extensos y mantener interacciones prolongadas. Sin embargo, la inferencia de modelos de lenguaje grande (LLM) enfrenta desafíos a medida que la longitud del contexto se incrementa, lo que resulta en una mayor latencia y costos elevados.

Cada nuevo token generado por un LLM requiere recalcular los mecanismos de atención para los tokens anteriores, lo que implica una considerable sobrecarga computacional, particularmente en secuencias largas. Aquí es donde entra en juego el almacenamiento en caché de clave-valor (KV), que permite reutilizar vectores de atención de computaciones anteriores. Esta técnica reduce la latencia y el tiempo de respuesta hasta el primer token. Además, un enrutamiento inteligente facilita la reutilización de datos al dirigir solicitudes a instancias de inferencia que ya han procesado un prefijo similar, optimizando así el rendimiento del caché KV.

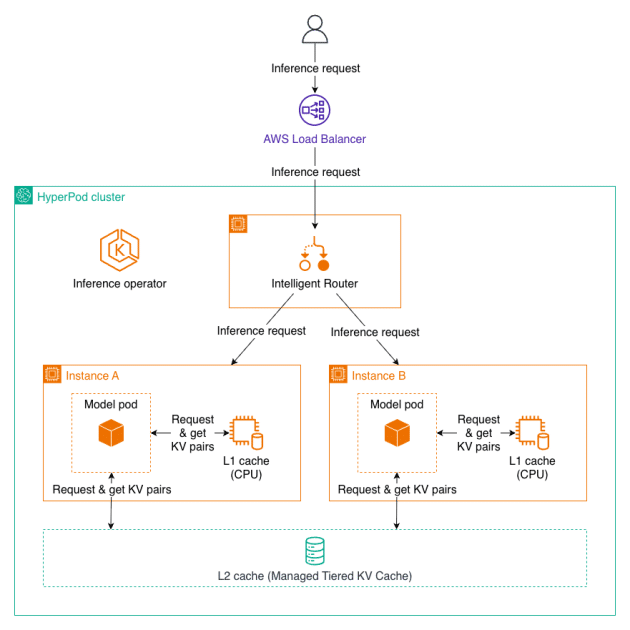

Amazon SageMaker HyperPod ha anunciado ahora que ofrece soporte para capacidades avanzadas de Gestión de Caché de KV en Niveles y Enrutamiento Inteligente a través del Operador de Inferencia de HyperPod. Estas innovaciones prometen velocidades mejoradas, reduciendo hasta en un 40% el tiempo hasta el primer token y disminuyendo los costos computacionales en un 25% para contextos extensos y conversaciones prolongadas.

Estas mejoras no solo maximizan los aciertos del caché, sino que también son cruciales para aplicaciones que manejan documentos largos con contextos repetidos y conversaciones de múltiples turnos. Por ejemplo, en el ámbito legal, se pueden analizar contratos extensos con respuestas instantáneas a preguntas de seguimiento, y los chatbots del sector sanitario pueden mantener conversaciones fluidas en diálogos largos. Además, los sistemas de atención al cliente deben procesar millones de consultas diariamente de manera eficiente y económica.

El sistema introduce la Gestión de Caché de KV en Niveles, que organiza estados de atención mediante memoria CPU y almacenamiento en niveles, además del Enrutamiento Inteligente, que aplica estrategias como el enrutamiento consciente del prefijo y el enrutamiento KV-consciente para aumentar la eficiencia del caché. Asimismo, se añade la integración de observabilidad, permitiendo el seguimiento de métricas a través de Amazon Managed Grafana.

Para implementar estas novedades, es necesario crear un clúster de HyperPod utilizando Amazon EKS y habilitar las nuevas capacidades en los endpoints de inferencia. Con estas mejoras, Amazon continúa estableciéndose como un líder en soluciones de inteligencia artificial escalables en el ámbito global.