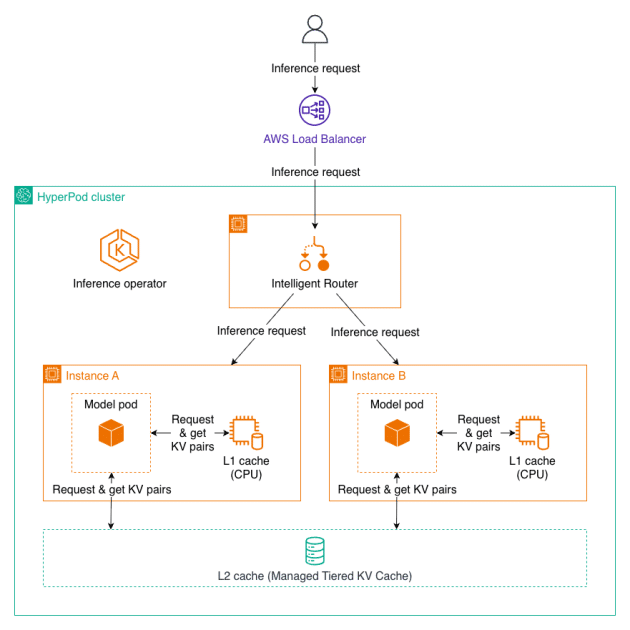

Cacheo Jerárquico Gestionado y Enrutamiento Inteligente para SageMaker HyperPod

En el mundo de la inteligencia artificial, las aplicaciones modernas demandan eficiencias en tiempos de respuesta y costos, especialmente al manejar documentos extensos y mantener interacciones prolongadas. Sin embargo, la inferencia de modelos de lenguaje grande (LLM) enfrenta desafíos a medida que la longitud del contexto se incrementa, lo que resulta en una mayor latencia y costos elevados. Cada nuevo