Los modelos de lenguaje de gran tamaño (LLMs) han progresado notablemente, convirtiéndose en pilares esenciales para aplicaciones que abarcan desde la inteligencia conversacional hasta complejas tareas de razonamiento. Sin embargo, su creciente tamaño y capacidad han dificultado la evaluación efectiva de su rendimiento. Las métricas de evaluación tradicionales, como la perplejidad y los puntajes BLEU, a menudo no logran captar las sutilezas de las interacciones reales. Esto ha resaltado la necesidad de marcos de evaluación que estén alineados con las percepciones humanas, lo cual es crucial para garantizar despliegues confiables y comparaciones justas entre diferentes modelos.

En respuesta a esta necesidad, han surgido métodos de evaluación automatizados que utilizan LLMs como jueces. Este innovador enfoque emplea un LLM más potente para evaluar y clasificar respuestas generadas por otros modelos, basándose en criterios previamente establecidos como corrección, coherencia, utilidad y profundidad del razonamiento. Esta estrategia ha ganado popularidad gracias a su escalabilidad, consistencia y eficiencia en tiempo y costos, superando la tradicional evaluación humana.

Para ofrecer resultados concretos, se han empleado los marcos de evaluación MT-Bench y Arena-Hard. MT-Bench proporciona un enfoque estructurado adaptado a interacciones tipo chatbot, mientras que Arena-Hard se enfoca en clasificar LLMs mediante batallas directas en tareas desafiantes. Ambos marcos buscan harmonizar la evaluación automatizada con la humana, garantizando evaluaciones basadas en casos de uso prácticos y no solo en puntos de referencia sintéticos.

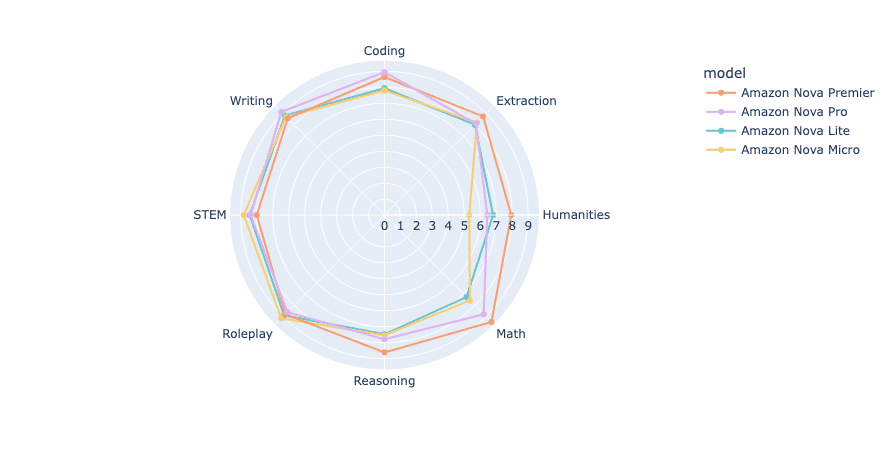

El estudio analizó todos los modelos de la familia Amazon Nova, donde destaca Amazon Nova Premier, el modelo más reciente presentado en AWS re:Invent de diciembre de 2024. Estos modelos están diseñados para ofrecer inteligencia avanzada y costos efectivos. La familia Nova incluye desde Amazon Nova Micro, optimizado para despliegues en el borde, hasta Amazon Nova Premier, enfocado en tareas complejas.

Además, a través del proceso de destilación en Amazon Bedrock, los clientes pueden transferir las capacidades del modelo Nova Premier a modelos más rápidos y económicos como Nova Pro o Nova Lite, ajustados a dominios específicos. Este proceso es accesible mediante la consola de Amazon Bedrock y las API Converse e Invoke.

La evaluación con MT-Bench y Arena-Hard revela una jerarquía clara de rendimiento entre los modelos Nova. Amazon Nova Premier alcanzó el puntaje más alto, seguido por Nova Pro, mientras que Nova Lite y Nova Micro también mostraron resultados satisfactorios. Se destacó que, a pesar de su tamaño, Nova Premier genera respuestas más concisas y eficientes en cuanto al uso de tokens.

Por otra parte, Arena-Hard-Auto, con un conjunto de 500 indicaciones desafiantes, evalúa los LLM mediante comparaciones en pares y aplica un modelo robusto para medir el rendimiento en múltiples categorías de preferencias, proporcionando un análisis más profundo de las capacidades del modelo.

El estudio concluye que los modelos Amazon Nova ofrecen un rendimiento sólido en diversas tareas, manteniendo bajos costos operativos, lo que los convierte en una opción competitiva para empresas que buscan optimizar la eficiencia sin sacrificar la calidad. Esta investigación subraya la importancia de métodos de evaluación efectivos en la elección y despliegue de modelos en aplicaciones del mundo real.