En el competitivo mundo empresarial actual, las compañías enfrentan una presión cada vez mayor para demostrar el retorno de la inversión en sus proyectos de inteligencia artificial (IA). Tanto el aprendizaje automático predictivo como la IA generativa se presentan como herramientas indispensables, sin embargo, solo un porcentaje limitado de estas iniciativas logra llegar a la fase de producción. Específicamente, solo el 54% de los prototipos de aprendizaje automático y apenas un 5% de los casos de uso de IA generativa alcanzan este objetivo crucial. La clave no reside únicamente en llevar los proyectos a producción, sino en asegurar que los modelos sean precisos y eficaces, lo que requiere un sistema escalable, confiable y con alta precisión y baja latencia.

Un área donde la baja latencia resulta crítica es la detección de fraudes. La rapidez en la toma de decisiones es esencial, especialmente en transacciones con tarjetas de crédito, donde el tiempo es un factor determinante. En 2023, las pérdidas por fraude en Estados Unidos superaron los $10 mil millones, lo que representa un aumento del 14% con respecto al año anterior. Se estima que el fraude en el comercio electrónico a nivel mundial podría superar los $343 mil millones para 2027.

Desarrollar una aplicación de IA precisa para mitigar estas pérdidas es un desafío enorme. Los equipos de aprendizaje automático generalmente comienzan este proceso conectando manualmente varios componentes de infraestructura. Lo que puede parecer sencillo al manejar datos por lotes, se convierte en un proyecto mucho más complejo cuando se integran fuentes de datos en tiempo real y de transmisión, requiriendo servicios que deben operar en tiempo real.

Los ingenieros enfrentan el reto de construir y gestionar tuberías de datos, acomodando las variadas necesidades de procesamiento de cada fuente y manteniendo una infraestructura de servicio fiable para las inferencias. Sin herramientas como Tecton, este ecosistema sería complejo y difícil de manejar.

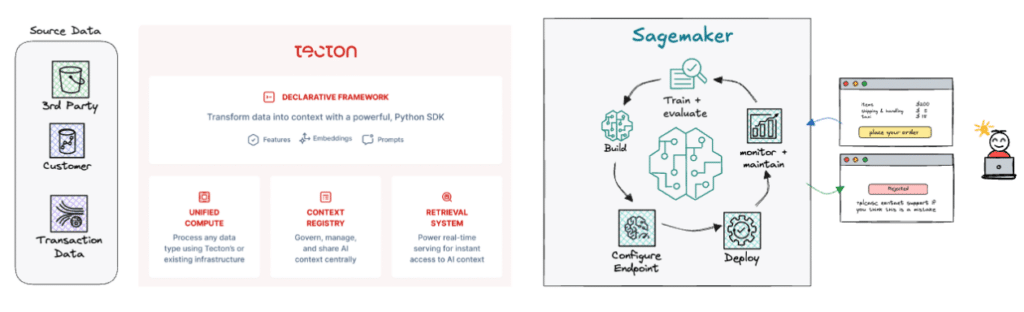

Para aligerar esta carga, Tecton y Amazon SageMaker ofrecen soluciones que reducen el esfuerzo de ingeniería necesario para aplicaciones de IA en producción. Estas herramientas aceleran la creación de valor y permiten a los equipos enfocarse en el desarrollo de nuevas características en lugar de gestionar la infraestructura existente.

Tecton proporciona un marco de trabajo declarativo que facilita la definición de transformaciones necesarias para los modelos, construyendo las tuberías requeridas para calcular, gestionar y servir estas características. Con su integración en almacenes de datos y su soporte de caché en memoria, Tecton garantiza tiempos de respuesta suficientemente rápidos para casos críticos como la detección de fraudes.

La implementación práctica de esta tecnología permite completar un sistema de detección de fraudes, utilizando API de terceros y datos históricos para evaluar la validez de las transacciones con mayor eficacia, respaldados por modelos en SageMaker.

Además, Tecton abre nuevas posibilidades para la IA generativa, integrándose con aplicaciones existentes y ofreciendo experiencias mejoradas, como el uso de modelos de lenguaje de gran escala para el servicio al cliente con información contextual.

En conclusión, Tecton y SageMaker capacitan a los equipos de IA para desplegar aplicaciones de alto rendimiento en tiempo real, aligerando la complejidad de la ingeniería de datos y allanando el camino hacia un valor real mediante la inteligencia artificial.