Las organizaciones que utilizan agentes y sistemas basados en inteligencia artificial están enfrentando desafíos significativos relacionados con la integración y escalabilidad de sus herramientas tecnológicas. Estos retos surgen especialmente al implementar múltiples herramientas, invocar funciones y orquestar complejos flujos de trabajo. La necesidad de un enfoque más estandarizado ha llevado al desarrollo del Protocolo de Contexto del Modelo (MCP), un avance que promete transformar la manera en que se gestionan estos sistemas.

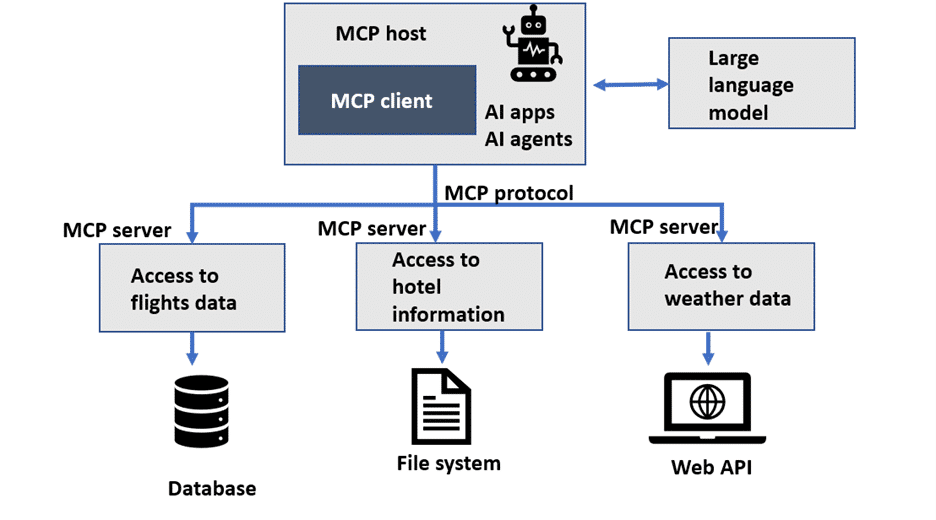

Actualmente, los agentes utilizan llamadas a funciones para interactuar con herramientas externas, como APIs o bases de datos, con el fin de realizar acciones específicas o adquirir información adicional. Sin embargo, esta integración puede complicar el proceso, especialmente cuando se trata de escalar y reutilizar herramientas en toda la organización. Los clientes que buscan implementar agentes a gran escala necesitan una solución uniforme para integrar herramientas, independientemente del marco de orquestación.

El MCP surge como una solución prometedora al estandarizar la manera en que se integran agentes, herramientas y datos, proporcionando una experiencia más coherente y eficiente. Ayuda a los desarrolladores a concentrarse en la selección y uso de herramientas, sin invertir tiempo en construir integraciones personalizadas. Para llevar a cabo esta implementación, es crucial contar con una infraestructura que soporte tanto los servidores como los modelos de lenguaje grande (LLM), que trabajarán en conjunto con las herramientas gestionadas por el MCP.

Amazon SageMaker AI aparece como una opción viable para alojar LLMs, aliviando preocupaciones de escalabilidad y gestión de tareas complejas. Los servidores MCP pueden ser desplegados en diversos entornos de AWS, como Amazon EC2, Amazon ECS, Amazon EKS, y AWS Lambda, lo que ofrece flexibilidad y adaptabilidad a las empresas.

La introducción del MCP representa un avance importante en comparación con las arquitecturas de microservicios tradicionales. Aunque estas proporcionan modularidad, suelen necesitar integraciones separadas y complicadas por servicio. En contraposición, el MCP ofrece una interfaz de comunicación en tiempo real más directa, permitiendo que los sistemas de IA se conecten con facilidad a herramientas externas y fuentes de datos, algo esencial para las aplicaciones IA que requieren acceso seguro a múltiples recursos.

Entre las opciones para implementar servidores MCP, se destacan FastAPI y FastMCP. FastMCP es ideal para desarrollos rápidos y prototipos, mientras que FastAPI brinda una flexibilidad mayor, adecuada para flujos complejos.

Este nuevo enfoque optimiza los procesos de integración de inteligencia artificial, reduciendo la necesidad de integraciones personalizadas y facilitando el mantenimiento. La capacidad de conectar modelos de forma segura a sistemas críticos se vuelve cada vez más valiosa, permitiendo eficientizar operaciones y obtener análisis más detallados. A medida que la tecnología de IA avanza, el MCP junto con SageMaker AI establecen una sólida base para futuras innovaciones.