Los modelos de lenguaje de gran tamaño (LLM) enfrentan un desafío crítico relacionado con su capacidad de memoria. Aunque estos modelos pueden procesar miles de tokens simultáneamente, su habilidad para recordar detalles específicos de conversaciones anteriores es limitada. Este problema se intensifica cuando se les pide razonar sobre eventos pasados o relaciones causales, ya que tienden a ofrecer información que, aunque semánticamente similar, no responde las preguntas de manera directa.

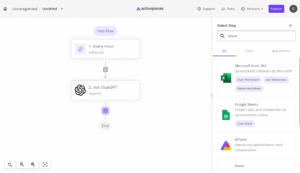

En respuesta a esta limitación, se ha desatado una carrera para desarrollar sistemas de memoria más avanzados para los agentes de inteligencia artificial. Un avance notable ha sido realizado por investigadores de la Universidad de Texas en Dallas y la Universidad de Florida, quienes han introducido MAGMA (Arquitectura de Memoria Agéntica Basada en Múltiples Gráficos). La innovación de MAGMA reside en su enfoque multidimensional para estructurar la memoria, inspirándose en la forma en que los humanos organizan la información.

Los sistemas actuales que utilizan generación aumentada por memoria funcionan como un armario de archivos sofisticado, almacenando y recuperando interacciones basadas en similitudes semánticas. No obstante, este método resulta ineficaz cuando es necesario razonar sobre las relaciones entre eventos, causando confusión en las respuestas.

MAGMA aborda este problema utilizando cuatro gráficos conectados pero distintos. El gráfico temporal establece una cronología inmutable de eventos, el gráfico causal muestra las relaciones de causa y efecto, el gráfico de entidades rastrea personas y objetos en el tiempo, y el gráfico semántico se centra en la similitud conceptual. Esta estructura permite que MAGMA navegue eficientemente a través de un complejo entramado de memorias.

Una característica destacable de MAGMA es su capacidad de adaptar su estrategia de recuperación según el tipo de pregunta. Clasifica la intención del usuario y ajusta su enfoque, priorizando, por ejemplo, las relaciones causales en preguntas que así lo requieren o centrándose en la cronología para cuestiones temporales.

Los resultados preliminares han sido prometedores. En el benchmark LoCoMo, MAGMA alcanzó una tasa de precisión del 70%, superando a los sistemas más avanzados por un margen considerable. Su arquitectura de doble vía permite una memoria ágil que actualiza información sin alterar el flujo conversacional.

A medida que nos dirigimos hacia un futuro con agentes de IA más sofisticados, MAGMA representa un cambio significativo en nuestra concepción y construcción de sistemas de memoria en inteligencia artificial. Con esta tecnología, los agentes podrían mantener coherencia en sus identidades, explicar razonamientos con claridad y abordar preguntas complejas que desafían a los modelos actuales. Sin embargo, los investigadores destacan que la calidad de las inferencias causales aún depende de las capacidades de razonamiento del modelo LLM subyacente, lo que complica su implementación. Por lo tanto, la cuestión crucial ya no es si los agentes de inteligencia artificial necesitan una mejor memoria, sino si estamos preparados para desarrollarla adecuadamente. vía: AI Accelerator Institute.