En el ámbito de la inteligencia artificial, el ajuste fino de modelos base se ha convertido en un proceso crucial para mejorar la capacidad de comprensión de los sistemas y proporcionar resultados precisos en diversos dominios. Un reciente experimento ha destacado este enfoque utilizando Amazon SageMaker Autopilot y el SDK AutoMLV2 para afinar el modelo Meta Llama2-7B en tareas de respuesta a preguntas, enfocándose especialmente en exámenes de ciencias que incluyen disciplinas como física, química y biología.

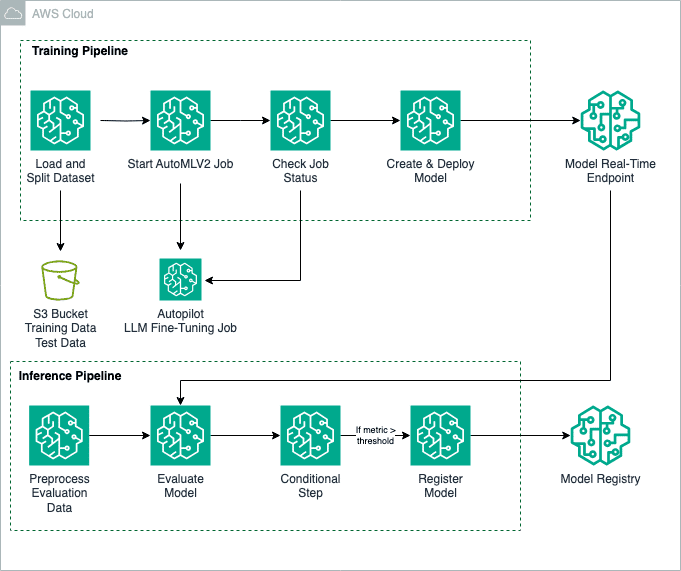

Este avance no se limita únicamente a la respuesta a preguntas, sino que también puede aplicarse a otras áreas como la generación de resúmenes o la producción de textos en sectores como la atención médica, la educación y los servicios financieros. La funcionalidad de AutoMLV2 permite personalizar una variedad de modelos mediante Amazon SageMaker JumpStart, y Amazon SageMaker Pipelines automatiza todo el flujo de trabajo, desde la preparación de datos hasta el ajuste fino y la creación del modelo.

El método emplea el conjunto de datos SciQ, un recurso que ofrece preguntas de examen en el ámbito de las ciencias, para entrenar el modelo Llama2-7B. Los datos se preparan para ser compatibles con SageMaker Autopilot, organizándolos en archivos CSV que clasifican las preguntas como entradas y las respuestas correctas como salidas.

La configuración del ajuste fino implica establecer una serie de parámetros, como el nombre del modelo base, la aceptación de los contratos de licencia de usuario final, y otros hiperparámetros que optimizan el aprendizaje del modelo, tales como el número de épocas y la tasa de aprendizaje. Estos ajustes garantizan que el entrenamiento del modelo se adapte a las necesidades específicas del problema planteado.

Una vez que el modelo ha sido afinado, se despliega en un punto de inferencia en tiempo real, lo que permite obtener resultados de manera instantánea. La evaluación de estos modelos se realiza mediante la biblioteca fmeval, que proporciona una revisión detallada basada en métricas personalizadas, asegurando que el modelo funcione adecuadamente en situaciones reales.

Este enfoque no solo mejora la precisión en el desempeño del modelo sino que también optimiza el proceso de implementación y evaluación, simplificando considerablemente el despliegue de modelos en entornos de producción. Además, se instaura un control de calidad a través de la evaluación de métricas de rendimiento, asegurando que solo los modelos de alto rendimiento sean registrados y utilizados en aplicaciones prácticas.

En resumen, este flujo automatizado representa un avance significativo hacia la implementación eficiente de modelos de lenguaje de gran escala, facilitando una integración más fluida en sistemas que exigen inferencias en tiempo real con alta precisión y relevancia.