En el actual panorama tecnológico, los modelos de inteligencia artificial generativa se enfrentan a desafíos sin precedentes en cuanto a la escala computacional necesaria para su preentrenamiento. Estos modelos fundamentales, o Foundation Models (FMs), requieren con frecuencia miles de aceleradores trabajando de manera continua durante largos periodos. La gestión de esta complejidad se realiza mediante clústeres de entrenamiento distribuidos, indispensables para soportar estas cargas computacionales intensivas. Estos clústeres utilizan instancias de computación acelerada junto a marcos como PyTorch para paralelizar eficientemente el trabajo, empleando chips como AWS Trainium e Inferentia, además de GPUs de NVIDIA.

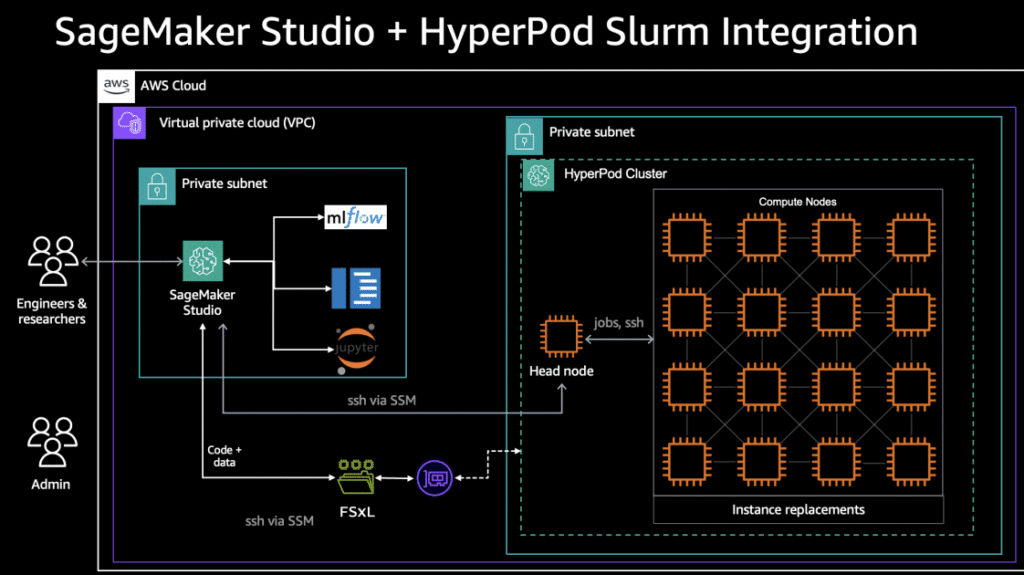

La coordinación de los clústeres se lleva a cabo mediante orquestadores como SLURM y Kubernetes, herramientas responsables de programar trabajos entre nodos y gestionar los recursos necesarios. La infraestructura de AWS, compuesta por elementos como Amazon Elastic Compute Cloud (EC2) y Amazon Elastic File System (EFS), es clave para crear ultra clústeres capaces de manejar entrenamiento e inferencia de aprendizaje automático a gran escala. No obstante, a pesar de su robustez, estos sistemas enfrentan retos de resiliencia: cualquier fallo en un nodo puede interrumpir el trabajo sincronizado.

La experiencia del desarrollador es otro factor crítico en este entorno desafiante. Los flujos de trabajo tradicionales en aprendizaje automático tienden a crear silos, lo que complica la integración entre los ambientes de desarrollo y producción y lleva a un uso ineficiente de los recursos.

Para enfrentar estas dificultades, Amazon ha presentado SageMaker HyperPod, un entorno diseñado para el entrenamiento a gran escala de modelos fundamentales. Este sistema contiene agentes de monitoreo que, al identificar fallos de hardware, gestionan la reparación o reemplazo de instancias defectuosas y reanudan el entrenamiento desde donde fue interrumpido, reduciendo así la necesidad de intervención manual.

Asimismo, Amazon ha lanzado SageMaker Studio, un entorno de desarrollo integrado que simplifica el ciclo de vida del aprendizaje automático a través de una interfaz web unificada. Este espacio permite a los científicos de datos realizar tareas desde la preparación de datos hasta la implementación, todo en un mismo lugar, eliminando barreras entre desarrollo y producción.

La flexibilidad de SageMaker Studio se ve respaldada por sistemas de archivos distribuidos como Amazon FSx para Lustre, proporcionando un almacenamiento escalable y de alto rendimiento. Esto permite una integración fluida con SageMaker HyperPod, mejorando la productividad mediante un flujo de trabajo continuo.

A medida que estas tecnologías se consolidan, se impulsa a la industria del aprendizaje automático hacia una mayor agilidad y eficiencia. Esto permite a los científicos de datos centrarse en innovar y mejorar modelos, mientras los servicios en la nube gestionan los aspectos técnicos. SageMaker HyperPod y SageMaker Studio representan significativos avances hacia el éxito en operaciones a gran escala de inteligencia artificial.