En el ámbito de las aplicaciones de inteligencia artificial generativa, la rapidez en la respuesta se ha vuelto tan crucial como la inteligencia propia del modelo. Desde equipos de servicio al cliente que manejan consultas urgentes hasta desarrolladores que requieren sugerencias de código al instante, cada segundo de retraso, conocido como latencia, puede afectar significativamente la operatividad. A medida que las empresas adoptan modelos de lenguaje de gran tamaño (LLMs) para llevar a cabo tareas críticas, surge un desafío fundamental: cómo mantener un rendimiento ágil que cumpla con las expectativas de los usuarios sin sacrificar la calidad de los resultados esperados de estos sofisticados modelos.

La latencia influye en la experiencia del usuario más allá de ser una simple molestia. En aplicaciones interactivas de IA, las respuestas retrasadas pueden interrumpir el flujo natural de la conversación, disminuir la participación del usuario y, en última instancia, afectar la adopción de soluciones impulsadas por inteligencia artificial. Esta problemática se agudiza por la creciente complejidad de las modernas aplicaciones de LLM, donde a menudo son necesarios múltiples llamados a los modelos para resolver un solo problema, lo que aumenta considerablemente el tiempo total de procesamiento.

Durante el evento re:Invent 2024, se presentó una nueva función de inferencia optimizada para la latencia en los modelos de fundación dentro de Amazon Bedrock. Esta funcionalidad ofrece una disminución en la latencia para el modelo Claude 3.5 Haiku de Anthropic y los modelos Llama 3.1 de Meta, en comparación con sus versiones estándar. Esta característica resulta especialmente útil para cargas de trabajo sensibles al tiempo, donde una respuesta rápida es crítica para el negocio.

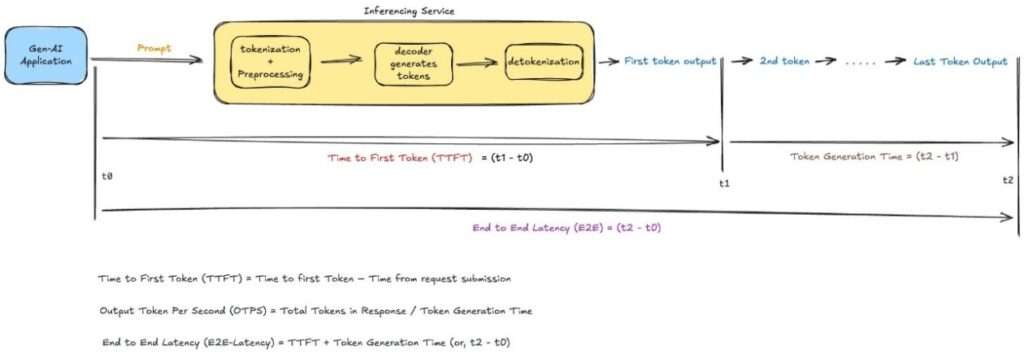

La optimización de la latencia se enfoca en ofrecer una mejor experiencia de usuario en aplicaciones que utilizan LLMs. La latencia en estas aplicaciones se considera un concepto multifacético que abarca aspectos como el tiempo hasta el primer token (TTFT), que indica la rapidez con que la aplicación comienza a responder tras recibir una consulta.